近年来,随着人工智能技术的不断进步,开放源码大型语言模型(LLM)的发展日新月异。相比以往依赖云端服务提供商的封闭模型,自建私有的OpenAI兼容LLM环境,逐渐成为企业和开发者追求数据隐私、控制权以及定制化应用的理想选择。Google Cloud Run作为一种无服务器计算平台,为此类部署提供了极大便利,尤其是在配备GPU支持的前提下,实现了高性能与便捷管理的有机结合。本文将全面详解如何在Google Cloud Run上搭建私有的OpenAI兼容大型语言模型,让您以最简洁的方式完成部署,享受私密高效的AI服务。 首先,为什么要选择私有部署大型语言模型?市面上的主流大语言模型诸如OpenAI的GPT系列虽然功能强大,但往往需要通过云端接口调用,存在数据传输泄露风险,且灵活度受限。采用开源模型并搭建私有推理服务,能让用户自主掌控模型接口与数据交互过程,消除中间环节的隐患。

此外,近几年开源模型如DeepSeek、Qwen等在推理能力上与闭源顶尖模型差距逐渐缩小,功能全面支持诸如函数调用与结构化输出,满足多数实际应用场景需求。 Google Cloud Run支持无服务器容器部署,具备自动弹性伸缩功能,并且最近正式推出了对GPU的支持,极大增强了计算能力。通过Cloud Run部署LLM,用户无需自行管理底层服务器,且可按需扩展,避免资源浪费和维护负担,堪称理想的私有AI推理平台选择。 准备工作中首先要完成Google Cloud项目的创建及计费开启,因为GPU资源暂未纳入免费额度。随后需启用Artifact Registry、Cloud Build、Cloud Run及Cloud Storage等必要API接口。此外,由于GPU配额需要申请,有必要根据目标区域提交配额申请,部分区域如欧洲西部(europe-west1)表现相对稳定且价格适中。

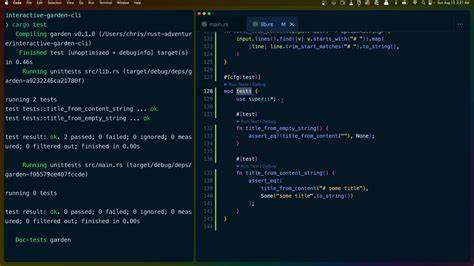

除了配额外,还需针对项目配置合理的IAM权限,包括artifactregistry管理、cloudbuild编辑、cloudrun管理员、iam服务账户等角色,保证自动化部署流程能够顺利执行。 完成前期准备后,可以克隆相关开源仓库代码,这是基于Google官方示例扩展而成,新增了轻量级代理服务器,专门负责认证管理并将请求转发至运行在同一实例中的Ollama服务。本项目支持从Ollama模型注册表选取多款开源模型进行部署,如DeepSeek、Gemma、Qwen等,但需留意Cloud Run的限制导致不能部署过于庞大的模型。 用户需将环境配置文件.env.example重命名为.env,并生成一个足够复杂的API密钥,配置于API_KEYS字段以实现接口访问控制。安装Google Cloud SDK并切换至所选项目和区域,确保部署命令使用正确配置。部署时需要指定CPU核心数、内存大小、GPU数量以及模型并行度等参数以匹配模型需求与服务响应性能。

部署操作通常较耗时,其中模型权重随容器镜像打包上传,完成后会在终端输出可访问的服务URL。 启动后的推理接口与OpenAI标准API极为相似,支持OpenAI官方Python SDK、JavaScript SDK以及LangChain框架的无缝对接。调用接口时只需使用私有API密钥及刚刚部署的服务地址,即可实现文本生成、对话回复、函数调用等前沿功能,且具备较低延迟与高隐私性。借助LangChain等流程引擎,更能方便地构建复杂代理机器人、多步任务执行及工具调用。 在延迟方面,由于Cloud Run是无服务器模式,当长时间无访问时会进入冷启动状态,首次请求可能会有额外的响应等待时间。为降低影响,可考虑合理的实例保活策略或选用资源更充足的配置提升热启动速度。

在模型选择与定制层面,基础配置默认运行Qwen 3的14B参数版本,其推理速度约为每秒20至25个输出token,适合大部分中高复杂度应用。用户也可根据斯需求切换至Gemma 3(4B参数)或DeepSeek-R1(14B参数无函数调用功能),调整Dockerfile中MODEL环境变量实现多样化适配。如此一来,可以在模型性能和实时响应之间做出权衡,满足具体业务场景需求。 整体来看,利用Google Cloud Run搭建私有OpenAI兼容的LLM推理端点,既节省了运营成本和维护工作,又将数据安全隐私掌握于自己手中。用户可依托开源模型生态快速迭代升级,不受制于云端服务商策略变化,适合企业、研究学者、开发者等多样化群体。未来随着GPU资源的进一步普及及开源模型性能提升,私有部署的模式将更为普遍,为实现具有高度自主主权的智能应用奠定坚实基础。

在正式开始部署之前,建议读者详细阅读Google官方Cloud Run及Ollama文档,确保对云资源、容器技术和模型原理有所了解。此外,关注社区动态和开源项目更新,对维护及升级私有模型服务至关重要。通过持续优化API密钥管理、容器构建流程以及模型选择,能够保障私有LLM服务高效、稳定且安全运行。 总之,在Google Cloud Run上部署私有OpenAI兼容大型语言模型,是实现安全、灵活、可扩展AI服务的理想路径。掌握部署流程并结合自身需求灵活定制,能让企业与开发者赢得人工智能时代的核心竞争优势,打造真正属于自己的智能交互利器。