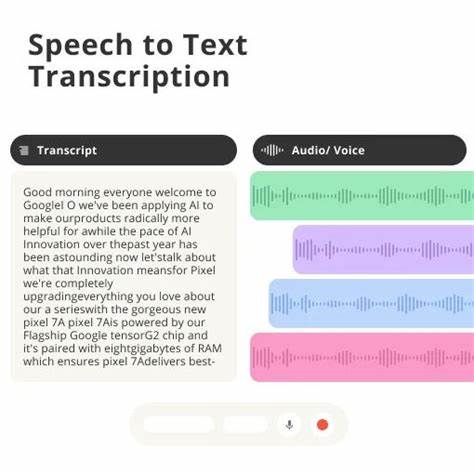

随着移动应用对语音交互需求的持续增长,语音转录技术已成为提升用户体验的关键组成部分。尤其是在苹果生态系统中,SwiftUI作为现代声明式UI框架,与本地语音转录功能结合的潜力巨大。然而,开发者在实际应用过程中经常遇到诸多挑战,例如识别准确率不理想、资源消耗高、延迟明显等问题。本文将深入探讨在SwiftUI环境下如何实现高效且可靠的本地语音转录解决方案,分析主流技术架构,评估框架特点,并分享优化路径,助力开发者提升应用竞争力。首先,从技术选型的角度来看,苹果官方提供的SFSpeechRecognizer是一种常用手段,它基于系统级的语音识别服务,大多数情况下通过联网访问云端识别引擎,能够较好地兼顾识别准确率和用户体验。但对于希望实现完全本地化处理、避免数据隐私风险或在无网络环境下工作的产品,SFSpeechRecognizer存在一定局限,特别是其对资源的依赖和有限的定制能力成为瓶颈。

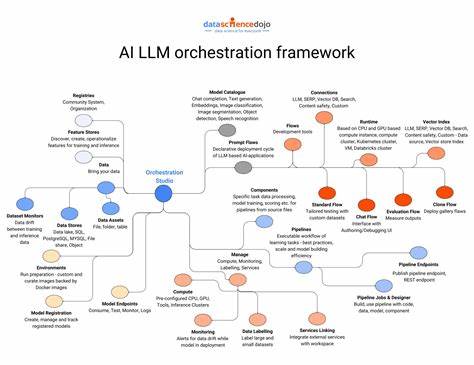

近年来,开源语音识别项目如Vosk、WhisperKit等逐渐被关注,尤其是Vosk以其支持离线识别且跨平台特性受到青睐。Vosk基于深度神经网络,支持多种语言模型,并且通过WebAssembly(WASM)实现浏览器下的高性能运行,这使得开发者能够构建无需连网的高效本地转录系统。WhisperKit是基于OpenAI开源模型的封装方案,理论上提供了较为全面的识别能力,但实际运行性能和资源消耗在不同设备上表现不一,特别是在移动端时常受到性能限制的影响。由于SwiftUI主要负责视图层构建,本地语音转录核心逻辑常常依赖于底层的Objective-C或Swift库,甚至需要调用第三方跨平台库进行模型推理。开发者在集成过程中面临的主要问题是如何优化模型大小与运行速度的平衡,以及如何优雅地将异步识别结果与SwiftUI的状态管理系统结合,实现界面响应的流畅更新。在实际项目中,部分开发者反馈使用SFSpeechRecognizer时遇到识别延迟和准确率波动,切换到WhisperKit虽然在尝试走纯本地路线,但性能和稳定性未达到预期,可能源于模型体积大、算力需求高,以及对硬件兼容性的限制。

结合社区经验,充分利用Vosk的轻量级特性和WASM版本提供的跨平台支持,可以显著改善这一问题。为了实现更完美的本地语音转录体验,建议开发者关注模型参数的优化与硬件适配。精简语言模型、限制词汇范围、使用量化模型等手段均能有效降低内存占用和计算负载。同时,借助SwiftUI的Combine框架或异步/等待机制管理状态更新,可以避免UI卡顿,保证用户交互顺畅。此外,为了防止数据泄露及保护用户隐私,本地转录优势明显,特别适合医疗、法律等行业应用。因此,打造一套稳定、准确且安全的本地语音处理方案是未来发展的趋势。

推荐开发者持续关注官方API更新和开源社区动态,积极参与相关讨论,分享实践心得,推动技术迭代优化。值得一提的是,苹果公司未来可能进一步完善对本地语音识别的支持,尤其是在机器学习框架如Core ML与神经网络加速器的加成下,开发者可以期待更加高效且易用的本地语音转录工具。同时,针对多语言、多方言识别的需求,适配扩展模型实现更广泛的覆盖也将成为重要方向。总结来看,虽然目前SwiftUI与本地语音转录的结合还存在一定技术门槛,但通过合理的工具选择、模型优化及架构设计,完全可以打造出符合商业需求的高质量应用。掌握核心技术特性,充分利用社区资源,注重用户体验和隐私保护,将成为助力开发者突破瓶颈的关键。未来随着软硬件技术的不断升级,本地语音转录在SwiftUI中集成的最佳实践将更加成熟,开发者也将获得更多创新空间和更强的技术保障。

。