近年来,随着软件规模的快速增长和复杂度的提升,链接器的性能需求日益增强。作为链接领域的重要工具,Mold从诞生之初便以其卓越的速度和高效的资源利用率赢得了广大开发者的认可。2025年6月,Mold发布了2.40.1版本,继续在性能优化上实现突破,尤其引入了由人工智能ChatGPT生成的新算法,为链接器行业带来了全新的技术范式和思路。 Mold 2.40.1版本的最大亮点之一是取消了此前调试节(section)压缩过程中的不必要内存零初始化步骤。利用"--compress-debug-sections"选项,压缩调试节的效率大幅提升。这不仅缩短了文件输入输出操作的时间,还反过来使得该压缩功能的执行速度甚至超过了不启用该选项时的性能。

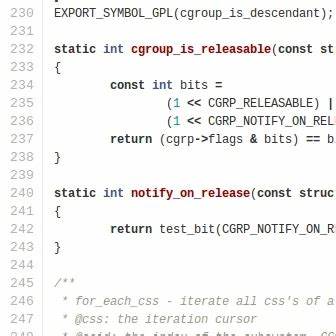

针对拥有约5GB调试信息的可执行文件,在搭载AMD Ryzen Threadripper 7980X处理器的系统环境中,Mold开发团队测试表明这一优化能够减少约1.2秒的链接时间。如此显著的时间节约,对于大型项目的编译流程来说,无疑是极具意义的。 另一个技术创新重点在于引入了一种全新的多重glob模式匹配算法。传统的glob模式匹配算法通常采用非确定性有限自动机(NFA)转为确定性有限自动机(DFA)的经典算法,但该方法在复杂的模式匹配中往往呈指数级时间复杂度,严重影响性能。Mold 2.40.1实现了线性时间复杂度的glob匹配方案,大幅提升了多模式匹配的效率和可扩展性。 令人关注的是,这一全新算法并非完全集中依靠人类工程师的设计完成。

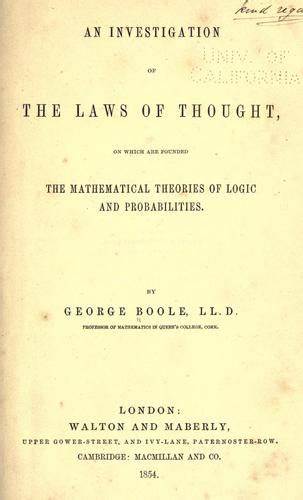

据Mold的主开发者Rui Ueyama介绍,他在设计多重glob匹配算法时借助了ChatGPT的智能辅助。通过与ChatGPT的对话,获得了基于位向量(bitvector)的NFA模拟算法建议,这一创新思路令他印象深刻,也弥补了自身在该领域知识的盲点。此举标志着AI辅助开发已逐步走入核心工具链的研发过程中,开启了人机协作的新篇章。 ChatGPT提出的基于位向量的多重glob模式匹配算法采用了高效的状态表示和并行模拟策略,避免了传统NFA到DFA转换时状态爆炸的困扰。利用机器字的并行处理能力,实现了状态的快速更新,使得算法能够线性扫描输入字符串同时匹配多个模式。该方法不仅提升了匹配速度,也降低了内存开销,极大契合了链接器对高性能和低资源消耗的极端需求。

此次Mold更新背后体现的是AI在软件开发流程中的潜力与趋势。传统上,编译器和链接器的关键算法依赖资深开发者的精心设计与优化,过程繁琐且创新难度大。而ChatGPT及类似AI系统的出现,为复杂算法的探索和验证提供了新的途径。这不仅提升了开发效率,也推动了计算机科学领域算法创新的民主化,使得开发者能够聚焦于实际应用需求与架构优化,更快速地完成高质量代码生产。 Mold 2.40.1的性能提升将直接影响整个软件构建环节,尤其是在大型项目、操作系统内核及嵌入式系统开发中意义非凡。链接阶段作为编译流水线的瓶颈之一,其加速将缩短开发周期,提高频繁构建的响应速度,进一步提升软件迭代效率。

开发者和企业能够从中受益,更快地交付稳定且高性能的软件产品。 除此之外,Mold的持续优化与创新也展示了开源社区的活力。Rui Ueyama和参与贡献的开发者们秉持开放共享精神,不断完善代码,推动工具链生态的演进。GitHub上的实时更新及公开讨论,为各类开发者提供了便捷的学习与参与平台,助力行业整体技术水平的提升。 从更广义的角度看,Mold 2.40.1的发布体现了人工智能与传统系统软件深度融合的趋势。未来我们有望看到更多关键系统组件引入AI辅助设计,实现低耗高效的系统级优化。

借助AI强大的数据处理和创新能力,软件开发自动化与智能化水平将大幅提升,开发者的创造力也将被极大释放。 对于开发者来说,理解和利用这一全新版本的改进,将助力其项目构建效率的显著提升。建议学习和熟悉Mold 2.40.1的详细功能及参数配置,如"--compress-debug-sections"等选项的合理使用方法。在链接大型程序或涉及大量调试信息时,应优先尝试启用相关优化,以获得最佳构建性能。 综合来看,Mold 2.40.1不仅仅是一款链接器工具的简单升级,更是高性能软件构建领域的一次技术革命。它成功将人工智能应用于核心算法设计,开拓了人机智能协同的新方向。

未来,随着AI技术的不断成熟与普及,高效、智能的编译器和链接器体系将成为推动软件行业进步的重要力量。 随着软件规模和复杂性的持续扩张,对工具链工具性能的需求日益紧迫。Mold 2.40.1通过引入AI辅助算法设计,向开发者展示了如何突破传统算法瓶颈,实现更快更优的软件构建。这不仅提升了开发效率,也为现代软件生态的持续繁荣提供了坚实技术保障。期待在未来版本中,Mold能够融合更多前沿技术与创新,为全球开发者带来更加卓越的构建体验和卓越性能。