在科技快速发展的今天,人工智能模型不断涌现,催生了各种高性能硬件的广泛应用。然而,有趣的是,一些开发者试图将这些先进的AI模型移植至历史悠久的复古计算机上,带来跨时代的震撼体验。Llama2.c64正是这样一个令人惊叹的项目,它将流行的Llama2模型成功地移植到了曾经风靡一时的Commodore C64上。这个项目令人耳目一新,不仅让人们重新审视了复古硬件的潜力,也展示了深度学习模型在极端受限环境中的灵活适应力。 Commodore C64作为上世纪80年代极具代表性的家用计算机,拥有64KB的内存与低频率的处理器,硬件性能与当代计算设备相比显得极其有限。尽管如此,该项目通过巧妙利用扩展设备——至少2MB的RAM Expansion Unit(REU),突破了内存瓶颈,为运行现代神经网络模型铺平了道路。

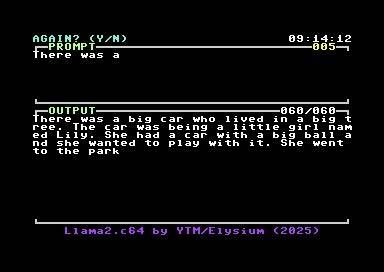

Llama2.c64采用了Llama2模型家族中的260K tinystories微型模型,这是一种针对存储和计算能力有限平台优化的短故事生成模型。 该项目并非设计为聊天机器人,而是倾向于故事续写类型,类似于让一个三岁儿童在听到故事开头后,根据有限词汇继续进行讲述。这种设定非常符合模型源于的TinyStories数据集,专为儿童语言特点量身定制。用户可以输入故事起始句,系统会基于训练学到的语言模式生动地续写故事,展现出一种复古设备实现现代自然语言生成技术的奇妙对话。 Llama2.c64的运行依赖于特定软硬件配置。在仿真环境VICE中,需要启用REU设置,确保REU容量至少为2MB,且加载预先处理好的权重文件weights.reu。

通过设置虚拟机的相应参数并启用warp模式,能够有效加速模型推断过程,提高用户体验。在实物硬件如Ultimate II+扩展卡环境中,同样需启用REU功能,并导入相应权重文件,再启动主程序实现推断。 项目包含完整的构建与测试支持,使用Makefile简化编译流程。只需运行指定命令,便能自动生成模型权重与配置文件并编译生成可执行程序。该流程极大地方便了开发者复制、调试与优化,推动Llama2.c64的持续完善。对于希望体验或修改代码的爱好者来说,这无疑是极具吸引力的亮点。

技术细节方面,Llama2.c64巧妙地将模型中的tokenizer及其编码部分压缩进C64的主内存,而体积庞大的模型权重数据则全部存储在REU中。这样有效分配有限资源,使得计算过程得以顺利进行。此外,专门编写的数学库包含自定义的三角函数和指数函数,保证了计算精度,且部分数学多项式直接源自C64 BASIC ROM,确保了与原生环境的兼容性。 从性能角度看,由于C64的硬件自身限制,执行速度并不快。生成每个输出token平均需要约8分钟,首个输出token更需约16分钟后才能显现,整过程节奏缓慢但别有韵味。计算复杂度随着生成token数量递增而提升,模型运行变得愈加耗时。

这种“慢体验”恰恰成为其独特魅力之一,使得用户在等待结果的过程中,能够细细品味人工智能与复古科技间产生的奇妙互动。 Llama2.c64项目在社区内获得了广泛关注,收获了不少星标与派生分支。例如开发者尝试引入基于查表的快速浮点乘法以提升速度,尽管实际效果不及预期,却为后续模型量化和性能优化打开了思路。另一分支则专注于丰富调试信息和结构数据打印,助力对比验证与模型精确复现。项目开放的架构鼓励更多贡献者参与进来,未来或将引入量化模型支持以及更多数据集的适配。 安全与隐私方面,Llama2.c64的离线运行模式确保了所有用户输入数据均在本地计算,无需将信息上传至云端服务器。

这样既避免了隐私泄漏风险,又让用户真正实现对AI推理过程的掌控。同时,低功耗特点使得该方案具备绿色环保优势,即使在连续长时间运行下,电能消耗极其有限。 尽管如此,Llama2.c64非聊天模型的限制令其交互方式较为单一,更多倾向于故事创作而非复杂对话。另外,2MB及以上的REU是运行必需硬件,且内存理论峰值约8MB上下,对较大模型尚无兼容空间。硬件配置门槛及推断速度瓶颈使其更适合对性能要求不高的实验与教育场景,而非商业级应用。 总结来看,Llama2.c64实现了在一款传奇复古计算机上运行现代文本生成AI的壮举,见证了软件与硬件极限探索的魅力。

这一项目不仅为计算机历史爱好者和AI开发者提供了创新平台,也展示了人工智能广泛适应性和跨时代传承的可能性。未来,类似项目或许能进一步推动更多边缘设备上的智能推断,丰富AI生态的多样化形态。 对于广大科技爱好者而言,Llama2.c64是一面映射过去与未来的镜子,昭示着即使是看似落后的技术设备,也能焕发出新生的光彩。它激励开发者们在资源受限条件中锤炼创新能力,使AI技术真正做到全面普及并深入人心。随着软硬件结合创新不断涌现,复古与现代技术的碰撞将持续带来令人惊喜的突破,赋予传统计算机全新生命与意义。