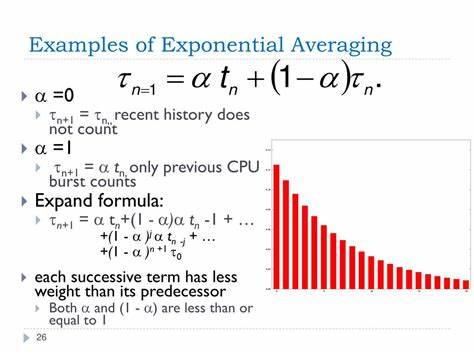

指数加权平均(Exponential Weighted Moving Average,EWMA)是一种广泛应用于系统行为统计与信号平滑处理的算法。其核心思想是通过对新数据与历史数据按照一定比重进行加权,实现对最近数据的响应更为敏感,同时减少对旧数据的影响。该算法简洁且内存消耗极低,因而在网络协议调整、监测系统和各类实时信号分析中获得了极高关注。然而,传统的指数加权平均算法并非完美无缺,尤其在数据采样存在不规则或中断的情况下表现出明显缺陷。本文将深入探讨1998年由约翰·C·冈瑟(John C. Gunther)提出的"不连续指数加权平均"方法,以及它如何针对传统算法的不足加以修正,提高了对真实数据环境的适应性。 传统指数加权平均算法的本质在于以固定的权重因子递减过去数据的影响力,并用当前数据以互补权重进行更新。

具体实施时,通常设定一个平滑参数alpha,0到1之间:较接近1的值意味着历史数据影响更持久,较接近0则意味着当前数据更具主导权重。这种简单的设定保证了极低的计算成本和无需存储过往采样点的优势,但也带来了两大核心问题。 首先,初始时刻的平均值存在偏差。因为算法开始时首个数据点的权重被设定为1,相当于为这个数据点赋予了之前未采集数据的权重。这种处理方法使得初期平均值往往高度依赖于一个数据点,造成所谓的"启动瞬态"现象,即初期估算偏态且波动较大。随着数据点逐步增多,该影响会缓慢淡化,但在实际应用中尤其对长窗口平均计算,这种偏差会严重影响结果的稳定性和可信度。

其次,也是更为隐蔽的问题是权重递减只是基于更新次数而非真实的时间间隔。传统方法在假设等时间间隔采样的前提下表现正常,然而,若采样过程中出现不规则的时间间隔或数据丢失,算法则会错误地对历史数据赋予不合时宜的权重,导致旧数据被过度重视。这就像一个睡眠了很长时间的"沉睡者"突然被认为是刚刚被采集到的数据,造成了对系统状态的错误判断。这种时间权重错配的缺陷,在现代网络传感器数据频繁间断、采样时间不均匀的环境尤其突出。 为了解决上述问题,冈瑟提出了"权重按时间指数衰减"的修正方法。核心改变是将权重的衰减因子alpha提升为时间间隔的指数幂次,即权重减少量根据实际经过的时间间隔动态调整,而不再是固定一次更新的权重。

这就意味着如果数据点之间间隔较长,历史数据权重将大幅降低,新数据权重自然提升,极大地提高了算法对不规则采样和断续数据的鲁棒性。此改进让算法更符合实际业务对时间因素敏感性的需求,避免了传统算法因过度均匀采样假设带来的偏差风险。 值得注意的是,单纯基于这种时间调整仍存在另一个潜在风险:当遇到较长时间间隔后首次采集新数据时,新数据权重大幅上升,造成对单个数据点的过度依赖,进而产生波动过大的初始偏差。为此,冈瑟再度引入了"新数据权重上限"概念,即通过设定一个最大时间差参数(maxDt)来限定单个新数据的最大贡献权重,从而抑制突发数据强烈拉偏平均值的现象。这个参数根据具体应用场景选取,比如对于变化缓慢的环境,maxDt可以设定较大值保障平滑性;对于噪声较多且动态剧烈的环境,则应缩小maxDt,快速响应信号变化。 这一加权上限策略同时伴随着对总权重的独立追踪,不再保证权重和恒为1,取而代之的是权重之和逐渐逼近1。

这样设计的好处是能够反映数据完整性,提供"完整性分数"(completeness fraction),即当前加权平均实际依赖数据的程度。该指标在实际性能监控和控制系统中尤为重要,因为它帮助判别所计算平均值的统计可靠性与代表性,避免基于数据稀缺阶段做出错误决策。 此外,对平方数据加权求和的引入进一步丰富了算法功能,使其不仅可计算加权平均,还能快速计算加权方差和标准差,有效评估数据的波动范围与稳定程度。基于这些统计指标,用户甚至可以利用该算法实现基础的"分段线性回归"或"指数加权回归分析",通过维护加权的乘积和,支持更复杂的拟合模型,如线性斜率与截距的估算,使算法的适应范围超越简单的平滑处理,广泛应用于预测建模和异常检测领域。 从算法实现角度看,不连续指数加权平均算法核心仍以递归更新的形式完成,无需保存所有历史数据,实现高效的实时计算。每次更新过程中,通过计算权重递减因子与限制权重上线,动态调整历史数据与新数据比重,从而提升了在多任务、异步或者断续采样数据环境下的稳定性。

此类设计理念非常适用于网络数据流质量评估、环境监测仪器读取、金融交易数据预处理等对时间分布敏感而数据不连续的应用场景。 面对如今物联网设备快速普及和异构数据源大量涌现的趋势,数据采集的均匀性极难保证。不连续指数加权平均算法的新颖设计恰恰提供了一种平衡数据完整性与响应灵活性的解决方案。通过参数可调节的权重限制,用户能够根据特定时间尺度和系统动态特征灵活配置,使得该算法可在保证统计稳健性的同时,保持对系统最新变化的快速响应能力。与传统指数平滑算法相比,其鲁棒性和准确性均有显著提升。 尽管该方法在实际应用中优势明显,但仍需注意其适用前提与限制。

例如,maxDt参数选取需要结合领域知识和数据特征,否则可能引发权重过度收缩或响应迟滞;此外,在极端非均匀采样或者数据异常剧烈波动时,单纯依赖该算法可能无法满足精细化建模需求,需要结合其他信号处理或机器学习技术进行多模态融合分析。 展望未来,不连续指数加权平均的思想有望拓展至更复杂的多变量和高维数据处理领域,包括深度学习中的时间序列特征提取、复杂系统趋势跟踪、以及实时决策支持系统。通过引入时间间隔敏感的权重调整机制和加权统计聚合方式,该算法为动态环境中数据驱动的智能分析提供了一种理论与实践兼备的强大工具。 总结来看,不连续指数加权平均算法以其创新性的权重时间指数衰减和新数据权重上限机制,成功解决了传统指数平滑算法面临的启动偏差和时间间隔不均匀导致的误差问题。其低内存开销、良好的统计特性和对不规则数据采样的适应性,使其成为实时数据处理和在线统计分析中的重要利器。理解并合理运用这一算法,有助于提升各类系统在动态、非连续环境下的数据质量评估与决策准确度,具备广阔的发展潜力和应用价值。

。