随着大数据时代的到来,数据管道作为连接数据获取、处理和分析的关键环节,扮演着至关重要的角色。传统数据管道工具虽功能强大,但在灵活性、多语言支持以及大规模并行处理方面仍存在限制。幸运的是,Rakulang与Sparky的结合正为数据工程领域带来新的可能,为开发者提供了更加高效且易于维护的数据处理方案。Rakulang作为一种现代化的脚本语言,兼具强大的表达能力和极高的可扩展性。而Sparky则通过其作业接口和集群模式,实现了分布式并行计算,为复杂的数据管道任务提供坚实的基础。首先,Rakulang与Sparky的优势体现在任务和脚本的无缝集成上。

Sparky核心将任务和脚本作为"头等公民",这意味着任务调度及管理内置于平台,极大减少了额外配置和环境搭建的复杂度。尤其是在数据管道开发中,任务间的数据传递和依赖管理成为核心难题,而Sparky通过其作业接口自然支持这一需求,保障了数据流程的连续性和安全性。其次,Sparky的集群模式为高性能计算(HPC)和并行任务执行提供了坚实的支撑。对于大规模数据处理任务而言,如何合理地划分工作负载并高效调度各节点任务显得尤为重要。Sparky通过集群模式支持任务跨节点调度,既提升了整体吞吐量,又保证了资源的充分利用,使得复杂数据管道得以高效执行。此外,Rakulang在多语言脚本支持上展现了极大灵活性。

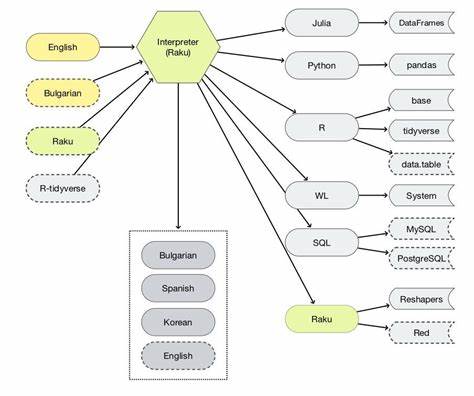

相比传统数据管道工具中往往锁定单一脚本语言,Rakulang允许用户依照任务实际需求选择最合适的语言完成相应工作。例如,一个数据管道可通过Perl脚本生成原始数据,然后通过Python脚本进行数据统计与分析。这样多语言协同不仅提升开发效率,更增加了代码的可维护性。更值得一提的是,Sparky与Rakulang共同采用"stash"机制实现数据跨任务传递。首个任务执行后将结果保存在stash中,随后子任务从stash获取数据继续处理,保证了数据传输的安全可靠。相比于其他数据管道框架中通过复杂的通道机制实现消息传递,这种方式更加直观且易于调试,极大优化了数据流逻辑的清晰度。

以一个典型的示例为例,通过Sparky和Rakulang,可以轻松模拟Nextflow框架中的多脚本数据管道。主任务采用Perl脚本随机生成若干有理数对,并通过stash传递给子任务,子任务使用Python脚本计算平均值并输出结果。整个流程在代码层面分明,任务职责清晰且相互独立,使得开发者既可以整体掌控数据流,又能针对单个任务进行单元测试和局部调试。与Nextflow相比,Sparky的数据管道优势还体现在代码维护和可扩展性上。Nextflow在主流程文件中内嵌脚本,虽然方便,但会导致代码臃肿且难以维护。Sparky则将业务逻辑与脚本代码分离,使管道规划更为简洁明了。

并且,Sparky内置的HTTP协议确保任务间数据交换无缝且安全,适合大规模集群环境使用。此外,Sparky提供的用户界面(UI)也为数据管道监控增添了便利。通过直观的管道步骤可视化展示,用户能够实时查看每个任务的执行状态、耗时和结果,及时发现并处理异常,大幅提升运维和管理效率。随着数据规模和复杂度的不断提升,分布式处理需求日益突出。Sparky的集群模式支持分布式执行,允许多个节点同时参与数据管道的不同阶段,从而实现真正的横向扩展。利用这一特性,数据平台可以应对海量数据输入并保证及时输出,大幅缩短数据处理周期。

除了基本的任务调度和执行,Sparky还支持更为复杂的工作流编排场景,包括等待子任务完成、递归式作业调用以及多种协调模式等。这些特性使得数据管道能够根据需求定制动态流程,不再受限于简单的线性执行,大大丰富了流程设计的灵活性与适用性。而Rakulang与Sparky生态系统中丰富的插件机制,更为分布式计算和任务扩展提供了强大助力。用户可基于现有功能开发专属插件,满足特定行业或项目的个性化需求,从而打造高度定制化的数据处理平台。总结来说,Rakulang与Sparky的结合为构建现代化数据管道提供了全方位支持。无论是多语言脚本协同、灵活的数据传递机制,还是分布式任务调度和流程编排能力,都体现了其卓越的技术优势。

同时简洁的代码结构与友好的UI体验,帮助开发者更好地管理数据管道生命周期。随着大数据分析与机器学习的普及,数据管道的重要性愈发凸显。基于Rakulang与Sparky打造的解决方案,不仅提升了数据处理效率,更为数据科学家和工程师带来了更多创新空间。未来,通过持续完善生态系统和增强功能模块,Rakulang和Sparky必将在数据工程领域发挥更加重要的作用,助力企业构建高效、灵活且可扩展的智能数据处理平台。 。