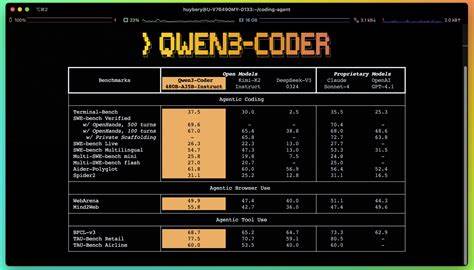

在人工智能技术迅速发展的今天,模型性能和推理速度已成为衡量AI应用价值的核心指标。Cerebras Systems最近发布的Qwen3-235B,凭借其卓越的性能表现,正在重新定义AI推理的速度和效率,为企业和开发者带来了极具突破性的创新成果。作为全球领先的AI超级计算平台,Cerebras结合其独特的Wafer Scale Engine-3芯片,成功将Qwen3-235B推理速度提升至每秒1500令牌,显著缩短了智能推理的响应时间,彻底改变了AI模型在实际应用中的表现。 Qwen3-235B是阿里巴巴旗下的开放边界智能模型,基于混合专家架构设计,展现出极高的计算效率和智能水平。该模型支持高达131K令牌的上下文长度,使其能够处理海量代码和复杂文档,为生产级代码生成提供了坚实保障。相比传统模型的32K上下文长度,131K的扩展使Qwen3-235B能够同时分析数十个文件和多个万行代码,为开发者在大规模项目中的协作与迭代带来了前所未有的便捷。

在推理速度方面,Cerebras凭借其全新的Wafer Scale Engine-3芯片实现了前所未有的性能突破。传统AI推理往往需要数分钟才能完成复杂任务,而Qwen3-235B的推理速度达到了令人惊叹的每秒1500令牌,使得原本需要1到2分钟的响应缩短至不到一秒,极大提升了实时交互和动态推理的能力。这种速度不仅满足了AI在科学计算、代码生成及知识推理等多个领域的苛刻需求,更为深度检索增强生成(deep RAG)等复杂工作流提供了强力支撑。 另一方面,Qwen3-235B的成本效率同样令人瞩目。Cerebras向市场提供的定价极具竞争力,每百万输入令牌仅需0.60美元,每百万输出令牌仅需1.20美元,成本不到同类封闭模型的十分之一。更低的成本意味着更多企业能够负担得起先进的AI计算资源,从而加速数字化转型和智能化升级。

重要的是,Cerebras与知名编码代理平台Cline达成战略合作,将Qwen3-235B的强大能力无缝整合进微软Visual Studio Code开发环境。Cline拥有超过180万安装用户,目前已支持基于Qwen3-32B模型的64K上下文功能,未来将逐步上线Qwen3-235B,届时将带来10到20倍于现有方案的代码生成加速。这一合作使得开发者能够直接在熟悉的编辑器中体验极速代码智能生成,极大提升编码效率和开发体验。 除了卓越的技术性能,Cerebras在系统设计上刻意避免分布式计算的复杂性,使得切换和扩展模型更为便捷。CS-3 AI超级计算机基于Wafer Scale Engine的构建,能够轻松集群成全球最大的AI超算之一,免去了传统GPU集群在调度与通信上的瓶颈。这样的架构设计不仅为Qwen3-235B提供了稳定且高效的算力保障,也为未来更大规模、更复杂的AI模型部署奠定了基础。

结合当前AI产业的趋势,Cerebras Qwen3-235B以开放、快速与经济的特性,成为企业级AI应用落地的有力推手。它不仅在科学研究、代码开发、复杂文档解析等领域展现出强劲竞争力,同时其高效推理速度和大容量上下文支持为新兴的智能代理和自动化工具提供了核心动力,推动行业进入实时智能处理新时代。 伴随人工智能的不断普及和深度融合,如何平衡模型智能、推理速度与成本效益成为市场关注焦点。Cerebras的创新突破无疑对这一难题提供了有益答案。作为全球唯一能够提供每秒超千令牌推理速度的前沿AI模型提供者,Cerebras不仅显著提升了开发者的生产力,也为客户打造了更具弹性和创新力的AI应用环境。 在未来,随着模型复杂度和应用需求的提升,类似Qwen3-235B这样集高速度与大上下文容量于一体的模型将成为行业标杆。

凭借其先进的硬件架构和灵活的云端服务,Cerebras有望继续引领AI推理性能的革新潮流,引导生成式AI进入更广阔的应用领域。对企业而言,选择Qwen3-235B不仅是追求性能的提升,更是抢占技术前沿、构建智能核心竞争力的关键一步。 总之,Cerebras发布的Qwen3-235B代表了AI推理速度与智能水平的双重飞跃。其通过 wafer-scale引擎实现的极致推理效率,其超大上下文支持及低廉成本,为企业和开发者提供了一个强劲、高效且经济的智能计算平台。随着更多合作伙伴和应用场景的挖掘,Qwen3-235B无疑将成为推动下一代人工智能创新和产业变革的关键力量。