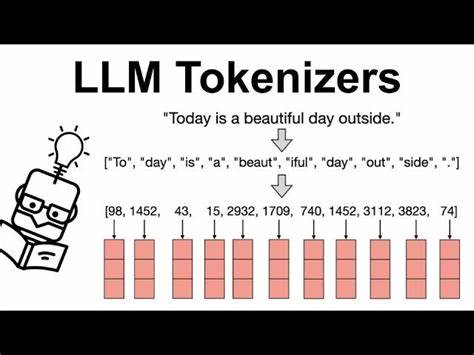

在人工智能和自然语言处理技术飞速发展的时代,文本的高效处理变得尤为关键。分词器作为自然语言处理的基础组件,其作用直接影响模型的性能和成本。在众多实现分词算法的语言中,Zig语言因其简洁、高效和无依赖优势,开始受到越来越多开发者的青睐。本文将带您深入了解使用Zig语言开发的LLM分词器 - - 一个基于Byte Pair Encoding(BPE)算法的纯Zig实现,并探讨其在大型语言模型(LLM)定价计算中的实践价值和最佳应用场景。 Byte Pair Encoding(BPE)是一种常用的分词技术,通过迭代地查找和合并最频繁出现的相邻字节对来生成词汇表。相比传统的基于词典或规则的方法,BPE可以更好地处理未知词汇和复杂语义,为大型语言模型提供更加稳定和细粒度的输入。

Zig语言在性能接近C语言的同时,具备现代化的语法和内存安全机制,使得BPE算法的实现更加简洁且高效。 LLM Tokenizer in Zig项目采用纯Zig 0.15版本完成,无任何外部依赖,实现了完整的BPE分词流程并内置了定价计算模块。该分词器从指定的文本文件(如src/prompt.txt)读取输入,并逐步合并最频繁的字节对,直至不再存在重复合并对为止。此过程不仅保证了词汇表的紧凑性,也优化了词语的表达能力,提升了模型输入的质量。 除了分词功能,该项目独特地集成了针对流行大型语言模型的定价计算器。通过配置不同模型的每百万令牌价格,分词器在完成文本切分后即可计算相应的令牌数量和对应的调用成本。

这对于开发者和企业用户来说是一项极为实用的功能,有助于在实际应用中评估和优化对话成本,避免预算超支。 实现方面,整个项目结构清晰,主要源代码集中在src目录下,便于扩展和维护。通过zig build系统可以快速编译和运行程序,极大简化了开发流程。项目还充分利用ANSI颜色输出格式,使得分词结果直观易读,为用户带来良好交互体验。 对于想要添加新的大型语言模型,项目提供了简单且灵活的模型配置功能。只需编辑src/main.zig文件中的模型数组,添加新的模型名称和单价即可完成扩充,满足不同需求场景。

此外,未来计划支持命令行参数输入和文件读取功能,增强程序的通用性与便捷性。 Zig语言的优势在于其精简且高效的设计理念,适合系统级编程及高性能场景。相比传统的分词工具,使用Zig实现的LLM tokenizer不仅运行效率卓越,还极大降低了依赖冲突带来的风险。同时,项目开源免费的特性,鼓励社区共建和持续优化,为自然语言处理领域注入更多活力。 在实际应用中,这款基于Zig的BPE分词器广泛适用于对文本处理精度和效率有较高要求的场景,如聊天机器人、智能问答系统和语义搜索等。定价计算功能还特别适合商业化部署环境,帮助开发者准确把控调用开销,提升整体运营效益。

总结来看,采用Zig语言的LLM Tokenizer集合了高效的分词算法和实用的成本计算工具,展现了现代语言在人工智能辅助开发中的无限潜力。对于科研人员、开发者及企业用户而言,深入掌握此类工具不仅能够优化文本处理流程,更能实现模型资源的合理利用和精准预算管理。随着自然语言处理技术不断进步,类似项目将在推动AI产业高质量发展方面发挥重要作用,值得广大技术爱好者重视和借鉴。 。