近年来,人工智能技术的迅速发展,尤其是大型语言模型(LLMs)的崛起,正在深刻改变软件开发的方式。越来越多的开发者开始拥抱AI辅助编码工具,利用其强大的自然语言理解和生成能力,提高开发效率和代码质量。根据多项调查,超过半数的开发者至少偶尔使用AI驱动的编程工具,这一比例仍在不断提升,显示出行业对AI技术的期待与依赖。然而,伴随着便利和创新的同时,AI给软件开发带来了潜在的风险和挑战,尤其是在安全性与代码质量方面。理解和应对这些问题,将成为开发者和组织能否真正受益于AI的关键。 从积极的角度看,AI及大型语言模型为编码过程注入了革命性的动力。

它们能够根据自然语言描述自动生成代码,帮助开发者减少重复和繁琐的工作,专注于更具创造性和复杂性的任务。此外,许多AI工具还能实时分析代码,提供安全建议,识别潜在漏洞。这种实时反馈不仅提升了代码安全性,也促进开发者持续学习和改进。特别是在代码注释和文档生成方面,AI的辅助能力有效解决了代码阅读和理解的难题,使团队成员能更快地掌握复杂系统的内部逻辑,降低沟通成本。 整合AI工具的企业也因此获取了明显的生产力优势。Deloitte的调研显示,超过67%的组织已经开始采用或计划采用AI技术,为开发流程带来实质性变革。

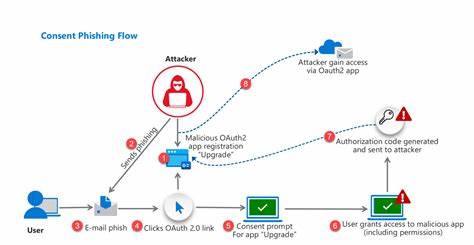

AI不再是未来的概念,而成为日常开发流程中的重要组成部分。在保障生产效率的同时,借助AI降低了因人工失误产生的安全风险,促使软件开发向更高质量和安全水平迈进。 然而,AI技术直接应用于软件开发并非没有隐患。人类开发者过度依赖AI生成的代码,可能陷入“黑箱”困境。换言之,开发者对AI生成代码的逻辑和实现细节理解不足,导致难以有效排查错误、修复漏洞或优化性能。特别是在涉及安全策略和依赖管理时,盲目信任AI生成的代码可能引入过时或易受攻击的第三方库,使应用程序容易遭受攻击,危及用户数据和业务稳定性。

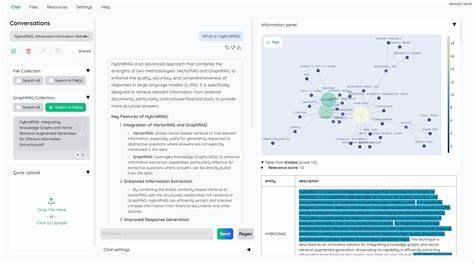

更为严重的是,随着AI代码生成工具的普及,一些开发者的安全编码能力有退化的趋势。如果没有扎实的安全编程基础作为支撑,开发者难以辨别AI代码中潜在的安全隐患,甚至无法有效修改和优化其输出,造成软件安全风险的积累。此外,AI模型本身容易受到训练数据的偏见和信息失真的影响,生成的代码可能包含不安全或低效的实现方案,增加软件缺陷发生概率。 为充分发挥AI在软件开发中的积极作用,开发者必须强化自身的安全编码知识和审查能力。只有具备深厚的安全意识和技术能力,才能精准识别AI生成代码中的漏洞,并落实必要的防护措施。同时,持续学习和实践安全标准使开发者能够主动管理第三方依赖,维护软件供应链的安全性,抵御潜在攻击。

批判性思维是使用AI的另一重要前提,开发者需全程审查和测试从AI工具获得的代码,确保最终产品的健壮性和安全性。 另外,构建以安全为核心的软件开发文化尤为关键。组织可以通过开展定期安全培训、推动安全开发生命周期(SDLC)实践以及引入代码审查机制,形成全员参与的安全生态环境。在此基础上,结合AI技术,实现人机协作的最佳模式,使技术赋能与人类智慧相辅相成,避免单方面依赖AI所引发的风险。 展望未来,软件开发的成功不应仅依赖于AI或开发者单方面的优势,而是二者的协同作用。AI作为强大助手,能显著提升编码效率、降低常规错误并促进安全意识普及。

而开发者凭借深厚的专业知识和安全思维,保障代码质量和系统稳定。只有平衡利用这两者的独特优势,企业和开发者才能真正实现创新的突破和安全管控的双赢。 Michael Burch,这位从军人转型为应用安全工程师的专家,提出了深入见解。他强调,培养开发者对安全编码原则的理解至关重要,帮助其有效审视和应用AI生成代码,保障软件供应链的完整和安全。借助持续培训和AI辅助,开发者能够更好地预见安全威胁,并设计出防护措施,构筑起防御攻击的坚实防线。 综上所述,人工智能和大型语言模型无疑改变了软件开发的生态,既带来了无与伦比的机遇,也产生了新的挑战。

开发者和企业应理智看待AI技术,秉持安全编程的理念,培养批判性思维,加强代码审查和测试,才能在保障软件安全的同时,充分发挥AI的效能。未来的软件开发,将是人机深度协作、技术与经验融合的新时代,为计算机行业开辟更加安全、高效和创新的道路。