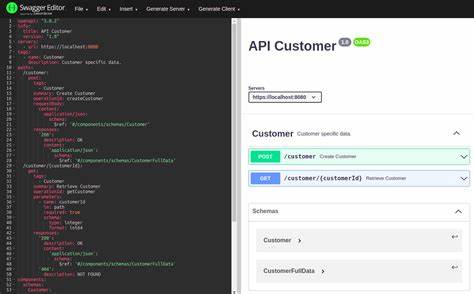

随着大语言模型(LLM)在智能助理和自动化工具中的广泛应用,模型上下文协议(MCP)作为连接AI代理与外部工具、API的桥梁,愈发显得重要。一个热门的话题是是否可以直接利用已有的OpenAPI规范自动生成MCP服务器,从而简化开发流程,加速工具集成。但这个“捷径”真的值得走吗?本文将深入剖析这一问题,探讨其背后的技术挑战、实际应用局限,以及最佳实践建议。 首先,需要明确的是OpenAPI规范的初衷是为RESTful API提供统一且结构化的描述,便于人工或机器理解接口细节,包括路径、参数、请求与响应格式等。许多企业投入大量资源完善和维护这些规范,以确保后端服务的稳定与易用。基于这一结构化契约,自动生成客户端代码、文档和测试都是业界常见的自动化方案。

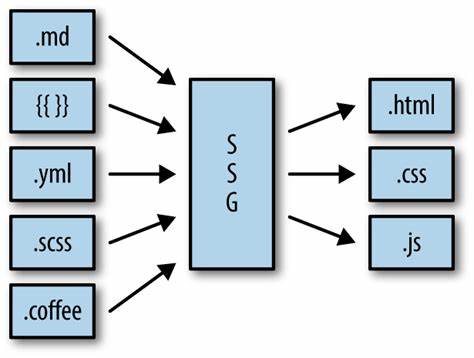

将这一逻辑拓展到MCP服务器似乎顺理成章:为何不直接将OpenAPI模式“翻译”为MCP工具? 然而,问题的复杂性在于MCP服务器的设计理念与传统REST API截然不同。REST API强调的是底层资源操作,具体如“创建用户”、“更新订单状态”、“获取商品列表”等离散动作。每个API端点都尽量保持职责单一、清晰明确,便于程序调用和维护。反观MCP服务,更加注重抽象层次和任务导向,侧重于支持大语言模型完成更宏观的业务流程,比如“客户入职”、“数据库迁移自动化”或“报告生成”等。这意味着MCP工具本质上是复合型的、高层次的工作单元,通常由多个API接口调用组合而成。 这种本质差别导致一个简单的1对1映射方案存在诸多弊端。

首先,现有大型REST API的接口数量可能庞大,以GitHub API为例,超过600个端点。如果将所有这些接口都转换为MCP工具,LLM面临的选择空间极其庞大,会出现决策困难甚至混乱的情况。实际上,语言模型在面对大量相似选项时容易出现匹配错误,导致调用失败或功能异常,最终恶化用户体验。 其次,LLM在处理复杂JSON结构和海量可选参数时表现有限。很多API拥有灵活且丰富的参数集,LLM缺乏足够的推理能力判断何时适合使用哪种参数组合,更不用说理解不同行为导致的系统状态变化。这种情况下,让LLM直接操作底层接口极具挑战性,也不利用其生成推理和自然语言理解的优势。

再者,REST API设计目标面向程序员和系统,而MCP旨在通过自然语言对接AI代理完成特定业务操作。直接暴露大量原子接口迫使LLM像一个传统程序客户端一样调用API,剥夺了它在任务编排、上下文理解和多步骤流程执行中展现创造力的空间。理想的MCP设计应当聚焦业务场景,将多个基础操作封装在高级工具中,平滑衔接复杂任务,提升调用的语义准确性和鲁棒性。 因此,盲目将OpenAPI自动转换为MCP服务器工具等同于“搬砖”,既浪费人力物力,也影响系统稳定。OpenAPI到MCP的自动化应视为一种辅助起点,而非终点。推荐的实践是先通过工具自动生成初稿,随后开发者须深度剖析并精简工具集,只保留真正对语言模型语义调用有帮助的核心操作。

同时,重写工具说明,从简单接口功能描述转向明确阐明LLM使用时机、预期行为及调用范例,提高模型理解效果。 最关键的是要基于业务需求设计高层次的MCP工具:这些工具将依据具体流程封装多次API调用,实现跨步骤协同。比如迁移数据库状态的工具能够内部管理多个更新、验证和回滚操作,对LLM隐藏底层复杂性,仅暴露清晰的任务接口。这样既发挥了语言模型强大的指令理解力,又保证系统安全稳健,避免误操作带来的风险。 在实际案例中,例如Neon团队以TypeScript API SDK为基础实现MCP服务器,采用选定API端点构建工具,同时结合多个端点设计高级工作流,实现数据库迁移等复杂任务的自动化和简化。该项目不仅公开源码支持社区协作,也不断迭代优化,表明自动生成只是合理开发模式中的一环,而非万能灵丹。

综上所述,从OpenAPI模式自动生成MCP服务器虽然在理论上极具吸引力,确实能够快速起步,开辟API与AI代理无缝连接的新途径,但简单粗暴的1对1映射策略弊端显著。针对语言模型的特性和任务需求进行有针对性的开发与改造,大幅提升体验和效率,才是可持续发展的明智选择。 未来,结合越来越完善的API管理规范、更智能的代码生成工具以及AI对复杂流程推理能力的提升,有望形成更加成熟和灵活的MCP生成生态。值得开发者和企业持续关注并积极探索,以推动智能代理领域迈向更高效、更安全的应用新时代。