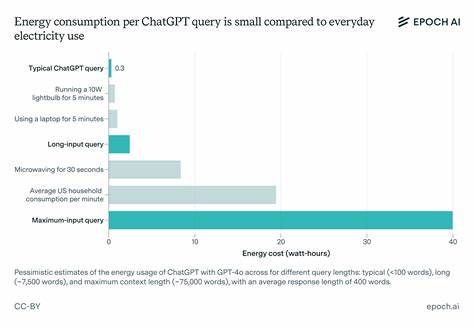

随着人工智能技术的快速发展和广泛应用,许多人开始好奇一个关键问题:人工智能到底消耗了多少能源?尤其是像ChatGPT这样的热门聊天机器人,每天处理成百上千万的查询,其运行背后的能源消耗到底有多大?然而,令外界难以获得准确答案的是,许多领先的AI技术公司对相关能耗和碳排放数据保密,使得公众和研究人员只能依靠有限的估算和间接信息来推断AI的真实环境影响。OpenAI首席执行官萨姆·奥特曼曾在博客中透露,一次普通的ChatGPT查询大约消耗0.34瓦时的电能,这个数字相当于一个烤箱开一秒钟的能耗,或者一个高效灯泡亮几分钟的能耗。虽然乍看之下这似乎是一个较低的数字,但考虑到ChatGPT庞大的用户基数,能耗总量仍不容小觑。然而,专家对奥特曼提供的数字持怀疑态度,指出缺少足够的公开数据来验证计算方式,诸如是否含有图像生成任务,是否将模型训练和服务器冷却的能耗算入其中,都未可知。气候专家萨莎·卢西奥尼甚至直言,这些数据可能是凭空估测,她与团队在提交的分析报告中指出,超过八成的主流大型语言模型(LLM)用户选择的是没有任何环境影响披露的服务,使得整个行业的透明度极为不足。更令人关注的是,在缺乏明确能耗数据的情况下,外界流传许多未经证实的统计数据,例如有人声称一次ChatGPT请求的能耗是一次谷歌搜索的十倍。

这一数据最初由谷歌母公司董事长约翰·亨尼斯于2023年偶尔提及,但后来被反复引用为“事实”,进一步加剧了认识偏差。缺乏标准的能效指标和监管,使得消费者无法像购买汽车时了解油耗一样,了解所使用AI工具的环境成本。学者们呼吁立法机构对AI行业制定强制的碳排放披露要求,以促进技术发展的环境责任意识。其中一个突破口在于开放源代码模型的研究。一些科技公司出于商业保密原因,不公开其核心模型和真实能耗数据,而开放源代码的模型则为独立研究者提供了宝贵的监测和评估机会。最新研究发现,不同的开源大语言模型在处理相同问题时的能耗相差可达50%,且更复杂的推理型模型需要处理更多的“思考令牌”,意味着更高的能源消耗。

研究人员呼吁未来可通过智能调度机制,将简单的问题自动分配给较小、计算资源较低的模型,从而实现节能效果。事实上,部分科技巨头早已实践类似方案,采用小型模型承担一些基础查询,以缩短响应时间同时降低能耗,但整体来看,该领域仍缺乏引导用户选择能效更优服务的动力。影响AI实际能耗的因素极其复杂,不仅包含算法和模型规模,还有硬件条件和数据中心的运行环境。不同型号的GPU作为AI推理的核心计算单元,功耗差异巨大。以Nvidia系列芯片为例,新一代针对AI应用优化的H100比过去的A100消耗更多电力。大型数据中心除计算外,还需为服务器冷却、网络设备供电,这些“边缘”能耗往往被忽略,使得实际碳排放估算更加困难。

此外,数据中心所在的电网结构也影响整体排放,依赖煤炭等化石能源的地区将带来更大碳足迹,而使用绿色电力的数据中心则相对环保。将单次计算能耗外推到整个人工智能生态的碳排放,无疑更加复杂。训练大型AI模型是远超单次查询能耗的能源大户,但多数相关数据依旧高度机密。公众对于这些隐藏的能源消耗一无所知,导致无法全面评估AI技术对气候变化的潜在影响。专家们普遍认为,透明和标准化的数据披露是通向可持续AI的关键第一步。面对全球气候危机的压力,推动AI行业披露详细的碳足迹和能耗数据,制定合理的能效规范,对于有效管理技术发展和减缓环境风险至关重要。

只有建立起开放、可验证的环境影响评估体系,才能帮助消费者理性选择绿色AI服务,促进企业创新节能技术,最终实现人工智能和环境保护的双赢局面。人工智能不仅是推动社会进步的强大引擎,也是一把双刃剑。它可能加速数字经济的繁荣,但潜在的能源消耗和碳排放问题不容忽视。未来,业内各方需在透明度、技术创新和政策监管间找到平衡点,才能确保AI在赋能人类的同时,也为地球的可持续发展负责。