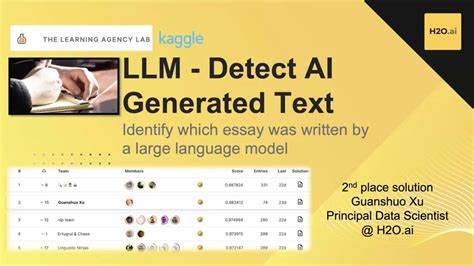

近年来,人工智能尤其是大语言模型(LLM)的广泛应用,极大地改变了学术研究和同行评审的生态。大量研究论文和评审意见中开始出现由人工智能生成的文本,这一现象引发了学术诚信和质量的深刻担忧。尽管多数学术期刊对LLM生成文本的使用设有明确限制,要求作者和评审者如实披露,但依旧存在未申报的情况。针对这种趋势,学术出版领域迎来了新一代人工智能检测工具,专门用于识别论文及评审文本中的大语言模型生成内容,保障研究的真实性与透明度。 大语言模型如GPT系列,具备强大的自然语言生成能力,能够高效产出语义连贯、结构合理的文本。这些技术在辅助科研写作、数据分析乃至创新构思方面展现出巨大潜力,极大提升了学者的工作效率。

然而,过度依赖或未披露使用人工智能生成文本,则可能导致学术不端行为,破坏研究的原创性和公信力。正因如此,人工智能检测工具愈发受到重视,成为维护学术诚信的重要利器。 目前,业界开发的AI检测工具多基于机器学习和统计特征分析,能够识别文本中典型的人工智能生成模式。检测方法通常综合考虑句法结构、文本重复率、用词频率及语义一致性等多个维度。通过对比大量真实人类撰写文本和人工智能生成样本,这些工具建立起精确的辨识机制。尤其针对学术领域,检测算法不断优化以适应专业术语和学术表达的多样性,从而提高检测准确率和适用范围。

这种技术的应用不仅帮助期刊编辑和审稿人快速筛查潜在的自动生成内容,也推动学术界思考新的伦理规范和使用指导。许多顶尖学术出版社已经明确采取措施,鼓励作者及评审者在提交材料时披露人工智能辅助写作的具体细节,以确保研究过程的透明度。此外,机构导则逐步将AI生成内容的适当使用纳入职业道德范畴,强调技术辅助与人工创造之间的平衡。 尽管检测工具已取得显著进展,但挑战依然存在。一方面,随着大语言模型技术不断升级,生成文本的自然度和多样性不断提高,给检测带来了更高难度。另一方面,部分文本可能是人工与AI混合创作,难以简单归类,导致误判风险。

因此,检测系统需要持续引入先进的深度学习算法以及丰富训练数据,不断完善对复杂文本的理解能力。 未来,结合区块链等安全技术,打造不可篡改的原创性认证机制或将成为趋势,为学术出版提供更强有力的信任保障。另外,多方协作建立统一的透明披露标准,有助于规范AI工具的合理使用,防范技术滥用。同时,教育层面也需加强学者对人工智能工具正确应用及其伦理影响的认识,提升整体科研水平和诚信度。 不可忽视的是,人工智能检测工具的普及也带来了积极影响。它推动了研究创新与伦理之间的对话,督促学术界重视原创价值和技术融合带来的边界。

借助健康的监管环境和技术辅助,科学研究正向着更加透明、高效且可靠的方向发展,从而更好地服务于社会进步与人类文明的传承。 综上所述,人工智能工具在识别大语言模型生成文本中的作用日益关键。它不仅维护了学术出版领域的诚信和规范,也引领行业构建更为完善的技术与伦理生态。未来,通过不断技术创新和制度完善,学术界有望实现人工智能与人类智慧的和谐共生,推动科研迈向崭新的高度。 。