近年来,大型语言模型(LLM)的技术不断革新,推动人工智能领域迈入更加智能和高效的阶段。随着各类LLM在算法架构、训练数据和优化目标上的差异日益显著,场景化、个性化的模型选择需求也急剧上升。传统路由方法依赖排行榜成绩进行模型挑选,往往无法满足用户对结果主观偏好、多样性目标以及实际应用复杂性的诉求。在这一背景下,Katanemo团队推出了名为Arch-Router的1.5B参数大型语言模型路由框架,通过以用户偏好为核心的智能匹配机制,实现对多模型环境下请求的精准路由,显著提升了匹配效率和用户满意度。Arch-Router的设计理念创新性地避免了简单依赖通用基准测试成绩,转而结合对话上下文语义、任务类型及用户侧偏好进行路由选择,有效契合不同领域、操作习惯和使用场景的个性化需求。模型通过深度学习技术自动解析输入文本,把请求映射到对应的领域和动作类别。

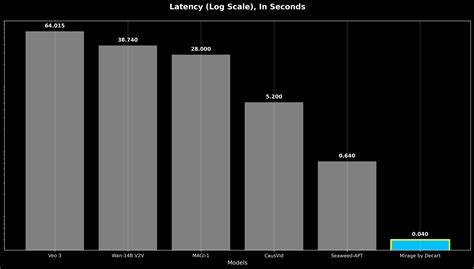

领域涵盖法律、医疗、编程等高层次主题,而动作则涵盖摘要、代码生成、翻译等具体操作类型。Arch-Router将这些分类与预先定义的模型优先级配置相结合,在推理阶段智能匹配出最适合本次请求的模型。这一架构不仅提高了模型选择的合理性,也为动态业务需求和模型生态变化提供了灵活适应能力。实践应用已显示该路由模型在多个对话数据集上的优异表现,成功超过了多家顶级专有模型在满足人类偏好判定上的表现。得益于其轻量级设计以及对高性能推理框架的支持,它可以高效部署于复杂多模型环境中,满足低延迟和高吞吐的工业级要求。具体来看,Arch-Router通过结构化偏好路由技术,确保每条用户请求都能精准对应最擅长处理该类任务的模型版本。

其透明且可控的路由策略,允许用户根据业务发展需求手动调节路由规则,无需重新训练模型,极大提升了灵活性与可维护性。值得关注的是,其开源代码已整合入Hugging Face的Transformers库,使用门槛低且方便开发者快速上手。简明的API接口配合明确的输入输出格式指引,使得模型在实际产品研发中能够迅速集成与迭代。通过示例演示可以看到,用户只需提供一系列路由定义和对话上下文,模型即可生成符合用户意图的最优路由结果,进一步降低了多模型管理的复杂度。在人工智能加速产业变革的大趋势下,Arch-Router代表了一种面向未来的多模型协作管理思路。它强调不仅仅是追求最高的排行榜分数,而是注重理解和尊重用户和业务方的实际偏好,实现高效且精准的智能服务。

与此同时,随着模型规模和种类持续爆炸式增长,传统的统一模型方案已难以覆盖所有应用需求,智能路由机制将成为AI系统通用架构的重要组成部分。未来,结合更丰富的用户反馈、实时动态调整和跨模态路由能力的研究,相信偏好驱动的智能模型路由会进一步促进人工智能应用的落地深度与广度。这不仅能够优化资源利用,降低运维成本,还将为终端用户带来更加个性化和人性化的服务体验。总结来说,Arch-Router 1.5B模型通过创新的偏好对齐策略与结构化路由配置,成功突破了传统排行榜驱动模型选择的瓶颈,推动多模型生态走向更高效灵活的发展阶段。它不只是一种技术工具,更是一种倡导用户导向、业务驱动的智能决策范式。对开发者、企业和研究者而言,深入理解和掌握此类模型路由机制,无疑为打造未来智能化产品奠定坚实基础。

随着技术和应用的不断进步,相信这一领域必将迎来更加广阔的创新天地和巨大价值释放。