在当今数字化时代,数据量呈指数级增长,对存储空间和传输效率的需求愈加迫切。数据压缩作为优化存储和提升传输速度的重要技术,扮演着不可或缺的角色。本文将带您深入了解数据压缩的基本原理及几种主流压缩算法的工作机制,为您揭示如何通过高效的压缩技术节省成本并提升性能。 什么是数据压缩?从根本上来说,数据压缩是用更少的比特数表示原始数据的过程。由于计算机中的数据是以二进制形式存储的,每个字节包含8个比特,压缩的本质就是减少需要存储或传输的比特数。这样不仅能节省存储空间,还能大幅减少网络传输所需时间,尤其对于大规模数据处理尤为重要。

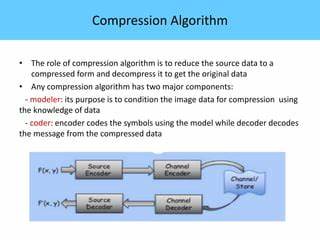

压缩技术根据是否保留全部原始数据,可以分为两大类:无损压缩和有损压缩。无损压缩确保压缩后数据可以准确还原,适用于文字、代码和其他敏感数据;而有损压缩则允许部分信息丢失,换取更高的压缩率,多用于音频、图像和视频领域。 无损压缩的核心思想是消除数据中的冗余。早期的技术如运行长度编码(Run-Length Encoding,RLE)通过将连续重复的元素简化为符号和计数来减少数据量。尽管简单,但RLE对于像长串重复字符的场景效果显著。更复杂的技术如Lempel-Ziv(LZ)算法通过查找数据中重复出现的子串并用指针或偏移量替代,显著提升了压缩效率。

其变体LZ77不仅是许多现代压缩格式如gzip和Snappy的基础,而且成为了压缩领域的经典。 哈夫曼编码则是一种基于符号频率分配变长编码的算法,常用符号用较短的位串表示,不常用符号用较长的编码,从而达到总体压缩的目的。哈夫曼树的构建中,从频率最低的符号开始合并,最终形成一颗编码树,每条路径对应独特的符号编码。虽然哈夫曼编码在很多场合表现优异,但其必须使用整数位数来编码符号,限制了更细粒度的概率调整,这点在后续出现的算术编码中得以改进。 gzip作为最广泛使用的压缩格式之一,其核心是DEFLATE算法,它完美结合了LZ77的重复序列替换和哈夫曼编码的变长表示。DEFLATE使用滑动窗口寻找数据中已有的匹配序列,并将其替换为长度和距离的编码对,然后利用哈夫曼树优化编码。

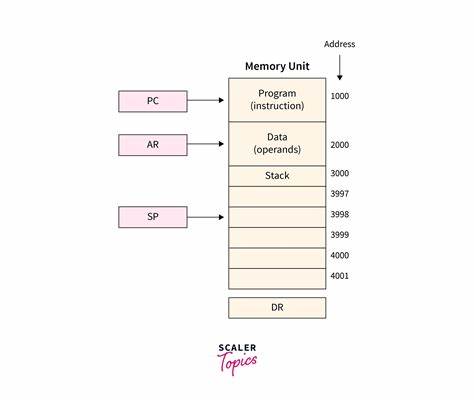

数据流被分为不同类型的块,包括未压缩块、固定哈夫曼编码块和动态哈夫曼编码块,后者根据当前数据动态生成最优编码树以进一步提高压缩率。其实现中采用了链式哈希表加速匹配查找,根据压缩级别调控搜索深度以权衡速率与效果。 与gzip相比,Snappy则更侧重压缩和解压速度,牺牲部分压缩率以换取更快的性能,常用于对速度要求极高的场景。Snappy基于LZ算法,采用简单直接的匹配查找机制,每次只跟踪最新一次匹配,运用字节分片和标记定义字面数据及复制数据,确保编码块整齐划一,便于高速处理。其快速压缩能力使其成为大数据平台如Hadoop及Kafka的首选压缩方案。 另一个备受关注的压缩算法是LZ4,它与Snappy类似,致力于极致的压缩速度,同时依然保持较高的压缩效率。

LZ4通过分块处理数据,并使用高效的哈希表和XOR快速匹配技巧,大幅提升匹配速度。其独特之处在于将字面长度和匹配长度合并入单个字节token的高低4位中,超过部分通过接续字节展开,极大简化解码流程。支持流模式的LZ4更支持跨块引用,进一步提升压缩效果。 Zstandard(ZSTD)是Zlib和LZ4之后的又一新兴技术,由LZ4作者研发,集成了多种编码机制。ZSTD实现了接近或优于gzip的压缩比,同时达到与LZ4和Snappy相当的速度。ZSTD在传统LZ77基础上引入了更高效的编码方法,包括哈夫曼编码和基于有限状态机的编码技术(FSE),后者是对算术编码的优化版本,兼顾了性能和压缩率。

此外,ZSTD还支持可训练的字典,这一特性使其在处理小文件和特定数据集时表现尤为卓越。通过预先训练字典,压缩器可以识别并替换更多常见模式,显著提升压缩性能。 算术编码与哈夫曼编码不同,它不限制符号的编码位数为整数,允许使用非整数比特长,从根本上解决概率与编码长度之间的匹配难题。虽然算术编码能达到理论上的最佳压缩,却因计算复杂和效率低而较少用于实时需求场景。FSE作为算术编码的变体,通过有限状态机机制减少运算开销,使ZSTD等现代压缩算法得以高效应用。 从编码机制到实现细节,各种压缩算法在设计时均面临着吞吐量、延迟和压缩率之间的权衡。

例如,DEFLATE利用链式哈希匹配搜索整个链表以找到最长匹配,适用于压缩率优先场景,但计算成本较高。相反,Snappy和LZ4缩减搜索范围,只寻找最近或部分匹配,提高速度但可能牺牲一定压缩质量。ZSTD则通过多层算法设计和优势组合,试图在二者间寻找最佳平衡。 压缩技术不仅影响文件存储和传输,还在现代大数据处理、数据库索引、实时日志处理、内容分发网络及机器学习模型存储中发挥着关键作用。特别是随着云计算和移动设备的普及,网络带宽和存储效率对用户体验和运营成本的影响日益显著。合理选择压缩算法,结合具体需求(比如实时性、资源限制、数据类型等)能显著提升系统整体性能和稳定性。

展望未来,数据压缩技术正不断融合人工智能和机器学习元素,例如通过训练模型以自动识别和优化数据模式,提升压缩效率。与此同时,硬件专用加速器的研发也为实时高效压缩打开了新局面。随着5G、物联网和边缘计算的快速发展,数据压缩技术的重要性将愈加凸显,推动信息技术领域的持续创新与变革。 总之,在信息爆炸的时代,掌握数据压缩技术的基本原理和主流算法特点,不仅有助于提升系统设计和性能优化水平,也有助于更好地应对未来海量数据处理的挑战。无论是开发者还是技术管理者,深入了解这些算法的底层机制和应用场景,都是推动数字化转型的关键一步。 。