什么是GPT-4? GPT-4是由OpenAI开发的一代大型多模态语言模型,能够理解并生成文本,同时支持图像等非纯文本输入。作为第四代基础模型,GPT-4在自然语言理解与生成、推理与连贯性方面较前代产品有明显提升,能够应对从创作写作、代码生成到复杂问答与长文本摘要等多样任务。 发展背景与所有者 GPT-4由位于旧金山的人工智能公司OpenAI推出。OpenAI自2015年成立以来,逐步从非营利组织向混合商业模式演化,接受了微软、亚马逊云服务等多方投资与合作支持。OpenAI同时推出了ChatGPT对话产品和图像生成模型DALL·E,并在不断增强模型能力的同时,逐步将更强功能向订阅用户和企业客户开放。 发布时间与可获得性 GPT-4于2023年3月向公众宣布,最初通过ChatGPT Plus等订阅通道提供访问。

随着模型家族的扩展,OpenAI逐步推出了更大上下文长度或更高性能的变体,并将部分功能通过合作伙伴渠道(如微软Bing)提供给更广泛的用户群体。开发者与企业可通过OpenAI的API或合作平台申请接入,某些视觉能力在早期仅开放给少数合作伙伴试用。 接入方式与使用场景 普通用户常通过ChatGPT网页版或移动端体验GPT-4的对话与创作能力;企业则可考虑ChatGPT Enterprise或通过Azure OpenAI Service接入模型API以获得更严格的数据控制与商业级别的性能保障。开发者可利用API将GPT-4集成进客服机器人、文档摘要工具、代码生成与审查流程、内容审校与创意辅助系统等场景。与此同时,微软的Bing Chat基于GPT-4提供搜索侧的对话增强功能,并为企业推出了带有额外数据保护的Bing Chat Enterprise。 成本结构与计费要点 面向个人的ChatGPT Plus订阅曾以月费形式提供更优先的访问权限;面向开发者的API计费通常按提示(prompt)与输出(completion)令牌(tokens)计费,不同变体与上下文长度对应不同价格。

像GPT-4这样的高性能模型通常每千令牌的输入与输出存在差异定价,而更大上下文变体(如支持数万令牌的版本)价格更高。企业在规划大规模调用时应仔细评估模型变体、调用频率与缓存策略,以权衡成本与性能。 核心能力与技术亮点 GPT-4在多模态理解、多步推理以及更长文本保持连贯性方面表现出色。它可以处理复杂指令、总结长篇文档、生成结构化输出并在多样知识领域提供高质量的草稿与建议。OpenAI在模型训练与调优时结合了大量公开与许可数据,并通过人类反馈强化学习(RLHF)来优化回答的可读性与安全性。GPT-4在部分标准化测试中取得了优异成绩,反映出模型在语言理解与推理方面的进步,但这些分数并不等同于真实世界的知识或事实检验能力。

模型家族与版本差异 在GPT-4家族中存在多种子版本,例如面向更高吞吐与成本优化的变体,以及支持更短延迟或更低资源消耗的mini版与o系列。OpenAI也推出了可用于视觉输入的变体,使模型能够描述图片内容、理解图表或对界面元素做出判断。为了满足不同开发者需求,OpenAI提供了如微调(fine-tuning)、模型蒸馏(distillation)与缓存(prompt caching)等工具,帮助在成本、延迟与定制化之间取得平衡。 局限性与风险考量 尽管GPT-4在生成自然语言方面表现优异,但仍存在若干关键限制。模型会出现"幻觉"现象,即生成看似合理但不准确或捏造的信息;对实时事件的掌握受限于训练数据的时效性,除非与联网检索服务或插件结合才能获得最新信息。企业在向模型提供敏感或专有数据时需关注数据是否会被用于模型训练或共享,慎重选择托管方式与合同条款。

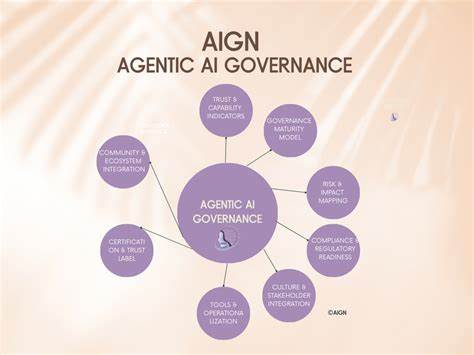

此外,模型生成的内容有时在伦理、偏见与合规方面存在风险,需要结合人工审查与治理机制来控制。 企业部署与治理建议 在企业级应用中,评估是否使用GPT-4应基于明确的业务目标、数据安全要求与成本预算。对外客户服务场景可借助模型提升响应效率与一致性,但关键决策或法律合规类输出仍需人工把关。对于内部知识检索、文档自动摘要与辅助决策,私有部署或通过Azure等提供的企业通道可降低数据泄露风险。制定清晰的使用规范、建立监督日志、定期评估输出质量与偏差,并为员工提供模型局限性培训,是降低风险、提高ROI的关键步骤。 与其他模型的比较 相较于GPT-3.5,GPT-4在理解复杂指令、保持长文本上下文和处理多模态输入方面更为强大;相较于一些竞争对手,诸如某些实时联网的模型能提供更及时的信息,GPT-4的优势在于语言生成质量与多样化的部署生态。

开发者在选择时应考虑吞吐需求、延迟敏感性、上下文长度需求以及成本预算,结合性能基准测试与试点证明来做决策。 最新发展与开发者工具 OpenAI持续在开发者层面推出新功能,例如实时API以支持低延迟语音对话、允许在付费层实现图像微调、模型蒸馏以将大型模型的能力转移到更小的部署单元,以及提示缓存以降低重复调用的成本。这样一来,构建语音客服、带有视觉理解能力的巡检机器人或离线可部署的轻量化模型变得更为可行。 如何判断是否值得升级到GPT-4 是否升级取决于预期收益是否能覆盖成本与治理开销。若业务场景要求更强的语言理解、更复杂的推理能力或视觉输入支持,GPT-4往往能带来显著效率提升。若主要需求是基础对话或轻量化文本生成,成本更低的变体可能已足够。

建议先通过小范围试点评估性能与用户体验,再根据试点结果制定分阶段扩展计划。 未来展望与实践建议 大语言模型的成熟带来生产力工具的普及,但同时也需要在合规、数据治理与可解释性方面投入。企业应关注长期的模型维护成本,构建可回溯的输出审计链,并探索将检索式增强(RAG)与领域知识库结合的方案以提升事实性。对开发者而言,掌握提示工程、选择合适的模型变体、利用微调与蒸馏技术都是提升产品性能与降低成本的有效路径。监管与伦理框架的不断完善也将影响企业的部署选择与用户信任。 结语 GPT-4代表了生成式AI在理解深度、语言连贯性与多模态能力上的重要进步,为内容创作、客户服务、研发辅助与知识管理等领域提供了强大的工具。

要获得长期价值,需要在技术能力、成本与治理之间做好平衡,通过试点验证、规范管理与持续优化来降低风险并放大效益。理解其优劣势并将其与现有业务流程有机融合,才是把握这类先进模型带来机会的可行之道。 。