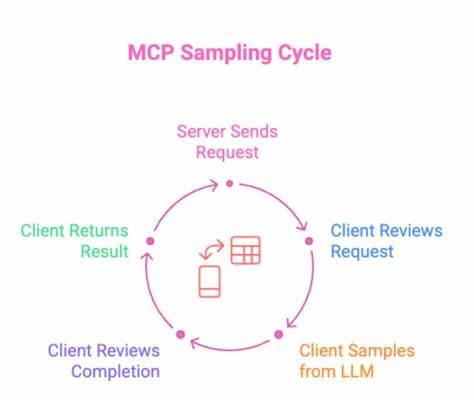

多方通信协议(MCP)采样是一项在人工智能和大型语言模型(LLM)领域内引人注目的功能。它赋予MCP服务器请求MCP客户端利用其自身的LLM来完成某些任务,从而实现资源共享和协同操作。通过采样机制,服务器发送请求,客户端的LLM进行处理并将结果返回服务器。这种模式不仅在技术上展现出极大便捷性,也为企业节省了大量人工智能计算成本,尤其是当多个部门和系统同时需要调用复杂语言模型时。然而,在欣赏其带来的优势时,我们也不能忽视采样过程中潜藏的风险,尤其是金融层面的潜在威胁和安全隐患。采样机制的核心优势之一是成本的分摊。

通常,一个部门或服务器端如果要自行使用LLM完成复杂任务,将面临高额的计算费用和大量token消耗。利用采样,客户端承担这部分费用,服务器端则减轻了经济负担。以企业内部的差旅预订系统为例,传统的流程是员工通过表单提交差旅申请,后台旅行团队再通过多个航班和酒店聚合平台查询比价后,人工或半自动化地为员工选择最佳方案。整个流程涉及大量数据抓取、格式化和人机交互。用Agentic AI改造后的流程中,员工可以直接通过聊天机器人完成差旅申请,后端的MCP服务器则从聚合平台抓取原始数据,以JSON等结构化格式返回。随后,通过采样,旅行团队的MCP服务器请求客户端的LLM将这些原始数据转化为人类容易理解的文字或图形化界面,最终呈现给用户。

如此不仅提高了用户体验,也减少了服务器自身LLM的调用成本。尽管采样带来了明显的经济与使用便利,它也可能导致严重的财务风险。恶意或设计不当的MCP服务器有可能发起大量采样请求,消耗客户端的LLM令牌,在无形中造成经济损失,即所谓的"钱包拒绝服务"攻击(Denial of Wallet)。这是一种新兴的安全威胁,一旦失控,可能导致系统计算资源被耗尽,企业成本飙升,甚至业务瘫痪。举例来说,恶意请求可能会利用类似"生成500个世界随机城市列表"的指令,造成大量token浪费,即使单次损耗看似微不足道,放大到大规模使用时,其花费可观的金额令人警觉。MCP协议规范明确要求支持采样的客户端必须在初始化时声明采样能力,但是否启用采样功能则掌握在实现方手中。

企业在策略上,可选择在与内部信任服务器交互时开启采样,在面对外部未验证服务器时关闭,以降低安全隐患。然而,这种灵活性也带来了执行难题,因为最终依赖具体开发者的理解和执行,缺乏集中强制管理的能力。引入人工审核机制是另一条有效的安全防线。通过人机协作,任何采样请求都必须经过人工确认,有权修改或拒绝潜在恶意指令,确保每次令牌消耗都在合理范围之内。然而,该机制对用户体验产生一定影响,需要企业在便捷性和安全性之间权衡。此外,客户端可通过令牌使用上限限制来控制采样过程中token消耗量,比如对调用LLM的max_tokens参数进行合理设置,避免单次请求的暴涨。

这种策略虽好,但同样依赖开发者自觉遵守企业安全策略。真正能够在技术和管理层面有效保障采样安全的方案,是引入专业的MCP代理(Proxy)解决方案。与传统网络代理不同,MCP代理不仅仅是流量转发器,它充当了MCP服务器和客户端之间的中介,从而具备更高维度的控制能力。代理能够细粒度地管理权限,比如限制某些服务器只能调用特定功能,允许部门内部服务器采样,而屏蔽外部不可信服务器的采样请求。通过代理集中管理,可以大幅降低因三方开发人员实施偏差导致的风险,更易于统一企业安全策略,因而成为许多大型企业推崇的解决方案。随着企业智能化程度的提升,Agentic AI和MCP协议的应用会渗透到更多业务领域。

采样作为关键机制,若能被科学运营,将极大优化企业资源分配,降低人工智能计算成本,提升业务响应速度与智能化水平。但潜藏的经济风险和安全漏洞不能忽视。企业必须重视采样的双刃剑效应,建立完善的管理策略,从技术、流程和人力多方面防范钱包拒绝服务等风险。综合来看,MCP采样非简单功能模块,它是智能交互生态系统中不可或缺的关键组成。合理运用采样机制,企业既可以享受成本节约的乐趣,也能避免因安全防护不足埋下沉重的财务隐患。未来,随着更多成熟的代理技术与安全解决方案诞生,采样将在保障安全的基础上发挥更大潜能,成为企业推陈出新的重要助力。

。