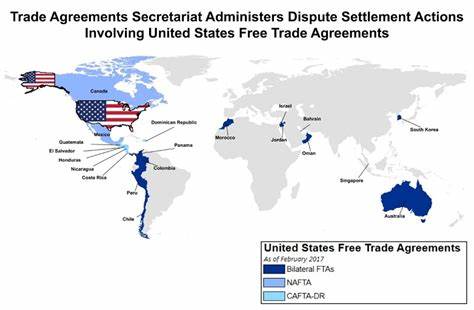

近年来,随着人工智能特别是大型语言模型(LLM)的飞速发展,GPU作为其核心计算硬件,其高效利用成为业界关注的重点。传统上,GPU被视为执行相对独立任务的计算单元,但在面对复杂推理任务时,如何通过资源的合理调度实现性能最大化,成为亟需解决的问题。借助经济学中的"比较优势"理论,有研究者提出了在GPU层面探索类似自由贸易协定的资源共享策略,以期达成整体效益最大化。比较优势是经济学中一个经典概念,指即使某个实体在所有任务上具有绝对优势,也应当专注于那些相对更具优势的任务,并通过贸易让其他实体专注于其强项,从而实现效率的整体提升。这个原理如果被引入GPU异构计算环境中,便可能显著提升大型模型推理的吞吐量和性能。以推理过程为例,它通常可以分为预填充(prefill)和解码(decode)两个阶段。

预填充阶段以计算为主,更多依赖于GPU的算力(FLOP/s),而解码阶段则受制于内存带宽的限制,因为需要快速地从显存向计算核心移动数据。不同GPU架构在这两方面的能力有所差异。例如,英伟达的H100 GPU在算力和内存带宽两方面均有绝对优势,而A100在内存带宽方面相对更有优势。如果企业拥有多类型的GPU集群,依据比较优势理论,将预填充任务分配给算力更强的H100,将解码任务分配给内存带宽更优的A100,理论上可以提升整体推理吞吐率。该思路类似于自由贸易协定中不同国家间资源优势的互补,共同获得更大利益。不过,这样的异构推理体系在实际落地时面临诸多技术挑战。

不同GPU在支持的数据类型、并行计算策略及显存大小方面存在差异。例如H100支持更先进的fp8计算格式,而A10则不支持。此外,任务在不同GPU间切换还涉及KV缓存的动态重塑和数据格式的转换,这些都需要推理引擎具备高度的适配能力和灵活性。尽管如此,一些最新论文和实践案例已经证明,具备高度优化的软硬件体系结构可以克服这些困难,实现更高效的推理吞吐。此类研究不仅挑战了传统单类型GPU任务分配的思路,也为未来云计算平台设计多样化、高效的资源调度方案提供了理论支撑和实证基础。对于云提供商和企业用户而言,合理应用比较优势原理能够帮助他们在硬件采购和任务调度上做出更科学的决策,从而降低成本并提升服务能力。

与此同时,随着GPU硬件的持续进化,涵盖更多专用加速器和高效内存子系统,如何建立灵活的跨设备推理协同机制,将成为人工智能算力优化的新方向。总之,将经济学中的比较优势理论应用到GPU推理任务分配中,是一次跨学科的创新尝试。它不仅有助于打破当前计算资源利用瓶颈,也推动了异构计算架构的发展。未来,随着技术的发展与相关研究的深入,GPU之间"自由贸易"式的资源协同将成为提高人工智能推理性能的关键路径,也将推动AI应用在更多领域的落地与普及。业界对该方向的探索也在不断加快,尤其是那些专注于推理与基础设施的团队,他们正努力研发更加智能化的调度算法和硬件接口,期望打造真正高效、可扩展的异构推理生态系统。与此同时,相关人才的需求也在迅速增长,吸引了大量计算机科学和经济学跨界的研究者投身其中。

人工智能的未来不仅是算力的竞争,更是资源配置智慧的较量。让我们拭目以待,GPU通过"自由贸易协定"实现算力协同的那一天,将会给行业带来怎样的革命性变化。 。