随着人工智能技术的飞速发展,尤其是大型语言模型(LLMs)的广泛应用,社会生活的方方面面正经历深刻变革。从智能客服、自动写作到医疗辅助,人工智能正在为人类创造巨大便利。然而,这些技术进步背后潜藏的负面影响和威胁也日益凸显,不容忽视。当前,人工智能的“暗面”逐渐成为学界、产业界乃至公众关注的焦点。人工智能系统尤其是大型语言模型,其复杂性和不可预测性引发了信息安全、隐私保护、伦理道德和社会稳定等多方面的挑战。语言模型如今能够生成极具迷惑性的虚假信息,甚至可以被用于制造深度伪造内容,虚拟人物的假新闻、误导性评论以及恶意宣传等现象日趋泛滥。

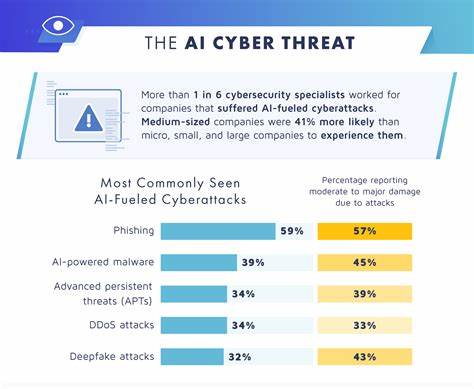

它们不仅助长了网络谣言的传播,也加剧了社会的分裂和对立。与此同时,由于模型训练依赖大量的网络数据,个人隐私数据被无意识地挖掘和利用,这引发了数据安全方面的严重担忧。人工智能系统的透明度不足,令用户难以知晓其决策过程,使得不公平的算法偏见有悖伦理,也衍生出责任归属不清的问题。随着人工智能在金融、医疗、司法等关键领域的深入应用,其潜在的系统性风险日益显现。例如,在司法领域,基于大型语言模型的辅助判决工具若存在偏见,可能导致不公正的判决,进而损害法律公正性;又如金融领域中错误的预测和决策支持可能引发严重的经济波动。此外,恶意利用人工智能制造自动化网络攻击的情况也在增加。

有针对性的钓鱼邮件、自动化诈骗、以及智能化网络入侵工具,都使得网络安全形势更加严峻。黑灰产分子利用AI技术,实现高效精准的攻击,极大挑战了传统安全防御手段。伦理风险同样突出,诸如自动生成仇恨言论、虚假身份冒充、侵犯版权和人权等问题频发,令人痛感技术发展的两面性。人工智能的无节制扩散催生了“责任真空”,谁该为机器决策的错误负责,成为亟需明确的法律和社会议题。监管层面面临重重难题。人工智能的发展速度远超传统立法节奏,使得有效监管显得尤为迫切。

如何制定科学合理的法律法规,兼顾技术创新和风险防控,促进健康有序的发展环境,是政策制定者必须解决的难题。推广伦理规范,增强行业自律,建立跨国合作的监管机制也成为必不可少的举措。与此同时,公众提高对人工智能潜在风险的认知,培养辨别虚假信息的能力,对维护网络环境与社会安全起到积极作用。技术开发者应强化道德设计理念,减少模型偏见,提升系统透明度和可解释性,保障用户的知情权与隐私安全。人工智能与大型语言模型的未来虽充满希望,但挑战依然艰巨。只有在多方共同努力下,科学应对潜在风险,完善监管体系,才能实现技术与社会的和谐共生,推动人工智能真正成为助力人类发展的强大引擎。

面对这场变革,我们必须正视“暗面”,理性思考并采取行动,才能迎接更加安全、可信和有益的人工智能新时代。