随着人工智能(AI)技术的普及和生成式AI应用在各行业的广泛部署,确保这些系统符合企业的风险管理政策变得尤为重要。特别是在受监管的行业中,往往存在由治理、风险与合规(GRC)团队制定的高层次AI风险政策。此类政策通常语言抽象,偏重于业务层面,导致技术团队难以将其具体化成为可操作的开发任务,进而影响到风险控制措施的有效落实和验证。要有效地将这些政策融入软件开发生命周期(SDLC),并确保能够持续监控与执行,需要跨部门协同、明确的策略转化方法以及技术工具的支持。本文将深度解析如何应对这些挑战,为AI风险政策的落地提供系统性的实践指导。首先,转化高层次AI风险政策的关键在于理解政策的核心意图与风险点。

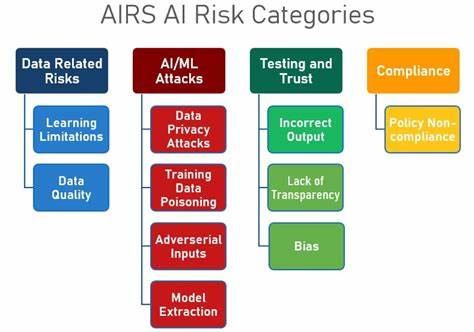

GRC制定的政策多涉及数据隐私保护、模型透明度、偏见消除、安全防护等维度。开发团队需要与GRC紧密沟通,拆解政策要求,将其分解成细化的控制点,例如数据输入验证、输出结果审查、日志记录和异常检测等。将风险政策转化为明确的需求文档是首要步骤,文档中应包含具体的可测试标准和合规指标,使开发者能够按照这些标准设计实现。其次,围绕策略转化后的开发任务,团队必须设计有效的测试用例和验证机制,以保证所实现的控制措施真实反映政策意图。测试不仅于功能性测试,更多应包含安全测试、模型行为分析、偏差检测等专业性测试手段。通过持续集成/持续交付(CI/CD)管道自动化这些测试过程,可以快速反馈潜在风险,提升开发效率和合规性。

当前许多企业在AI政策执行上尚依赖于部署后的监控机制,这虽然必要,但无法替代前端防控的重要性。结合前端自动化阻断与后端实时监测的双层风险管理架构,才能更全面保障AI系统的安全合规运行。技术工具方面,市场上正涌现多种针对AI开发与治理的专用平台。例如,AI模型监测平台能实时跟踪模型性能及输出偏差,数据治理工具保障数据质量和隐私合规,自动化测试框架可集成至CI/CD环境实现持续验证。此外,一些云服务提供商也开始推出嵌入式的AI模型管理和合规工具,助力开发团队更轻松地融入风险管理实践。不过,技术工具只是辅助,实现真正有效的AI风险政策落地还需文化与流程层面的配合。

开发团队需培养风险意识,定期参与风险评估与政策培训,确保理解控制点的重要性和运行机制。同时,管理层应构建跨职能沟通桥梁,促进GRC、开发、运营三方协作,避免信息孤岛。除此之外,AI技术本身的复杂性和不断发展使得政策制定与执行面临动态挑战。如何及时更新政策条款以应对新兴风险,如何平衡安全与创新之间的关系,都是运营中需持续关注的问题。建立反馈回路,通过模型实际使用效果和风险事件驱动政策迭代,是实现治理闭环的有效方法。总结来说,将高级AI风险政策转化成可执行的开发任务是一项系统工程,涵盖了政策解析、需求细化、自动化测试与监控、文化建设等多个方面。

企业需结合自身业务特点和技术能力,制定清晰的落地方案,利用先进工具并加强跨部门协作,才能有效驾驭AI风险,推动合规与业务的双赢发展。未来,随着AI监管规则日趋完善和技术手段日趋成熟,企业AI风险管理的实践也将不断优化,从政策制定到实施执行的全链条治理将成为保障企业安全与竞争力的关键。