近年来,随着人工智能(AI)技术的蓬勃发展,大型语言模型(LLMs)如ChatGPT和Claude在多个领域取得了令人瞩目的成果。尤其是在医疗健康领域,这些模型凭借其强大的语言理解和生成能力,被寄予厚望,以助力患者更好地解读诊断信息、导航复杂的医疗流程及提升健康管理的便利性。然而,一位专注于癌症患者临床导航的开发者经过九个月的深入尝试后,宣布将转型,理由是当前大型语言模型还未达到能够安全服务患者的临床应用门槛。该决定对整个行业具有示范意义,也揭示了许多尚待解决的核心问题。整合这一经历所折射出的技术与实践挑战,将有助于我们理性看待人工智能在医疗领域的应用前景和限制。患者临床导航作为医疗健康服务的重要组成部分,强调个体对自身疾病、诊疗方案及医患沟通的理解与掌控。

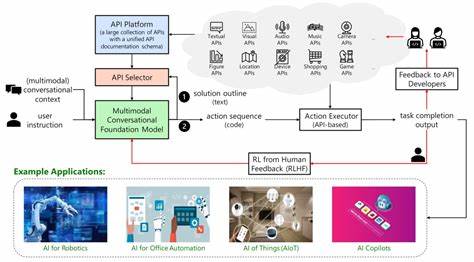

开发者以癌症护理这一高度复杂且情感负担沉重的领域入手,尝试聚焦包括理解诊断信息、辅助准备医患问诊、应对治疗副作用、探索替代疗法、赋能患者自我倡导以及病程互动记录与解读等多重关键用例。这些问题涵盖医疗知识与病患体验的多个维度,既需要精准的信息处理,也需要敏感的人文关怀。基于这一需求,他构建了多款基于大型语言模型的应用原型,包括能够从权威医疗网站抓取并注释专业术语的智能聊天机器人,支持解析海量电子健康记录(EHR)PDF文件,协助患者获得二次医学意见的深度检索工具,以及与医疗机构电子健康记录系统通过FHIR接口联动的综合性网页应用。值得一提的是,他还尝试开发一款iOS本地应用,利用苹果HealthKit数据实现病历同步与语音预约记录,旨在提供一站式的健康管理体验。然而,面对苹果频繁的应用审核拒绝,他意识到在患者隐私安全保护和平台注册规则方面,当前生态仍有极大壁垒,这一外部挑战虽促使他调整方向,但更深层次的技术难题才是根本原因。大型语言模型在临床应用中暴露出的最大问题之一是上下文信息的缺失和不完整。

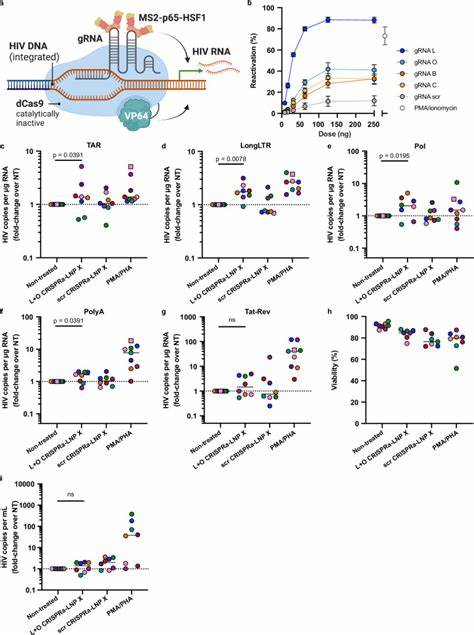

医疗数据分散在多个系统、机构及格式之间,患者个人难以完整获得全部相关病历、检查结果及诊疗记录。即便是专业医生,也需整合层层信息以形成准确判断。对于AI系统而言,面对零碎异构且缺乏实时更新的医疗数据,其背景知识构建变得极为困难,从而导致模型回答依赖于片段信息,无法全面反映患者状态,存在潜在风险。再者,AI模型的可验证性和“grounding”能力有限。即使借助检索增强生成(RAG)、功能调用和大上下文窗口等技术方法,模型依然可能产生虚假、误导性甚至毫无依据的内容。这种自信但错误的回答在医疗环境中后果严重,患者或家属极有可能因此失去对系统的信任,甚至影响治疗决策。

而且模型内部运作往往不透明,难以追踪错误来源,从而阻碍了有效的风险管理和纠正措施。更重要的问题是大多数临床决策的复杂性与人文属性远超技术分析。以癌症化疗与手术方案的抉择为例,无论是医疗专业知识、患者个体差异还是个人意愿、生活质量目标等,都使得简单的算法性回答难以满足患者和家属的情感诉求和实际需求。AI倾向于提供详尽的信息清单与正反面评价,但这可能加重患者的负担,导致焦虑和信息过载。成熟的医疗决策需结合详尽的临床考量以及心理和伦理因素,目前的模型尚无能力胜任这一层面的辅助。在商业模式方面,基于患者直面使用的付费服务存在显著挑战。

患者对健康类应用的付费意愿普遍低迷,且行业竞争激烈,免费通用聊天机器人能够给予类似但未经验证的回答,削弱了专门医疗导航工具的独特价值。同时,数据隐私和安全合规性要求极高,限制了利用患者数据变现或广告的可能。在供应链合作方面,医疗机构和支付方对于依赖尚未成熟技术的合作谨慎审慎,增加了商业化的障碍。面对这些多重难题,开发者提出了理性的反思和“转型”规划。他建议短期内更适合从教育和辅助入手,帮助具备一定能力的患者及照护者正确使用现有AI工具,提升其问题表达和信息筛选的效率,而非创建新的直接医疗建议产品。同时,他强调技术进步带来的希望,尽管视线前方还有盲区,但这种尝试丰富了对AI临床应用的理解,为未来创新铺路。

此外,他主张业界及监管部门应加强协作,推动医疗数据互操作的标准化,提升模型可追溯性和透明度,加强以患者利益为中心的技术伦理研究。总而言之,虽然大型语言模型在提升医疗信息获取便捷性方面具有革命性潜力,但现阶段的技术局限、临床环境的复杂性和商业模式的挑战,使其尚未成为适合广大患者的安全临床助手。这一事实提醒我们,在医疗创新的道路上,必须兼顾技术可行性、临床安全和人性化需求,逐步推动AI工具朝着辅助而非替代的方向演进。未来,随着数据整合能力加强、模型可控性提升以及伦理规制完善,大型语言模型有望真正实现为患者提供安全有效的临床导航服务。眼下,理性定位技术优势与局限,科学赋能患者及照护者,自我保护与慎重信任,是推动健康AI技术可持续发展的关键所在。