近年来,随着人工智能技术的快速发展,语言模型(LLM)已成为自然语言处理领域的重要工具。尤其在搜索引擎和电子商务场景中,微型语言模型以其高效节省资源的特点,被广泛应用于处理用户输入的搜索查询。然而,微型模型因计算能力和参数规模受限,容易在复杂任务中出现理解偏差,如何优化对其的提示工程,成为业界和研究领域关注的焦点。对于拼写纠正这样看似简单却实际充满挑战的任务,清晰明确的指令和少量示例这两种提示策略的优劣,各方观点不一。本文基于近期的实证数据,深入剖析这两种策略在微型LLM上的实际效果,助力从业者做出更加科学有效的选择。 微型语言模型在拼写纠正任务中的表现差异,归根结底与模型的认知机制和提示接受能力密切相关。

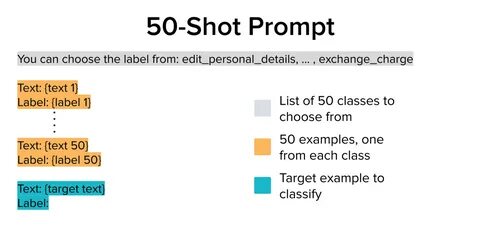

大型模型如GPT-4在面对复杂提示时能够凭借强大的上下文理解和广泛的训练经验,准确解析少量示例背后的隐含规则,实现良好的泛化能力。相较之下,微型模型受限于参数规模,对长文本或复杂提示的处理能力有所不足,容易出现遗忘指令内容或错误泛化的情况。正因如此,传统观念中「多示例少指令」往往不适用于这些资源有限的小模型。 零示例(zero-shot)策略即仅提供问题陈述,期待模型凭其内建知识进行准确回答,优势在于节省提示输入长度与计算资源。尽管偶尔能够有效纠正简单拼写错误,但面对特定领域术语、品牌名称等专有名词时,微型模型缺乏足够背景知识,易产生误判或过度纠正,从而影响纠正的准确性。相比之下,少量示例(few-shot)策略通过向模型展示若干正确处理案例,试图引导模型学习背后的纠正逻辑。

然而,实验证明,简单堆砌示例并不能保证提升模型表现,反而可能导致模型过拟合示例中既有的模式,降低对新查询的适应能力。 更有效的方法或许是为模型提供清晰、系统且简练的规则指令(rule-based prompt)。将规则直接明文告知模型,不仅减少其对示例记忆的依赖,还能确保关键纠正原则被有效传递。具体规则涵盖维持词汇边界完整、不随意拆分或合并复合词、不纠正有品牌保护的专有名词和产品名等,避免微型模型陷入模糊纠错陷阱。基于对Wayfair Annotated Dataset的测试显示,单纯的规则指令在拼写纠正任务中平均准确率显著高于附加示例的规则提示和单纯少量示例提示,验证了规则指令的实用性和稳定性。 令人感兴趣的是,结合规则和示例的混合提示并未达到预期效果,反而在某些测试中表现不及单纯规则提示。

这一反常现象可能源于示例内容与规则的重要性发生冲突,或者模型将注意力分散在细节示例上,导致忽视整体规则框架。尤其对于注意力资源有限的微型LLM而言,过多信息输入可能造成负担,影响其判断的连贯性和准确性。除此之外,示例的选择和优化也极其关键,未经过筛选和组织的示例未必具备指导意义,反而增加模型的认知负担。 优秀的提示设计应兼顾简洁与明确,确保关键信息牢固传递给模型,同时避免冗余细节干扰。针对微型LLM,直接定义明确规则,比起复杂示例往往更有效,因为这样能够减少模型的"记忆成本",降低推理过程的不确定性。例如,说明明确不纠正品牌名以及不拆合单词,能够防止模型误将有效词汇拆解或错误替换,提升整体纠正的稳定性和用户体验。

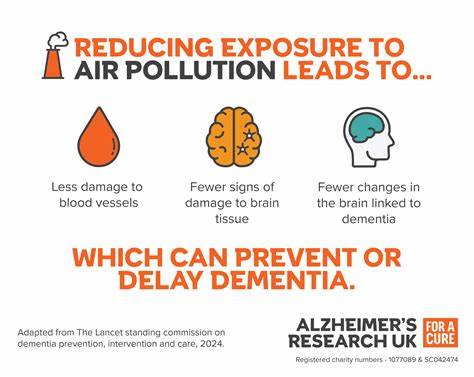

在实际应用中,如电商搜索、多语言拼写纠正等场景,用户输入多样且复杂,标注和评估准确的微型模型策略显得尤为重要。为了优化模型表现,评估不同提示方案对模型的影响,结合业务需求灵活调整,是提升查询解析系统整体效率的关键。虽然大型模型性能卓越,但在资源受限的环境下,精细的规则指导和适度简化的提示策略,能够带来更具性价比的解决方案。 未来,围绕微型语言模型的提示优化研究仍有广阔空间。借助自动化工具如DSPy进行示例优化可能有助于挖掘更具代表性和泛化能力的少量提示案例,提高few-shot提示的效果。同时,探索结合规则引擎和机器学习模型混合解法,也有望兼顾灵活性与准确率。

随着模型架构和训练技术的不断进步,微型LLM或将具备更加智能化和鲁棒的理解能力,进而推动搜索引擎和自然语言理解领域进一步发展。 总结来看,针对拼写纠正这一任务,针对微型模型需慎重设计提示策略。实证数据表明,清晰、系统的规则说明往往优于复杂的例子展示。在有限资源和模型能力受限的情况下,简洁明确的指令能够最大程度地发挥模型潜力,避免注意力分散和误判。换言之,验证了"写得清晰胜于示例泛滥"的原则,提醒开发者在新时代继续坚持理性实验和数据驱动的优化思路,而非简单依赖传统的few-shot诱导。对于希望高效利用微型LLM的开发者,深入理解模型特征和任务需求,制定科学的指令体系无疑是未来技术布局的核心。

。