随着软件规模的日益庞大和复杂,企业级代码库管理面临前所未有的挑战。数百万行代码分散在成百上千的文件和模块中,使得开发者无论是新员工入职还是日常开发,都难以快速准确地理解项目的全貌。传统代码阅读、文档查找以及静态分析工具在面对这种规模时往往力不从心。与此同时,AI辅助编程工具近年来飞速发展,但其在面对真正复杂且跨文件、多模块的大型代码库时表现仍有提升空间。为了有效衡量和推进这方面的能力,DeepCodeBench诞生了 - - 一个基于真实世界代码库及问答形式的全新基准测试体系,旨在通过现实开发过程中真实产生的问题,推动AI系统在代码理解和检索中的突破。DeepCodeBench突破了以往测试集中限于代码片段的局限,聚焦于来自实际拉取请求(Pull Requests,简称PR)中复杂代码变更的多文件、多方法场景。

这种设计反映了真实开发中的代码关联性和跨模块逻辑,增加了检索难度的同时,更符合开发者的认知需求。通过分析PR所涉及的代码块及上下文,DeepCodeBench生成了真切且具有挑战性的问题,测试系统在跨越大量相关代码时,能否准确抓取核心事实并提供简明正确的回答。该基准包含1144个经过精心策划的问题-答案对,这些数据源自八个开源大型代码库,每个问题都携带丰富的上下文信息,涵盖文件数量、代码块分布及问题类型多样化。基于对问题的分类,DeepCodeBench区分"深度问题"和"广度问题",前者针对单个代码块内部逻辑或边界情况细节,后者则考察多个模块间的交互与整体架构理解。此外,还有"核心问题",关注代码核心功能执行原理,这种细致划分有助于评估AI模型对不同维度代码理解的能力。数据生成过程中,DeepCodeBench采用最新大型语言模型(LLM)作为辅助工具,利用PR的标题和描述结合相关代码段指导模型产出满足标准的问题和答案。

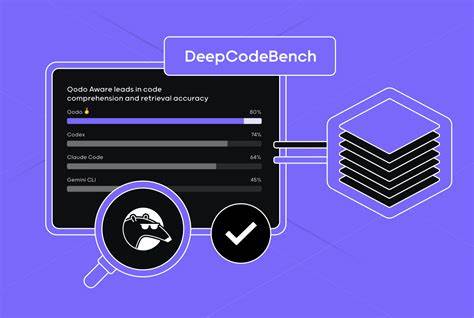

生成时,严格遵守问题不可直接引用代码行数或文件路径,且需避免过于明显的标识符指代,确保检索过程真实且具有多样性挑战。评估体系亦构建了创新方法,避免单纯依赖主观判断,借助基于事实召回的自动化验证机制对模型回答中的关键信息进行逐条核实。这一机制源于文字检索领域公认的TREC QA竞赛方法,确保评价过程公开透明且具高度可重复性。DeepCodeBench的多维评测不仅对比了OpenAI Codex、Anthropic Claude Code、Gemini等多款先进模型表现,也通过独自研发的Qodo深度研究代理展现了其在速度和准确率上的优势。具体来看,Qodo深度代理在整体事实召回率达到了约76%,略胜于Codex的74%,同时保持了快速响应,配合其高推理模式可进一步提升至80%的准确率。特别是在处理"广度"问题时,Qodo显示出更均衡的表现,反观部分模型则偏好"深度"问题。

这表明Qodo具备更强的跨文件、多模块语义搜索能力,适合应对复杂代码依赖关系。面向开发者和企业,这一基准的引入意味着AI工具能够基于真实开发场景不断迭代优化,减少开发者不得不翻阅海量代码的时间,提高代码理解效率。同时,DeepCodeBench所发布的开放数据集、详细元数据和生成提示模板,为学术和工业界提供了丰富的资源,推动更多创新工作围绕代码问答、语义搜索与代码智能检索进行深化。DeepCodeBench不仅是衡量代码理解能力的标杆,同时也是促进代码智能化管理和协作的催化剂。未来,随着持续扩充更多语言和库的覆盖范围,集成更多元化的代码变更样态,基准将进一步提升现实适用价值。在人工智能助力的软件工程大潮中,DeepCodeBench代表着一次关键的质的飞跃,帮助构建更智能、更高效的软件开发生态系统。

正如Qodo所展示,代码辅助审核、质量保障和治理平台的结合,将为软件生命周期管理带来革命性改进。面向2025年及之后,现实代码库理解和问答基准的持续发展,将成为推动行业智慧升级的重要基石,支持开发团队从复杂代码迷宫中快速找到答案,助力产品创新与质量保障迈向新高度。 。