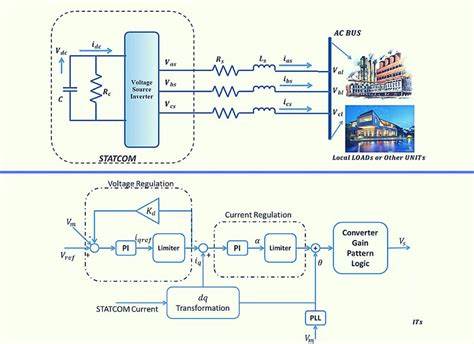

随着人工智能和自然语言处理技术的迅猛发展,大语言模型(LLM)的训练与微调成为行业内的热点和难点。训练一个优秀的大语言模型,不仅需要大量数据和算力,更面临着如何平衡模型学习新知识的能力与保持已有知识稳定性的挑战,即所谓的塑性-稳定性权衡。Shannon控制单元(SCU)作为一种基于控制理论的自适应正则化框架,对这一难题提供了创新性的解决方案,使得微调过程更智能、更高效。 Shannon控制单元的核心理念是利用信息理论和比例-积分(PI)控制算法,实时监控并调整训练中的正则化强度。具体而言,它通过最小描述长度(MDL)导出的信息比率作为反馈信号,动态控制正则化参数λ,阻止模型在学习过程中出现过拟合,同时保持对数据的敏感性和学习能力。与传统固定或手动调整λ的做法相比,SCU实现了训练过程的闭环控制,保证训练既不过头,也不流于浅尝辄止。

塑性和稳定性之间的矛盾在大规模模型微调中尤为突出。模型既要有能力快速适应新任务和新领域(塑性),又不能因微调而遗忘之前学到的重要知识(稳定性)。SCU通过实时计算信息比率S,定量描述模型参数更新相对于数据拟合的程度,并以此为依据自动调节正则化力度。当信息比率趋近于设定的目标S*时,PI控制器便会调整λ保持稳定,从而避免过度训练。 在实践中,SCU在多种模型和数据集上进行了验证,尤其是在VibeThinker-1.5B模型上效果显著。最初阶段,模型迅速恢复此前被压抑的一般语言能力,表现为困惑度(PPL)的大幅下降;但当信息比率达到饱和点时,模型若继续训练则容易导致专用能力被覆盖,产生负面效果。

通过自动增大正则化强度,SCU有效地"冻结"了权重,防止出现灾难遗忘,保持了专用知识的稳定性,同时完成了泛化性能的恢复。 值得关注的是,SCU的PI控制不仅能够动态调整正则化,还为训练过程提供了自然的停止条件。当控制器的正则化参数λ稳定在一个平衡点时,表明模型已达到MDL饱和状态,即模型已学到所有有意义的模式,进一步训练意义有限甚至有害。基于这一原理,SCU可实现"自终止训练",减少人为设定的训练步数和盲目训练带来的风险,显著提升训练效率。 此外,SCU设计中充分考虑了训练硬件和架构的兼容性。它支持CUDA 4-bit低精度加速路径,同时支持多平台回退方案,保证在不同硬件条件下均能稳定运行。

自动配置功能根据模型大小和数据规模初始化控制器参数,保证开箱即用的稳定性,有助于推广和应用。 在更大规模模型如OLMo 3 7B的微调实验中,SCU同样展现了其优越性。训练过程中,λ在一定步数后保持稳定,信息比率也紧贴目标值,验证了PI控制器平衡状态作为训练停止信号的可行性。实验对比显示,此时模型的损失函数和参数比特率均处于最低,证明此时训练最优,过度训练会带来噪声和过拟合。 除了具体的技术贡献,SCU的研究推动了机器学习训练流程中控制理论的应用。其与近期独立发展的EntroPIC项目相似,都将闭环反馈控制引入神经网络训练中,前者调控信息比率用于监督学习,后者调控策略熵用于强化学习。

两者共同验证了反馈机制在神经网络调优中的重要性和实用价值,开辟了神经网络训练与控制理论深度融合的新方向。 不过,SCU目前的验证仍以LoRA微调小到中型模型为主,尚未在极大规模的全参数预训练上深入测试。此外,其目标信息比率S*的最优值仍依赖于经验调优,缺乏普适的理论公式支持。未来研究将聚焦于推导S*的规模律,期望将其与模型规模和数据规模联系起来,实现更加自动化的适应性. SCU还亟需在特定领域任务上进一步验证其对专用能力保持的有效性,例如数学和代码生成等高难度任务。此外,与其他现代参数高效微调(PEFT)技术如DoRA、QLoRA的系统对比也是未来的重要方向。其训练和推断的API工具链设计充分便于集成和部署,支持FastAPI服务端和Python SDK使用,有助于研究人员和工程师快速尝试和复现相关成果。

整体来看,Shannon控制单元不仅提供了一种理论扎实且应用有效的适应性正则化方案,还借助控制系统的成熟机制实现了训练过程的自动调节与早停。这为大语言模型训练带来新的管理思路,既保护了模型已有能力,又能高效地拥抱新知识,兼顾塑性与稳定,降低了训练过程的调试成本和过拟合风险。随着进一步研究和实际应用推广,SCU有望成为未来大规模语言模型训练和微调领域的关键技术工具。 未来几年,随着模型规模和应用复杂度的持续增长,如何智能控制训练进程和防止模糊化能力遗忘,将成为业界关注的核心问题。Shannon控制单元通过引入闭环PI控制器,联动信息理论指标,成功打造了一个自动感知训练边界、实现精准调节的系统。它不单是一套正则化策略,更是一套智能训练节奏的管控机制。

我们期待这种方法在更大规模、更多样化的上下游任务中得到更广泛验证和完善,推动自然语言处理技术迈向更高水平。 。