随着人工智能技术飞速发展,大型语言模型(Large Language Models,简称LLM)已经成为自然语言处理领域的核心工具。无论是聊天机器人、自动写作辅助还是语言翻译,LLM都在其中扮演着不可或缺的角色。然而,许多人对它们背后的工作机制了解有限,往往将LLM误解为"黑盒",觉得其内部运算复杂且难以理解。事实上,虽然具体的参数数值不易解读,但大型语言模型的结构和计算过程是有清晰数学基础的。本文将从输入怎么被处理开始,逐步讲解LLM如何将输入转换为有意义的输出。大型语言模型的核心在于对输入文本的字符串进行分解和编码。

LLM处理的是一系列数字,这些数字代表输入文本中的"词元"或token。词元是将文本切割成较小单元的结果,可能是一个单词、一个词根,甚至一个字符或者更微小的片段。每个词元都会被赋予一个唯一的数字ID,而这些数字本身没有语义意义。例如,GPT-2的词元ID中,"cat"对应9246,而9247可能表示" upset"(注意前导空格)。因此,第一步是将这些离散且无连续性的ID映射到一个连续的向量空间,此过程称为词元嵌入(embedding)。词元嵌入是将每个词元ID转换成一个高维向量,向量所处的位置具有语义相关性,意思上相近的词元在向量空间中距离较近。

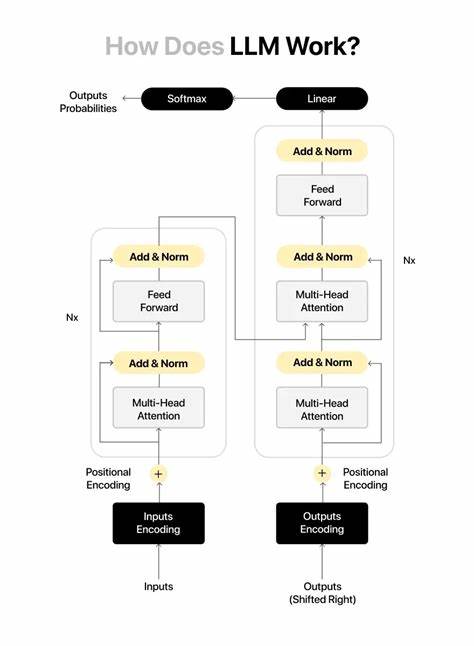

这种映射是通过训练获得的嵌入矩阵完成的,这个矩阵的行数等于词表大小,列数等于定义的向量维度。通过查表的方式,即可获得句子中每个输入词元对应的嵌入向量序列。接着,位置编码(positional encoding)被加入到词元嵌入中,为模型提供词元出现顺序的信息。由于转换器(Transformer)结构自身不具备识别序列顺序的能力,每个词元的表示都会向量相加上对应位置的嵌入,使模型能"感知"词元在句中的位次,区别不同的排列顺序。随后,经过嵌入和位置编码组合的输入序列,将被送入多层称作转换器块(transformer blocks)的结构中。转换器块是LLM的核心组成部分,包含两个主要模块:多头注意力机制(Multi-Head Attention, MHA)和前馈神经网络(Feed-Forward Network)。

每个转换器块通过层归一化(Layer Normalization)和残差连接(Residual Connection)确保信息稳定传递和梯度有效流动。多头注意力机制让模型在生成当前词元的表示时,能够"关注"先前输入序列中其他词元的重要内容。它通过学习一套投影矩阵,将输入词元嵌入映射成查询(query)、键(key)和值(value)三组向量,并计算查询与键之间的相似度(通常用点积表示),得到注意力分数。这些分数经过缩放和softmax归一化后,作为权重作用于值向量,最终生成对当前词元的上下文增强表示。单一注意力头的能力有限,但多头注意力通过并行多个这样的头,能够捕捉不同语义层面的信息,实现细腻丰富的上下文理解。层归一化操作则保持数值稳定,防止训练过程中的梯度爆炸或消失。

前馈网络紧跟多头注意力模块之后,负责进一步处理每个词元的表示。它通常是一个简单的两层全连接神经网络,借助手写激活函数(如GELU)引入非线性,增强模型表达能力,并利用残差连接保留原始信息,实现对词元上下文信息的深度"思考"。转换器块堆叠多层,共同形成强大的表达与推理能力,使模型能够预测下一个最可能的词元。预测过程的最后一步是将转换器块输出的词元表示映射回词元概率空间,实现实际的文本生成。这一步通过将高维嵌入乘以输出投影矩阵完成,输出投影矩阵一般为嵌入矩阵的转置,称为权重共享(weight tying),这既降低了参数数量,也增强了数值表达的一致性。得到的输出是每个词元词汇表中所有可能下一个词元的对数概率(logits)。

随后Softmax函数将这些logits转换为概率分布,从而选择最有可能出现的词元作为输出。于是在输入给定的上下文后,模型依次预测下一个词元,并不断将新生成的词元加入输入序列,生成连贯的自然语言文本。此整个过程被称为推理(inference)。虽然训练过程更为复杂,包括大量文本数据学习和参数优化,但推理阶段即我们日常使用LLM时的计算过程,基本就是以上描述。值得注意的是,LLM的参数权重来源于训练阶段,训练目标通常是预测序列中下一个词元,从而逐渐学习语言规律。然而,这些权重本身难以直观解释,哪怕是目前的人工智能研究人员也仅能通过消融实验或激活分析勉强获得部分理解。

相比而言,转换器结构中多头注意力的机制相对明确,提供了模型如何处理和融合上下文信息的核心线索。值得一提的是,LLM不会像人类那样有独立意识或理解能力,但通过复杂的模式学习和映射堆叠,它们能高效完成诸如对话、写作和翻译等任务。理解其内部工作原理,有助于我们更合理地设计应用,提升模型的可靠性和可控性。了解LLM推理过程中的基本计算细节,也为从事自然语言处理的研究开发者奠定基础,帮助他们优化和创新模型结构,推动人工智能技术进步。总的来说,大型语言模型通过将离散词元映射到连续嵌入空间,借助位置编码注入序列信息,经由层层的转换器块对上下文进行细化处理,最终生成下一词元的概率分布。多头注意力作为关键机制,使模型能灵活抓取不同语义层面的相关信息,实现上下文感知的文本生成。

尽管具体参数难解,但其核心结构和计算过程皆建立在坚实的线性代数和概率论基础之上,呈现出一种可解释且优雅的高维数据变换体系。随着技术不断演进,理解LLM的运作方式将成为未来智能应用开发和AI伦理监控的重要环节,推动AI技术更加安全、高效和人性化发展。 。