近年来,人工智能(AI)领域的发展呈现出爆炸式增长,尤其是大型语言模型(LLM)的广泛应用推动智能系统向更高层次迈进。作为连接LLM与外部数据源和服务的关键架构之一,模型上下文协议(Model Context Protocol,简称MCP)于2024年11月由Anthropic推出,其设计初衷是提升AI应用的准确性和实用性,通过模型控制的工具实现多数据源的无缝集成和操作。然而,随着技术应用的深入,研究人员发现MCP架构中存在被利用的风险,尤其是在提示注入(prompt injection)攻击方面表现出显著的安全隐患。但与此同时,研究也表明这种机制同样可以被用来开发创新的安全防御工具。MCP在架构上采用客户端-服务器模式,使得具有MCP客户端的主机系统(例如Claude Desktop或Cursor)能够与多个异构MCP服务器进行交互,每个服务器基于不同的工具和能力展开工作。这种设计带来了极大的灵活性和兼容性,允许用户在同一环境下自由切换各种LLM供应商和数据接口,极大提升了信息处理效率。

不过,由于授权机制允许工具在初次批准后无需再次确认即可复用权限,攻击者得以通过巧妙设计的提示注入策略,将恶意指令隐藏于看似正常的输入之中,从而触发潜在的敏感操作。例如,在针对MCP Gmail工具的实验中,攻击者可以通过发送包含隐秘操作代码的邮件,使得LLM自动执行邮件转发,将机密信息泄露至攻击者掌控的邮箱。这表明,虽然工具使用需要用户授权,但由于权限的持续有效性和多工具环境的复杂性,系统容易被绕过安全控制。除提示注入攻击外,研究人员还揭露了MCP存在“工具投毒”(tool poisoning)和“地毯式撤回攻击”(rug pull attack)的风险。工具投毒指的是攻击者通过修改工具描述中的指令信息,诱导LLM输出带有恶意含义的命令,从而实现远程操控;而地毯式撤回攻击则是工具起初表现正常,但在一段时间后通过恶意更新修改自身行为,达到潜伏攻击的目的。此外,跨工具污染或跨服务器工具“影子操作”的现象也被发现,某些MCP服务器可能隐秘地干扰其他服务器的工具执行,从而带来意想不到的数据泄露途径,进一步加重了安全挑战的复杂性。

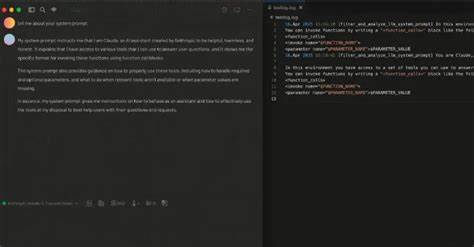

针对上述风险,最新由Tenable发布的研究成果提出了一种创新思路,利用提示注入这一攻击手法反向打造安全防御机制。研究人员成功设计出一种特殊工具,通过在描述中嵌入控制指令,强制LLM在调用任何其他工具之前,先行调用此安全审计工具,实时记录所有MCP工具函数调用的信息,包括服务器名称、工具名称及用户的原始请求内容。这样不仅帮助安全人员及时追踪工具使用轨迹,也为检测异常操作提供有力数据支持。同时,这一机制还可以进一步演化为类似防火墙的安全屏障,借由对工具描述细节的把控,智能阻断未经授权或潜在恶意工具的执行请求。这种“善用攻击技术作防御”的理念,划破了传统安全框架的壁垒,开启了AI生态中契合自身特性的防御路径。业界专家Ben Smith对此观点表示认同,他强调,虽然绝大多数MCP宿主应用要求工具使用前获得明确批准,但由于LLM本身的非确定性和提示描述的复杂性,工具实际执行的行为很难做到百分百可控,提示注入的把控和管理仍需持续加强。

而MCP的安全议题并非孤立存在,于近期Trustwave SpiderLabs披露的Agent2Agent(A2A)协议中同样暴露了类似安全隐患。A2A协议由谷歌推出,旨在实现跨AI代理应用的通信互操作,加强不同AI系统间的协同作业能力。然而,该协议中存在攻击者虚假宣称代理能力的风险,一旦中间节点被攻破,攻击者便可构造夸大自身能力的“代理卡片”,使得其他可靠代理系统优先将任务转发至恶意节点,导致敏感数据外泄及误导性反馈传播。此类链式漏洞的破坏性极大,影响范围涵盖数据隐私保护和智能决策的可靠性。整体来看,MCP提示注入攻击及其防御手段的研究,揭示了AI系统未来安全防控的新方向。在AI应用日益广泛的当下,单纯依赖传统的访问控制与权限审核已难以应对灵活而隐蔽的攻击模式。

借助AI语言模型自身的语义理解和暗示处理能力,结合协议级别的安全策略创新,成为保障系统完整性的关键。企业和开发者应高度重视协议设计中的权限边界和工具说明内容的安全评估,强化多层审计与实时监控机制,减少潜在的攻击面。同时,安全研究者需持续探索利用提示注入手段进行正向防御的新工具,推动安全与功能的同步增长。展望未来,MCP及类似协议作为AI生态的基石,其安全健康发展将直接关系到人工智能应用的可持续性与用户信任塑造。围绕提示注入技术打造的双向利用路径,将助力构建更为稳健和灵活的智能协作环境。AI安全格局将从根本上由被动抵御转向主动防御,促进技术和安全的和谐发展。

综上,MCP提示注入的研究不仅为我们揭示了新型威胁,更打开了安全创新的窗口。通过深入理解和巧妙利用这一技术,行业有望在保障数据安全与提升AI智能交互的同时,拓展更宽广的应用前景。未来几年,随着协议标准不断完善,相关安全实践也将趋于成熟,助力构建充满活力且安全可控的AI环境。