随着大规模语言模型(LLM)在人工智能领域的广泛应用,推理模型因其卓越的逻辑推理与问题解决能力,逐渐成为新兴的研究与应用热点。DeepSeek-R1-Distill-Qwen-7B作为一款具备高度推理能力的蒸馏模型,为交互式应用带来了全新可能性,但其较高的推理延迟依然成为制约广泛部署的关键瓶颈。如何将这类复杂模型优化至具备生产环境实用性,成为业界亟待解决的课题。本文将深度剖析优化DeepSeek-R1-Distill-Qwen-7B的全过程,通过量化、内核优化、张量并行及分散式部署等手段,显著提升其推理速度,实现毫秒级的令牌输出速度,满足实时交互需求。推理模型的核心优势在于其通过数千个“思考令牌”实现深入的逻辑推演,较传统即时输出的LLM模型更为“聪明”。但与此同时,因执行更多计算和内存访问,其推理速度显著下降,限制了应用场景的扩展。

DeepSeek-R1-Distill-Qwen-7B凭借蒸馏技术在保持核心推理能力的前提下,模型规模缩小至7B参数量级,初步实现了加速,但仍难以满足低延迟需求。针对这一挑战,优化团队以提高单令牌推理速度为核心目标,力图将每条令牌的推理时间从11.35毫秒缩减至3毫秒以内。实现这一目标首先需理解推理瓶颈的根源。现代GPU推理通常受限于内存带宽,模型权重的加载与内存间的数据传输成为主要耗时环节。以Nvidia H200 GPU为例,其带宽约为4.8TB/s,理论上仅需2.9毫秒即可将7B模型的全部16位权重数据加载完毕。换句话说,3毫秒的延迟目标并非法物理不可能。

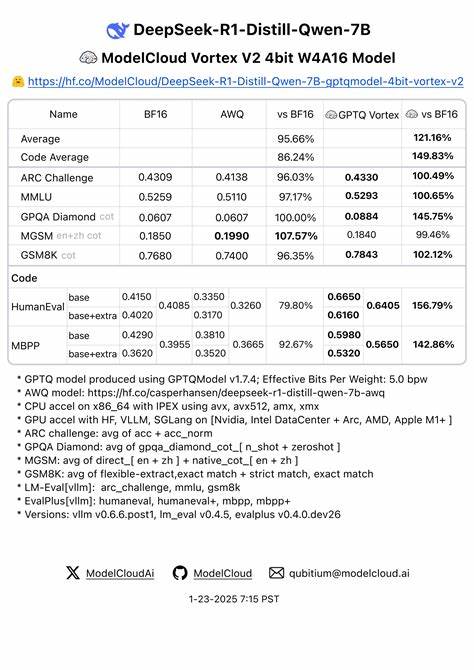

基于这一理论基础,优化工作可以从减少模型权重数据大小出发。通过保守的FP8量化,将模型参数由16位浮点压缩为8位浮点,极大缩减了数据传输量,同时保证了模型的准确度。量化后的模型在标准基准测试MMLU和GSM8K上表现稳定,基本无明显精度损失。此步便将单令牌延迟从11.35毫秒优化至6.68毫秒,接近1.7倍的加速效果。其次,在模型推理阶段替换更高效的计算内核也极为关键。TensorRT-LLM框架支持利用专为FP8模型设计的低延迟内核(如low_latency_gemm_plugin),可优化矩阵乘法及激活函数计算,进一步降低推理时间。

这种方法将延迟从6.68毫秒缩减到5.05毫秒,提升了近25%的性能。第三,张量并行技术通过拆分模型的注意力头权重,在多GPU间分摊计算负载,实现了更显著的延迟缩减。以28个注意力头为例,4卡并行的极限将单令牌延时降至3.15毫秒。尽管跨卡同步带来的通信开销及模型规模限制了性能线性增长,4卡并行所实现的性能已足以支持超过每秒300个令牌输出,极大提升了推理吞吐。第四,分离式推理服务架构带来更灵活的计算资源分配及性能优化空间。将预填充(Prefill)阶段与解码(Decode)阶段分配至不同GPU乃至不同节点,充分利用各自硬件资源,有效避免预填充阶段阻塞令牌生成过程,显著降低平均令牌间延迟。

虽然单用户场景优化幅度有限,但在高并发负载下多预填充服务器配置可将吞吐率提升率超过70%。在具体生产环境的推理负载中,思考令牌长度远超非推理模型平均输出,约为1700令牌,而非单纯的260令牌限制。这种长输出场景放大了模型的内存访问和KV缓存带宽压力,进一步制约延迟与吞吐性能。KV缓存作为加速Transformer注意力机制的关键,缓解了计算复杂度膨胀问题,但其线性增长的内存占用对流水线效率影响显著。量化KV缓存虽曾尝试,但模型敏感度高导致准确率崩溃,使该方案暂时无效。针对模型部署成本,基于现有优化方案,利用具备较高带宽的H200 GPU配置4卡张量并行,保证单令牌约3毫秒的处理时间,能够在合理预算下实现日均9万次推理请求,单次请求成本约1美分。

该效率水平足以支撑关键业务场景中实时互动及长文本推理需求。展望未来,进一步优化路径聚焦于更激进的量化方法,如6位或4位自动量化,结合分层或按层自定义量化策略,以进一步压缩模型体积。同时,Nvidia新一代Blackwell架构B200 GPU凭借超过8TB/s的带宽及原生FP4支持,有望将推理延迟进一步推低,为复杂大型推理任务带来革命性性能跃升。与此同时,训练专属的投机解码模型对加速推理亦具潜力。虽然当前针对DeepSeek-R1-Distill-Qwen-7B的兼容投机模型尚空白,行业已有资料表明,投机解码在特定条件下可实现近5倍速度提升,实际生产环境中也有1.75倍左右的加速收益。该技术未来结合自定义轻量模型,与主模型协同推理,将有效减少推理步数,进一步降低延迟。

虽然投机解码、KV缓存量化和特殊内核优化等前沿技术仍面临挑战,但通过合理分析推理瓶颈与物理限制,结合现有成熟技术,DeepSeek-R1-Distill-Qwen-7B已实现生产级推理速度突破,为构建复杂推理场景的智能应用奠定坚实基础。针对长文本高并发环境,智能负载均衡与多级分布式推理框架同样必不可少,确保模型性能发挥与成本控制的最佳平衡。总之,聚焦于基础硬件层级带宽利用率、模型量化力度与底层内核优化,将进一步推动推理模型性能极限。DeepSeek-R1-Distill-Qwen-7B亦将持续迎来新一波优化红利,支持更多元化的智能语义任务,从而推动人工智能服务更深入、更高效的产业化进程。