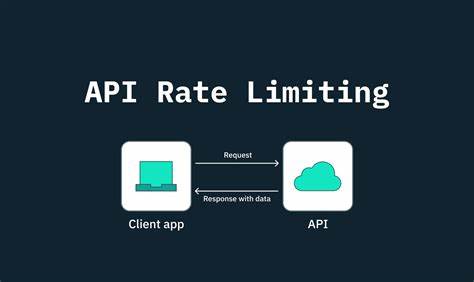

Stripe 是全球最受欢迎的支付处理平台之一,其丰富的 webhook 系统帮助开发者实时响应各种支付事件。通过 webhook 机制,应用可以即时获知账单生成、支付成功、订阅更新等关键信息,进而触发相应业务逻辑。许多开发者采用“先接收事件信号,再通过 Stripe API 拉取最新资源”的通用模式,确保处理的数据始终时效且准确。这种设计为应对重复事件、事件乱序等问题提供了坚实的保障,也极大简化了重试逻辑。然而,随着用户规模与交易量的增长,简单的“接收到 webhook 立即调用 API”的方式也暴露出明显的弊端。Stripe API 通常限制为每秒 100 次读请求,当 webhook 高峰期出现大量事件(例如月底的批量账单更新、大促期间的购买高峰)时,应用频繁调用 Stripe API 很容易触发 429 错误,即请求频率超限。

遇到这种速率限制,通常有两种应对方案:一种是让请求失败,依赖 Stripe 自带的失败重试机制;另一种则是在应用端实现复杂的重试逻辑来平稳恢复。虽然有效,但都只算是被动挨打的补救措施。要构建真正可扩展、高效且稳定的系统,必须从架构层面改进事件的接收与处理流程。理想的解决方案是将 webhook 事件的接收与处理解耦,利用像 Hookdeck 这样的事件网关,将请求排队并按照配置节流推送给应用。通过控制事件处理速度,在任何时刻都能保持对 Stripe API 速率限制的友好。Hookdeck 作为中间服务,可以完美收集所有 Stripe webhook,提供多级身份验证,自动重试失败事件,并且允许开发者设置最大事件下发速率,从而避免服务端因流量暴涨陷入瘫痪。

具体实施流程上,首先您需要在 Hookdeck 控制台创建一个与 Stripe 对接的 Connection,转换成单一可控的事件通道,并通过设置最大配送速率确保事件按可控速率到达应用服务器。在 Stripe 端,您可将 webhook 目标地址指向 Hookdeck 提供的唯一端点,并配置监听感兴趣的事件类型。Hookdeck 也手把手帮你完成签名密钥的校验配置,确保事件安全可信。应用接收到事件之后仍然采用“先拉最新数据再处理”的设计模式,但由于 webhook 已经过节流,API 调用速率被严格控制,系统再也不用担心被速率限制打断。开发者还可以通过 Hookdeck 强大的监控功能实时观察队列深度、事件延迟等指标,及时感知潜在的处理压力,做到有备无患。如果发现处理堆积过多,能快速调整最大推送速率,或者及时向 Stripe 申请提高接口调用配额。

由于采用队列节流模式,应用不仅能保证业务逻辑的准确性,也为恶劣环境下的系统稳定性提供了有力保障。值得注意的是,Hookdeck 本身提供了请求重试、身份验证校验以及丰富的日志追踪功能,极大推动了系统的可观测性和调试效率。对于开发者而言,在本地开发或测试阶段,可通过 ngrok 或 Hookdeck 自带的本地隧道功能快速搭建验证环境,并借助 Stripe CLI 工具模拟各种事件,全面测试端到端流程。总之,在高并发事件驱动架构下,单纯依赖 Stripe webhook 直接触发 API 调用,必然走向速率限制的瓶颈。通过引入专门的事件网关如 Hookdeck,结合节流派发,以及fetch-before-process 的模式,无论是从扩展性、可靠性还是运维角度,都能显著提升系统表现。对于面临月底账单集中处理、促销高峰业务激增或复杂订阅事件流的团队而言,这样的模式几乎是必备。

未来,随着业务规模持续扩大,结合云原生架构和微服务,构建完全异步、事件驱动的分布式系统,将成为支付集成方案的主流趋势。Stripe 官方与 Hookdeck 团队持续合作,共同推动 webhook 生态优化,降低开发者运维负担,为全球开发者构筑更强韧的支付基础设施。如果您的系统当前还在为 webhook 速率限制遗留问题挣扎,不妨考虑采用上述模式,借助事件队列和智能节流机制,构建符合当下互联网服务规模的支付事件处理框架,确保业务稳定且平稳成长。