随着人工智能技术的飞速发展,传统数据处理模式逐渐难以满足现代AI应用中对复杂数据管理的需求。面对结构化数据处理的瓶颈,Fenic作为一款受PySpark启发的数据框架应运而生,为AI工作流提供了全新的解决方案。它不仅重新定义了数据框架与AI推理的结合方式,更为开发者打造稳定、高效且可扩展的数据处理和推断管道提供了强大支持。 传统的数据产品构建流程通常以提取数据、加载数据仓库、执行转换操作直到数据可视化为主要阶段,这一模式在处理结构化数据时表现出色。然而,随着PDF、音频录音、图片、视频等非结构化数据的广泛应用,单纯的ETL过程变得复杂且充满挑战。大规模的OCR、语音转录和计算机视觉等预处理技术虽然极大丰富了数据维度,却也引入了诸多新的失败模式、高延迟以及成本压力。

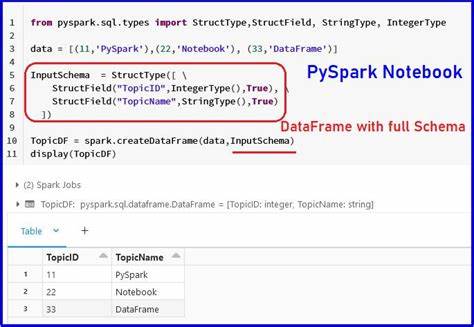

多数企业不得不应付复杂的长文本切片、模型调用限额、不同模型的效果权衡和多系统间的数据搬运,导致数据处理链条臃肿且难以维护。 Fenic的出现正是针对上述行业痛点,提出了一种简单且强大的抽象方式——DataFrame,用以结构化和管理从各种模型输出中产生的结果。DataFrame作为受数据科学社区广泛认可和传播的概念,通过表格形式组织和处理数据,带来了数据操作的确定性和规范性。Fenic继承并创新了PySpark的设计思想,通过面向AI的扩展,增强了DataFrame的语义智能处理能力,使其能够支持Markdown、语音转录文本、嵌入表示等AI原生数据类型。 这款框架的重要优势之一是其为推理流程赋予了第一类公民地位。与传统框架需依赖外部调度和手动脚本整合不同,Fenic允许用户通过声明式API定义推理步骤,而框架自身则负责管理多模型供应商的调用、处理请求限额与失败重试。

基于异步IO和并发请求批处理技术,它达到最大化吞吐量的同时,确保了生产环境的可靠性和可扩展性。此举大大降低了因多模型、多阶段管线而带来的运营复杂性,使开发者能够专注于核心业务逻辑与模型设计,摆脱繁琐的数据预处理细节。 在架构设计层面,Fenic实现了从预处理到推理的解耦,使其不仅成为AI代理系统的坚实数据基础,也改善了系统的调试与测试体验。通过在批量推理阶段做好数据准备,实时推理环节得以专注于智能决策,提高了响应速度并降低了运维风险。此外,Fenic还能够自动追踪每一列和每一行数据的来龙去脉,不论数据是如何通过不同模型产生,确保了数据血缘的透明与审计的可行性。列操作标准化了不同类型数据间的交互,为复杂业务分析和多模型融合提供了坚实保障。

除此之外,Fenic还秉持开源精神,计划将核心功能开放给社区。这不仅有利于促进本地优先开发,让用户根据实际需求选择本地或远程计算资源,保障数据隐私与安全,同时也推动了AI数据基础设施的技术边界。面对关键的隐私控制需求,Fenic让敏感数据无需上传至云端便能进行高效推理,从而应对边缘计算与混合云环境的挑战。与Apache Arrow、DuckDB、Polars等开源生态相结合,它期待成为未来AI原生数据系统发展的重要平台。 总结来看,Fenic框架通过将PySpark等大数据工具的成功经验与AI推理需求巧妙融合,为处理非结构化数据和复杂推理流程提供了一种创新且实际的解决路径。它不仅帮助企业化解多模型、多步骤推理的各种痛点,还提升了数据处理的可维护性、性能和安全性。

随着AI应用的普及和数据规模的暴增,像Fenic这样的工具将成为驱动智能化转型和数据基础设施升级的重要推手。 未来,Fenic有望在社区力量的推动下持续发展壮大,激发更多AI工作流创新。对于希望简化推理管道、提升系统透明度以及构建高效安全AI产品的开发者来说,深入探索Fenic无疑是开拓新时代AI原生数据处理领域的重要契机。