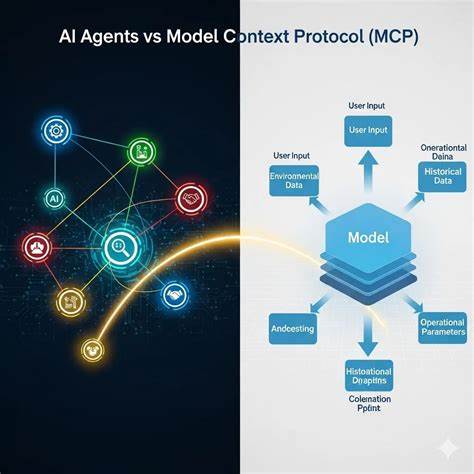

随着人工智能技术的迅速发展,如何实现不同AI模型之间高效、准确的上下文传递成为了业界关注的热点。无论是在多模态系统、多阶段推理还是跨平台应用中,上下文传递的顺畅与否直接影响着AI系统的性能和用户体验。面对这一挑战,许多研究者和工程师纷纷探索创新的方法,力图解决重复输入、信息丢失和语义歧义等难题。本文将深入解析当前主流且前沿的上下文传递策略,为读者呈现如何在不同AI模型之间搭建一座高效沟通的桥梁。 上下文传递的核心在于保留和共享关键信息,从而帮助后续模型理解之前的工作成果或用户意图。传统方案往往依赖于简单的文本拼接或手动输入,容易导致信息冗余和精度下降。

针对这一问题,研究者引入了向量表示技术,通过将文本语义转换为高维向量,实现跨模型的语义对齐。向量数据库和检索技术的结合,使得AI模型可以实时检索和融合相关的上下文内容,大幅提升响应的连贯性和针对性。 除了语义向量,知识图谱的构建与利用也为上下文传递提供了新的思路。知识图谱通过节点和边的形式刻画实体及其关系,为AI模型提供结构化且可推理的信息背景。不同AI模型可以基于共享的知识图谱实现信息的统一理解和扩展,尤其适用于复杂业务流程和领域专业知识的场景。 此外,模块化设计理念在AI上下文传递中同样表现出巨大优势。

将大型AI系统拆分为多个功能独立且高度解耦的子模型,使得每个模块专注于特定任务的处理与上下文传递。通过标准化接口和协议,各个模型能够精准传递所需信息,避免冗余输入,同时提高系统的灵活性与可维护性。 在实际应用中,流水线式的上下文传递也被广泛采用。例如,初级模型负责基础的信息抽取与预处理,后续模型再基于前者产出的严格格式化数据进行深度分析和生成。这样的多阶段传递机制不仅确保了信息的准确传递,还提升了整体推理效率。 自然语言生成模型中,利用记忆网络或可微分缓存机制亦是创新尝试。

模型通过对历史对话或任务状态进行动态编码与更新,使上下文信息能够持续存储与调用,从而避免频繁地重复提供历史信息,实现更自然流畅的交互体验。 面向跨平台的上下文共享,云端与边缘计算的协同也扮演着关键角色。通过统一的云端存储与服务接口,多个AI模型可以实时同步上下文数据,确保不同设备和环境中人工智能服务的一致性和连续性。同时,边缘设备借助本地缓存和轻量化模型,保证低延迟的上下文响应,提升用户体验的即时性。 近年来多模态AI的发展促使上下文传递变得更加复杂,涉及文本、图像、音频乃至视频的多样信息融合。创新方法包括跨模态嵌入空间的构建,使得不同形式的上下文信息能够彼此映射与交互,打破单一模态的限制,为AI提供更丰富的语义理解能力。

另外,基于强化学习的上下文传递优化策略也逐渐崭露头角。通过设计合理的奖励机制,系统能够在交互过程中不断调整传递策略,以实现更高效且准确的上下文利用,减少无关信息干扰,提升整体智能水平。 在商业和实际落地环节,上下文传递的改进带来了显著的效益。智能客服系统能够基于历史对话记录更精准地理解用户需求,推荐系统借助多阶段上下文传递提供个性化内容,智能写作和翻译工具则借助上下文记忆实现风格和语境的一致性。这些成功案例证明了上下文传递技术对于提升AI产品竞争力的重要作用。 面临未来,AI模型之间上下文传递的进一步优化方向值得期待。

包括端到端的跨模型联合训练,动态上下文筛选与摘要技术,以及更具解释性和透明化的上下文管理机制都将在推动AI系统智能化水平迈向新高度中发挥关键作用。此外,隐私保护与数据安全也需在上下文传递中得到有效保障,确保用户信息的安全与合规使用。 总的来说,AI模型间上下文传递是实现智能系统协同与高效运作的基石。从语义向量和知识图谱的结合,到模块化设计、记忆机制、云边协同以及多模态融合,再到强化学习优化策略,每一种创新方法都为这一领域注入了活力与可能。随着技术的不断进步,未来AI模型间的上下文传递必将更加智能、灵活与高效,助力人工智能迈向更广泛的应用场景和更深层次的智能交互。 。