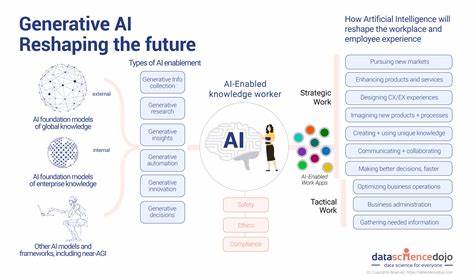

人工智能技术的崛起不仅改变了我们的生活方式,也深刻影响着信息传播和观点形成的过程。人们习惯于根据自身经验和偏见筛选信息,但随着AI算法的介入,信息的推荐和过滤越来越个性化和智能化,这也引发了一个重要问题:人工智能是否能够真正改变人们的观点?近期一项基于大型在线实地实验的数据分析为这一问题提供了有力的实证依据。此次实验涵盖多样化的参与者群体,通过AI系统定向推送内容,观察其观点偏好及态度变化,进而评估AI对思想观念的影响力和持久性。首先,实验结果显示,借助人工智能筛选出的信息能够在短期内显著改变部分用户的观点和态度。尤其是在政治立场、社会议题等敏感话题上,AI推荐的不同视角内容促使一些参与者重新审视自身立场。这一发现意味着人工智能有潜力成为促进话题多元讨论的工具,从而减少信息茧房效应带来的影响。

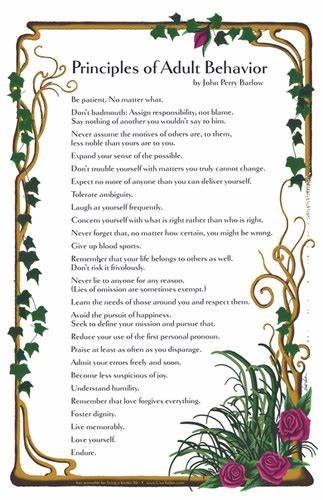

然而,深入分析也发现,观点的改变并非单向度的。用户对于AI推荐内容的接受程度受到个人先入为主的信念、信息素养和情感因素的共同影响。部分用户在面对与自身观点严重冲突的信息时表现出抵触甚至反感,这说明AI影响观点的过程复杂且非线性。此外,实验还揭示出AI在长远影响上的局限性。随着时间推移,一些用户的观点趋于稳定,即便经历初次观念冲击,也会逐渐回归原有认知框架。这种现象暗示,虽然AI可以激发暂时的思维震荡,但深层的价值观和信念体系依然具有强大韧性。

另一方面,AI系统设计和算法偏好同样决定了观点改变的方向和力度。实验指出,包容性设计、透明算法和多元内容推荐能够提升用户对AI信息的信任感,从而增强观点变动的可能性。相较之下,一些带有偏见或极化倾向的算法反而强化了分裂,加剧了社会割裂。因此,如何制定适当的AI伦理规范和技术标准成为未来发展的关键。此次实验还注重了社会心理层面的影响。观点变动不仅是信息本身的作用结果,更是群体互动、社会认同和情绪共鸣的复杂产物。

AI若能配合社交平台的互动特点,促进理性讨论和情感共鸣,则更容易实现持久的认知转变。与此同时,面对信息过载和虚假新闻泛滥,AI的辅助鉴别功能也表现出积极价值,帮助用户筛选真实有效的信息源,从而塑造更加理性的认知环境。不可忽视的是,人工智能技术的不断进步也带来伦理和隐私挑战。用户在接受AI推送内容时的信息安全和自主权需要被充分尊重。透明度和可解释性成为保障用户权益和提升系统公信力的重要因素。结合实验结果,未来人工智能应用应积极寻求平衡,既发挥技术优势促进观点多元化,同时防止算法操控和信息垄断。

总体来看,这项大型在线实地实验为人工智能对思想观念影响的研究提供了宝贵数据和理论支持。它表明AI具备促进观点开放与多样化的潜力,但其影响因人而异,深受个体心理及社会生态环境影响。要实现AI积极改变公众观点的目标,需从技术、伦理、社会三方面协同发力,推动算法透明、公正和包容性发展。未来,随着AI技术的不断成熟,结合跨学科研究成果,有望构建更具促进意义的信息生态体系,助力构建理性包容的社会舆论场。因此,理解人工智能如何作用于人类认知模式,明确它在观点形成中的优势与限制,是我们迎接数字时代新挑战、把握机遇的关键所在。