随着人工智能技术的不断进步,大型语言模型(LLM)已经成为构建智能对话系统的核心。然而,大多数 LLM 本质上是无状态的,意味着它们无法记住之前的对话内容,这严重限制了智能助理在实际应用中的个性化和连续交互能力。要想创造真正有情感、有记忆、具备深度理解能力的 AI 助手,长时记忆的引入成为关键性突破方向。本文将详细介绍如何利用谷歌最新发布的 Gemini 2.5结合开源工具 Mem0,完美实现长时记忆功能,从而极大提升对话系统的相关性和用户满意度。 Gemini 2.5作为谷歌新一代的大型语言模型,继承并优化了先前版本的自然语言理解和生成能力,它不仅具备更丰富的知识储备,同时还支持极具灵活性的调用接口,令开发者能够高效集成各类扩展功能。其中长时记忆便是一个重要的突破。

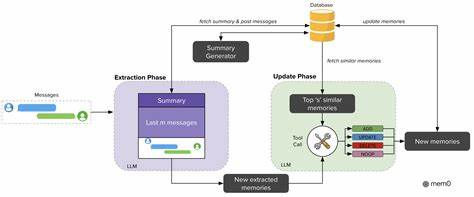

Mem0是一个专门为 AI 代理设计的开源长时记忆管理系统。它巧妙地解决了 LLM 固有的上下文窗口长度限制,通过以语义向量为核心的存储与检索结构,使得模型在任何时候都能够快速访问和更新过去的关键信息。 Mem0的核心工作机制主要分为信息提取、语义比较、记忆更新和相关记忆检索几个环节。在对话过程中,系统会借助 Gemini 2.5对用户输入和对话内容进行摘要和关键点抽取,将重要信息转换为向量形式,与过去存储的记忆进行语义相似度匹配。这种方式不仅帮助过滤重复或无关信息,还能动态调整现有记忆,实现新增、修改或删除操作。此外,通过矢量搜索技术检索最匹配的历史内容,确保生成的回答能基于用户历史偏好和需求,更加准确且高度个性化。

实际应用中,用户初次与 Gemini 2.5 聊天时,Mem0 会将对话内容结构化存储。下一次互动时,系统从海量历史数据中即时筛选相关记忆供模型参考,形成持续对话的记忆链。例如,如果用户先前提过兴趣爱好或专业背景,系统将自动带入新的交流,从而避免重复提问,也令回复更贴合实际。 为了方便开发者快速上线基于 Gemini 2.5 与 Mem0 的长时记忆机器人,本文示例的技术栈包括谷歌的 google-genai Python SDK 与 Mem0AI 库。只需简单配置 Embedding 模型(如 text-embedding-004)和 LLM(gemini-2.5-flash),并结合本地的 Qdrant 向量数据库即可实现高效的语义存储与查询体系。 在构建过程中,首先完成客户端初始化及配置设定,随后通过 Mem0 的 API 添加用户对话记录。

每次对话内容均采用消息格式封装,确保兼容性与可扩展性。此后,针对用户新问题,系统将调用 Mem0 的搜索接口,快速定位与问题语义相关的过往对话片段并注入到上下文中,辅助 LLM 更灵活精准地生成内容。 举例来说,假设某用户此前曾咨询关于欧洲山地骑行及阅读推荐的建议,系统会保留这些兴趣信息。当下次用户请求帮忙策划博客主题或演讲内容时,Mem0 能识别相关爱好,促使 Gemini 2.5 产生更具针对性的建议,如结合登山比喻类比 AI 训练过程,增强个性化代入感。 此外,构建带有持久记忆的聊天机器人不仅提升智能回复的质量,也极大降低用户反复提供相同信息的负担,使交互更加流畅自然。开发者可以通过简单的脚本部署交互循环,在关闭重启系统之间依旧保持上下文连续,满足实际业务场景对交互持久化的需求。

例如用户在第一轮对话提及所在城市天气,下一轮便能请求附近的休闲场所推荐,无需重新描述基本背景。 综合来看,将 Mem0 记忆能力嫁接进 Gemini 2.5,既解决了 LLM 无状态局限,又赋予 AI 辅助系统强大的个性化持续对话能力。未来,随着技术成熟,该方案将广泛应用于客户服务、智能助理、内容创作等领域,带来更深入的人机协作体验。 值得注意的是,为达成更高性能和稳定性,开发者在搭建时应关注向量数据库的选择与调优、内存管理策略、安全隐私保护等环节。此外,随着语义搜索和多模态技术进展,未来可结合图数据库或知识图谱等形式,进一步丰富和优化记忆系统效果。 总结而言,Gemini 2.5与Mem0的结合为构建具有长时记忆功能的 AI 对话系统提供了极具潜力的技术路径。

它不仅满足了用户对更智能、更个性化交互的需求,也推动了 AI 应用走向更深层次的理解与服务。期待不久的将来,基于类似技术的智能助理能够真正成为用户生活和工作的得力伙伴,不断学习、记忆和成长,为人类创造更多可能。