随着人工智能技术的飞速发展,越来越多的程序员开始借助大型语言模型(LLM)进行代码生成与辅助调试。这不仅改变了传统开发工作的方式,也带来了成本和效率方面的新挑战。本文聚焦一位资深用户在过去四个月中,每月花费约八百美元使用Cursor和Claude Code两大AI工具进行代码开发的真实体验,深入剖析其背后的技术逻辑、使用心得以及实战中遇到的问题和解决方案。首先,从工具选择角度来看,Cursor曾以其灵活的使用模式和庞大的上下文支持,赢得用户青睐。该用户在正式转向200美元/月的订阅方案前,曾因按使用量付费而每月支出高达七百美元。Cursor支持长达20万标记(tokens)的上下文窗口,使用户能够将大量相关代码一次性输入,从而保证AI在生成代码时拥有充足的信息基础,减少生成错误和幻觉。

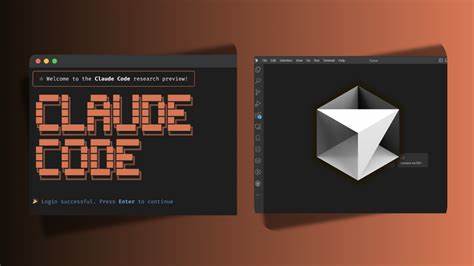

但尽管如此,有效管理如此庞大的上下文仍然是一项不小的挑战。Claude Code作为一款命令行接口(CLI)代理,理念新颖,允许程序员直接在终端甚至服务器环境中调用AI辅助编码。不过用户反馈显示,从实际使用角度来看,Claude Code的生产效率和代码质量均逊色于Cursor三倍左右。其缺乏对变更跟踪的良好支持,导致编写的代码库很快变得杂乱无章,充满了临时“捷径”与拼凑的痕迹。这一体验提醒开发者,即便AI工具理念再创新,实际落地的易用性和维护成本同样至关重要。深入理解大型语言模型的本质,是使用这些工具的关键所在。

AI模型本质上是超敏感的数学计算器,而非具有自主思考能力的“合作者”。它们对输入环境极端敏感,一点点上下文的变化都可能导致输出结果的巨大波动。换句话说,输入的准确性和完整性直接决定了输出的质量。正如时间旅行的比喻一样,微小的过去变化决定未来轨迹,输入的任何缺失或模糊都会使AI“编造”出不真实的内容,导致代码错误频发。因此,工程师需要彻底改变过去那种“让AI随便发挥”的思维方式,转而专注于“为AI精心设计输入”的思路。经验告诉我们,绝对上下文的提供无可谈判。

千万不要省略任何相关代码片段,因为模型需要明确边界,否则势必产生幻觉或错误。面对大型项目,代码架构也必须为AI服务。代码需要被精心重构为清晰、模块化、小规模的逻辑单元,这样才能顺利纳入上下文窗口内,支撑复杂任务的解决。为了应对Cursor默认限制上下文长度以节省费用,用户自行开发了基于正则表达式的命令行工具,将所有相关代码文件抓取并拼接成单一文本块,随后直接粘贴到AI对话窗口内。这种“强制喂养上下文”的技巧极大提高了代码生成的准确度。同时,对任务的精准隔离也非常重要。

给予AI明确界限和简单具体的工作范围,避免过于宽泛导致AI出“走火入魔”的表现。遇到错误代码时,切忌指望AI自我修正,那样只会陷入更深的泥潭。最佳做法是全面废弃错误代码,回退到先前状态,重新优化上下文和提示语,重新开始。整体而言,使用大型语言模型辅助编程犹如驾驭一只强力但难以驾驭的比特犬。只有建立严格的规则和提供完美的上下文才能掌控它。与此同时,模型本身也在不断变化,厂商根据反馈动态调整系统提示,因此开发者必须持续适应。

在高昂的每月数百美元费用下,合理规划用法与策略,细致打磨输入上下文,成为获得高级代码质量的关键。未来,随着模型精度提升和工具功能完善,开发者的工作流程和成本结构有望迎来新的突破。但现阶段,真正掌握与AI协同编程的核心要诀,是每一位追求高质量代码程序员的必修课。