近年来,人工智能技术的迅猛发展改变了信息传播的方式,尤其是在内容创作领域。借助ChatGPT、Claude、Grok等先进工具,任何人都可以在几秒钟内生成大量文章、社交媒体内容和营销文案。对于许多企业和内容创作者来说,这种便利看似是一场革命,为解决内容产出难题提供了新的思路。但另一方面,随之而来的大规模模板化、肤浅且缺乏真实见解的AI生成内容渐渐成为一种“噪音”,严重影响了我们对信息的感知和信任,以至于网络空间的真正“信号”被淹没。 首先我们要理解,AI虽然基于海量人类写作数据训练,具备模仿自然语言表达的能力,但其生成内容本质上依赖于算法识别模式和模板,缺少独立思考和真实体验。这导致生成的文章往往符合某些固定句式和思维套路,反复出现诸如“这不仅仅是关于某事,这更关乎于另一件事”“作为某专业领域的专家”“在当今时代”等刻板用语。

这些套路一旦频繁出现在不同作者的内容之中,便极易被读者识别,造成“千篇一律”的机械感。 这种AI泛滥内容有几个显著特点。它们通常是内容结构整洁、语法无误,但缺乏深度剖析和独特洞见。情感色彩偏向制造“深刻感”,却又显得矫揉造作,常常从平凡事情中“拔高”成过于严肃的议题,令读者难以产生共鸣。此外,形式上的装饰性元素—如强行插入的表情符号或生硬的排版—更增加了其不自然的感觉。实际上,这种内容更像是AI按照特定指令完成的“模板化回应”,为了满足数量需求,而非追求质量和价值。

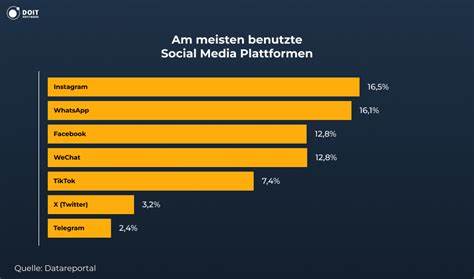

具体案例中,LinkedIn等职业社交平台成为“AI劣质内容”的重灾区。用户动态充斥着无数相似的领导力分析或管理总结,这些内容常以某个热门事件为引子,却无法给出切实有力的原创见解。比如围绕名人或公司丑闻的解读,使用大量资格头衔的堆砌和简单重复的管理学陈词滥调,整篇内容看起来更像机械回答ChatGPT提问的产物,缺乏感染力,更无独到价值。这不仅降低了平台内容的专业性,也让真正有经验的行业人士的声音淹没其中。 这类“AI Slop”(劣质AI内容)的泛滥,带来的最大隐患是信号与噪音的比例急剧降低。用户在面对海量信息时,难以辨别哪部分内容是真正具备价值的原创输出,哪部分是毫无新意的模板复制。

这种“噪音”淹没“信号”的趋势,不仅浪费了用户时间,还会淡化对作者本身和平台的信任感。长远来看,可能导致用户对所有内容持怀疑态度,乃至忽视真正有意义的专业讨论。 另外,内容质量的整体恶化,也促使部分平台算法将关注重心转向内容量而非内容质地。算法通常难以准确衡量文章的深度和原创性,反而青睐于频繁发布、流量大但缺乏内容厚度的帖子。于是,原创作者面临激烈的竞争,不得不在短时间内产出更多内容以保持曝光率,导致创新力和观察力下降,内容生态陷入“越写越浅”的恶性循环。 面对这一现象,我们并非要全盘否定AI技术的价值。

关键在于如何正确使用AI,发挥其辅助优势,而非依赖其取代人类思考。AI擅长的领域是协助梳理思路、加速资料搜集以及润色文字,而非完全生成原创作品。一个专业作者应当把AI视为头脑风暴的工具和写作的助手,而非内容创作的制造机。唯有人类专家将自身的真实经验、独特视角和深刻洞察与AI产出相结合,才能产出兼具效率与质量的内容,避免陷入毫无生气的模板雷同。 此外,在信息传播的文化层面,也需要建立新的规范和认知。透明披露AI参与度对于提升用户信任尤为重要,使读者对内容有合理预期。

增强公众和内容消费者对AI生成内容特征的识别能力,应成为现代媒体素养的重要组成部分。通过敏锐地捕捉语言模式和写作风格的细微差异,用户能够更好地判断信息来源,主动筛选真正有价值的声音。 内容创作者则应强调个性化、深度剖析和原创见解的价值,切勿将AI视为快速输出数量的捷径。通过将AI辅助写作与自身知识、行业经验融合,保持自身声音的独立性和感染力,才能在信息洪流中脱颖而出,赢得用户的长期关注与尊重。 综上所述,人工智能驱动的内容生成虽然为内容生产带来了空前便利,但也伴随泛滥的模板化劣质内容,严重制约了网络空间有效沟通和思想交流的质量。识别并抵制“AI Slop”,合理使用AI技术作为辅助工具,推动内容生态向更高质量、更真实和更具人文关怀的方向发展,是未来信息时代每一个内容创作者与消费者不可回避的共同责任。

只有如此,我们才能保障“信号”永远不会被“噪音”淹没,网络对话才能焕发出应有的活力与深度。