随着人工智能领域的不断发展,尤其是大语言模型(LLM)和智能代理的兴起,软件工程领域迎来了全新的变革机遇。SWE-Bench Pro作为一个专门设计的基准测试平台,旨在评估这些智能系统在长周期、复杂软件工程任务中的能力表现。它不仅为研发人员和企业提供评价AI模型性能的标准尺度,也推动了更智能、更自动化的软件开发时代的到来。SWE-Bench Pro的核心任务是给定一个代码库和具体问题,通过AI模型生成可修复漏洞或改进功能的代码补丁,从而真正实现软件问题的自动化解决。SWE-Bench Pro由知名团队ScaleAI推出,是基于此前SWE-Bench的进阶版本,在原有基础上增强了任务的复杂性和评测的严谨性,使得评估结果具备更高的实际参考价值。该平台公开了全面的数据集,通过HuggingFace等渠道向广大开发者开放,鼓励社区积极参与和贡献。

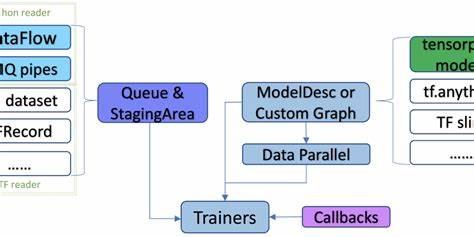

生态体系中,SWE-Bench Pro不仅提供了数据集,还配套了完整的运行环境和评估工具。利用Docker规范化执行环境,保障评测过程的可重复性和稳定性;结合Modal云服务,能够轻松扩展大规模任务的处理,显著提升效率和用户体验。为了方便模型输出的收集和分析,SWE-Bench Pro提供了辅助脚本,用于将分散的补丁文件整合成统一格式,再由强大的评估脚本进行自动化打分和性能统计。SWE-Bench Pro的评测内容极具挑战性,任务往往涉及从复杂代码库中理解业务逻辑、发现缺陷或优化点,再通过生成的补丁方案予以修复。这不仅考验AI模型的理解能力,更需展现代码生成的准确性和合理性。不同于以往简单的代码补全或短期问题解决,SWE-Bench Pro肩负着在长周期、多步骤的任务流程中持续输出高质量方案的重任。

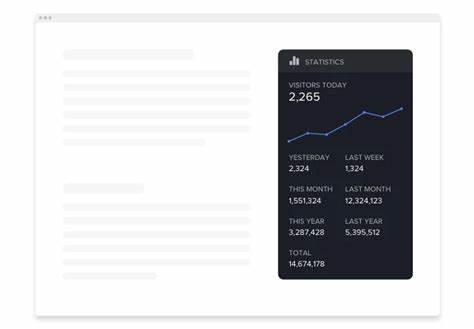

全流程评测涵盖模型产生补丁、多轮测试验证以及效果最终确认,结合了静态代码分析和动态执行结果,确保生成代码真正具备效果且符合预期需求。当前,SWE-Bench Pro已经吸引了众多研究人员和企业的关注,他们使用该基准测试验证自家模型的技术实力,并通过公开的排行榜相互竞争,共同推动技术进步。仓库维护者不断迭代优化环境配置及评估脚本,持续改进用户体验和测评科学性。此外,SWE-Bench Pro对构建未来人工智能辅助软件工程工具发挥关键作用。通过深度学习技术训练的智能代理不仅能加速软件开发流程,还能大幅提升代码质量,减少人为错误。随着模型参数规模扩大及训练方法多样化,AI在复杂工程任务中的表现有望进一步提升,带来革命性影响。

作为使用SWE-Bench Pro的实践指南,开发者可通过官方仓库获取完整的代码和数据,利用事先构建好的Docker镜像快速搭建测试环境。系统支持多种模型接口,方便集成主流AI平台,借助示例配置文件调整参数,灵活适应不同场景需求。保证评估结果的可靠性,同样需要关注环境依赖和执行策略,例如合理设置任务超时、资源限制及日志采集,避免因外部因素影响整体公平性和结果稳定性。从更广泛的角度看,SWE-Bench Pro标志着人工智能参与软件工程进入新阶段,从简单自动化向智能化问题解决演进。它促使行业重新思考软件开发流程,激发创新思路与合作模式。企业可借助该平台的测试结果选型合适的AI方案,提高研发效率和项目质量。

未来,SWE-Bench Pro可能融入更多实际业务场景和多语言支持,结合自然语言理解、代码质量评测及安全性检测,构建全方位的软件工程智能辅助体系。与此同时,社区生态将围绕数据集扩充、模型设计和评估指标展开深度合作,推动开放创新。综上所述,SWE-Bench Pro不仅是评价AI模型解决长周期软件工程任务能力的重要工具,更是智能软件开发时代的加速器。它帮助开发者准确把握当前技术水平,推动人工智能赋能软件工程从概念走向实用。随着技术不断完善和社区持续努力,SWE-Bench Pro将为未来智能化软件开发奠定坚实基础,带来更加高效、可靠的工程实践体验。持续关注并积极参与SWE-Bench Pro的生态建设,不仅能洞察AI技术发展趋势,更有机会塑造行业未来,开创软件工程与人工智能融合的新篇章。

。