随着人工智能技术的迅速发展,AI在许多数字化环境中展现出卓越的表现,如推荐系统、内容审核以及广告投放等。然而,当涉及到更为复杂的物理世界时,AI的表现依然面临巨大挑战。这些挑战主要源于物理环境的多样性、不确定性以及动态变化,传统的数字环境中适用的规则难以直接应用。视觉语言动作模型(Visual Language Action Models,简称VLAM)应运而生,成为破解AI物理世界理解难题的一道关键突破口。 视觉语言动作模型是结合视觉感知和自然语言理解,以实现对物理场景中动作和事件的深度识别与推理的创新性AI框架。VLAM不仅仅是单纯的视觉识别或语言处理,而是将视觉信息与动作语义紧密结合,使AI能够"看懂"并"理解"复杂的物理操作,从而具备更强的因果推理能力和环境适应能力。

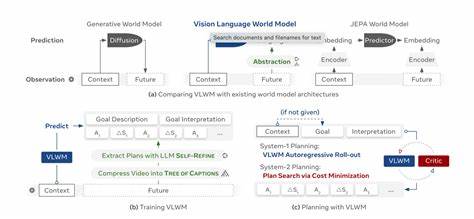

理解VLAM的核心,需要先了解其构成要素。首先是视觉模块,它负责从视频或图像序列中提取动态变化的信息,包括物体的形态、位置、运动轨迹等。其次是语言模块,通过自然语言描述或指令,将视觉信息进行语义映射,比如识别用户的动作指令或环境中的事件描述。最后动作模块则将视觉和语言信息融合,生成对物理动作的理解和预测,实现对环境变化的响应和操作。通过这三个模块的协同工作,VLAM为人工智能在物理世界的感知与决策搭建了坚实的桥梁。 近年来,随着计算机视觉和自然语言处理技术的进步,VLAM在多个场景展现了强大潜力。

在智能机器人领域,VLAM使机器人能够通过视频观察学习复杂任务,如装配流程、物体搬运甚至协同工作等。相比传统的基于预设规则的机器人控制,VLAM允许机器人根据实时视觉信息和语言指令即时调整动作,提高了灵活性和自主性。 此外,自动驾驶和智能监控系统也从VLAM中受益匪浅。通过视觉语言动作模型,系统不仅能够识别交通标志和行人动作,还能理解潜在的互动关系及未来可能的行为路径,从而做出更安全、合理的决策。这种基于动作理解的推理能力大大增强了AI在复杂交通环境中的应变能力。 推动VLAM发展的技术包括深度学习、时序建模和多模态融合。

利用卷积神经网络和图神经网络,视觉模块能够更精准地捕捉空间和时间特征。结合循环神经网络或变换器模型,语言模块实现了对语义的深层次理解。同时,融合模型打破了传统单模态的局限,将视觉和语言信息在统一空间中映射,提高了系统的整体推理能力。 然而,VLAM依然面临诸多挑战。首先,物理世界的多样性和不可预测性要求模型具备很强的泛化能力,避免过度依赖训练数据中的特定场景。其次,视觉和语言信息的噪声以及模态间的不匹配也会影响模型性能。

为了提升鲁棒性,学界提出了包括数据增广、自监督学习以及跨模态对齐等多种优化策略。 未来,随着算力的提升和数据资源的丰富,视觉语言动作模型有望实现更高层次的物理世界智能理解。结合增强现实(AR)、虚拟现实(VR)和边缘计算技术,VLAM将在智能制造、智慧医疗、家庭服务等领域发挥深远影响。通过赋予机器更接近人类的感知与推理能力,人工智能将真正实现从数字世界走向现实世界的跨越。 总之,视觉语言动作模型作为连接视觉认知与语言理解的重要桥梁,为人工智能理解和交互物理世界提供了全新的范式。其不仅提升了AI系统的解释力和适应力,也为未来自主智能体的发展开启了无限可能。

随着研究的不断深入和应用场景的快速拓展,VLAM必将成为推动智能时代迈进的重要引擎之一。 。