随着人工智能技术的迅猛发展,大语言模型(LLM)在自然语言处理、智能回答、文本生成等领域展现出无与伦比的能力,深刻改变了人机交互方式。然而,模型推理的高计算成本与延迟问题依然是制约其大规模落地的关键瓶颈。为了兼顾推理效率与结果质量,研究人员持续探索更加高效的推理策略。近期,有关Speculative Cascades(推测级联)这一创新混合推理机制的研究,成为推动大型语言模型推理迈向智能化和高效化的重要突破。推测级联在保持输出质量的前提下,大幅度缩短推理时间并降低计算资源消耗,为未来智能应用的发展注入了全新动力。一般而言,传统LLM推理所面临的挑战主要包括模型体积庞大、推理时长较长及高昂的计算资源消耗。

在实际应用场景中,用户反馈需求瞬息万变,如何实现推理响应快速且保持高质量成为业界关注的焦点。早期为提升推理效率,研究人员提出了两种主要策略:级联(Cascades)和推测解码(Speculative Decoding)。级联策略通过先由较小、较快的模型处理输入任务,若该模型自信足够则直接输出结果,若不够自信则将任务交由更大、更强的模型执行,从而避免不必要的计算资源浪费。该方法实现了计算资源的合理分配,使大模型只应对真正复杂和高精度需求的任务。但是级联方法存在一个固有的缺陷,即处理流程为先后顺序,有时因小模型判断不足而导致整个流程延长,降低整体推理速度。另一方面,推测解码是采用小模型来快速生成后续多个令牌的草稿版本,再由大型模型并行验证这些草稿令牌是否与其自身的预测一致,若验证通过则大模型同时生成多个令牌,从而有效提升推理速度。

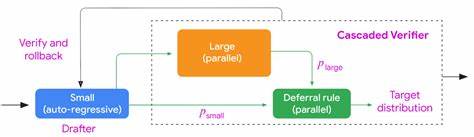

推测解码保证了大模型输出结果与单独推理时的一致性,极大减少推理延迟和提升吞吐率。然而,其缺点在于对草稿令牌的严格匹配规则,导致有时草稿被整体拒绝,浪费了小模型的推测优势,且验证过程中仍需耗费较大计算资源。Speculative Cascades正是在上述两种技术的基础上,提出的创新性融合方案。该方法保留了级联模型先行试探的思路,同时引入推测解码的并行验证机制,但最核心的改进在于采用了灵活的"延迟规则"(Deferral Rule)。这套规则可以动态判断在逐令牌层面接受小模型草稿还是交由大模型精确推理,避免了传统推测解码中严格的一对一令牌匹配要求。具体而言,Speculative Cascades允许根据多种因素,如小模型与大模型的置信度差异、令牌的重要性以及计算成本收益分析,来决定是否继续采用小模型生成的令牌串。

此种灵活能有效减少推理过程中的序列阻塞,提升速度,同时兼顾结果质量。假设用户提出"布兹·奥尔德林是谁?"这一简单问题,小模型迅速生成简明准确答案,大模型同步进行评估。若延迟规则判定小模型答案在合理置信度范围内,系统立即采用小模型结果,节约了启动大模型全面推理的时间。该机制既融合了级联在成本控制上的优势,又结合了推测解码在速度优化上的优点,实现了更为高效的推理过程。Google研究团队在多项自然语言处理任务上,如文本摘要、翻译、推理计算、编码生成及问答系统测试了Speculative Cascades技术。实验数据表明,该混合方法在推理速度和生成质量之间实现了更优平衡,较传统级联和推测解码分别取得显著性能提升。

Speculative Cascades不仅在数学题推理任务上表现出更高的正确率与响应速度,还在多语言理解和复杂指令执行中展现更稳定的输出质量。此外,这一策略通过自适应调节延迟规则,使得不同应用场景下均可灵活调整质量与效率的侧重点。技术上,Speculative Cascades基于自回归采样的小模型快速生成草稿文本,大模型并行进行草稿校验,这一过程通过联合概率分布和自定义类比权衡函数提升判定精确度。如此一来,整个推理管道可以实现多次草稿-验证循环,以小步快跑的策略快速逼近最终高质量答案。值得一提的是,Speculative Cascades方法的可扩展性强,对于未来更新换代的各类小、大模型均适用。它为低成本设备和资源受限环境中部署大型语言模型提供了新的思路,有效拓宽了LLM技术的应用边界。

展望未来,随着人工智能渗透到更多工业和民用场景,如何平衡模型推理的快速响应与结果可靠性将成为关键指标。Speculative Cascades作为一种融合式智能推理架构,将有望成为支撑下一代智能系统后台引擎的核心技术之一。企业可借助此方式在保证用户体验的同时,降低部署和运行成本,提升AI服务商业化能力。整合大模型强大的语言理解与生成能力,小模型灵活高效的协作机制,Speculative Cascades不仅实现了性能上的跨越,更为AI推理策略设计开拓了前沿视野。作为推动智能交互和AI赋能的革命性工具,它同样彰显了未来技术研发以用户需求为导向,追求极致效率与高品质创新的必由之路。总之,Speculative Cascades突破传统推理局限,结合级联与推测解码优势,打造了一种兼具速度、质量与灵活性的混合推理框架。

它不只是单纯的技术迭代,更多体现了思考计算资源合理利用与智能决策机制的深层创新。正因如此,这一方法有望引领大型语言模型推理进化,为智慧生活和工作场景注入前所未有的高效体验,是未来人工智能发展的重要里程碑。 。