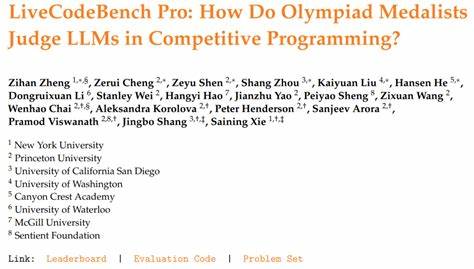

近年来,随着人工智能技术的飞速发展,大型语言模型(LLM)在自然语言处理、文本生成等领域取得了令人瞩目的成就。尤其在编程辅助和竞赛编程领域,LLM展现出越来越强的能力,有研究甚至声称其表现超越了人类顶尖选手。然而,真实情况到底如何?奥林匹克信息学竞赛(如IOI、ICPC以及Codeforces比赛)金牌得主们如何评价这些模型?LiveCodeBench Pro作为一项创新的基准测试项目,为我们揭示了该领域内更加细致和客观的答案。LiveCodeBench Pro是由一群国际顶尖竞赛选手组成的团队打造的基准库,它收录了包括Codeforces、ICPC和IOI等知名比赛中的精选题目,并通过持续的更新确保题目的新颖性和对训练数据的去污染特性。此外,项目团队逐题进行标注,涵盖复杂的算法类别,并对模型生成的代码失误展开逐行剖析,帮助识别模型的知识盲区和推理缺陷。通过这种专业层面的评判,LiveCodeBench Pro不仅提供了一个衡量LLM能力的权威标准,更为未来的模型改进提供了明确的诊断方向。

从最新公布的测评结果来看,尽管最前沿的语言模型在代码实现的精确性上取得了显著进步,但其整体表现依旧难以媲美经验丰富的奥赛金牌选手。例如,在中等难度的编程题目上,最佳模型的首次通过率大约为53%,而在困难题目上通过率则为零。而这些“困难题”恰恰是高手们的强项,通常涉及复杂逻辑推理、深入的算法设计以及多案例的严谨分析。该观察明确指出了当前大部分LLM在算法推理和复杂问题处理上的显著短板。具体来说,模型更擅长处理代码实现密集型的任务,比如直接翻译清晰描述的逻辑为程序代码。但当涉及到需要精密算法思考、细致边界条件拆解及多层次思路嵌套的题目时,模型往往会自信满满地给出错误答案,并伴随不合逻辑的解释。

这样的现象反映了模型在“理解”层面的深度依然不足,推理能力尚未达到人类专家的综合水平。值得注意的是,当前LLM在竞赛编程中的高表现,更多是依赖工具链的辅助能力和良好的编码规范,而非真正的算法创新或推理提升。这意味着,未来提升模型能力的关键,不在于单纯增加参数或数据量,而是在优化模型的推理机制、强化多步骤逻辑判断和增加对复杂算法框架的理解。LiveCodeBench Pro为研究者和开发团队提供了极为宝贵的微观视角。通过奥林匹克金牌选手的深度标注和极具专业水准的错误诊断,模型能力的不足得到了清晰的定位。该基准不仅是评价工具,更是一面镜子,映照出当前技术瓶颈和可改进的领域。

随着模型架构的演化和知识融合技术的发展,预计未来版本的LLM将在难度更高的竞赛题上展现更加接近人类专家的水平。LiveCodeBench Pro的持续更新和数据丰富性,也将助力构建更完善的训练环境,避免训练数据泄露带来的评价偏差,保障评测的公平公正。总的来说,LiveCodeBench Pro通过严谨的竞赛题库和专家级别的深度分析,揭示了大型语言模型在竞赛编程领域的真实现状。虽然当前模型在代码实现层面日益强大,但其推理和算法分析能力仍有较大提升空间。借助该基准的洞察,未来的研究与开发能更有针对性地改善技术瓶颈,推动人工智能竞赛编程能力向人类顶级选手靠近甚至超越。对于编程爱好者、竞赛选手以及AI研究者而言,LiveCodeBench Pro不仅是一面检验工具,更是前瞻未来智能编程发展的重要里程碑。

。