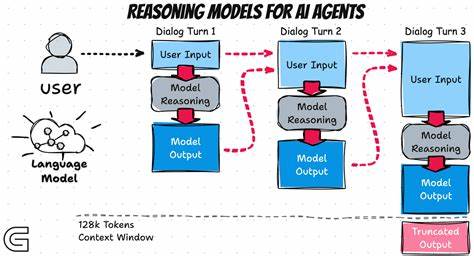

人工智能技术的快速发展让大型语言模型(LLM)成为业界和学术界关注的焦点。近年来,以OpenAI的GPT系列、Anthropic的Claude等为代表的LLM,在自然语言处理、代码生成、知识问答等方面展现了卓越能力。然而,关于这些模型是否真正具备“推理”能力,却引发了持续的争议和分歧。近期,苹果公司发布的一篇预印本论文再次点燃了这场辩论,声称现有的所谓“推理”模型在面对复杂推理任务时表现不佳,只是通过记忆模式进行模式匹配,缺乏真实推理能力。该论点引发了行业内外广泛关注与热议。苹果论文的核心问题在于对推理能力的测试方法及其解读。

论文选择了类似汉诺塔(Tower of Hanoi)这样需要严格且长序列执行步骤的经典推理问题,要求模型按步骤输出而非给出算法或近似解。但由于问题的复杂度呈指数增长,模型在上下文长度和生成能力受限下,无法完成输出所有操作步骤,导致准确度骤降至零。此结果被媒体和部分舆论解读为LLM不具备推理能力,似乎揭示了大模型的本质弱点。实际上,专家和研究者对此结论持有不同看法。第一,推理过程本质上涉及对序列中间状态的持续记忆,上下文长度有限成为客观硬伤。一些专家指出,无论是人类还是机器,都难以一次性完成数百万步骤的推理;而且部分程序化方法可以通过写代码间接实现,而非直接生成全部步骤。

第二,模型展现的“中断思考”、减少token使用等行为符合其训练中学习的推理成本权衡机制,即在资源有限时选择启发式或近似解而非穷举式推理。第三,虽然苹果测试的几个具体模型在长上下文推理中表现下降,但尚未涵盖最新且更强大的版本,后者在内置代码执行和记忆增强方面进步明显。第四,学界强调“不会”与“不能”是两回事,不完成任务不必然是能力缺失,可能只是资源、策略限制。更深层次来看,此次讨论反映出学术界和产业界对“推理”定义的分歧。传统上,推理被视为严格逻辑演绎和步骤明晰的过程;而现代大模型擅长基于语言上下文的概率推断与关联模式学习。二者虽有交叉但并不统一。

业界常把基于token预测的多步信息处理称为推理,而严苛的逻辑演绎则更多属于经典AI研究范畴。再者,训练中强化学习(RL)令模型能够模拟“思考”的行为,输出更具连贯的推理链,提升任务完成效果,尽管其中涉及的大多数操作仍是基于统计关联而非真正的逻辑理解。此类“准推理”能力在多项语言计算任务中带来了质的飞跃,也是当前应用成功的关键。负面报道和媒体夸张解读造成了公众对LLM能力的心理落差。很多观点过度简化了学术论文内容,将模型面对超大复杂度任务自动失败归咎为“不会推理”,忽略了上下文长度限制、模型的推理策略选择以及具体测试设计都对结果产生重要影响。部分专业人士提醒,限制前提下的失败并非能力缺陷,也不等价于推理不存在。

特别是当测试任务设计本身就是超出现有长文本处理范围时,模型自然不会展现该能力,如同人类在时间极限下也无法完成类似问题。围绕LLM推理的未来研究和改进方向主要集中于几个方面。首先,扩展模型上下文长度,增强长文本的记忆与状态管理能力,实现更复杂多步任务的连续推理成为核心目标之一。其次,结合代码生成与执行组件,使模型不仅输出推理步骤,还能调用程序辅助验证和执行,突破传统语言模型纯文本生成的瓶颈。第三,设计更合理的任务和评测框架,避免将不现实超大规模持续生成的失败误判为推理能力的缺失。第四,发展混合模型架构,融合神经网络与符号推理方法,提升模型推理准确性和可解释性。

纵观整个争论,苹果论文无疑推动了学界反思LLM能力边界和测试设计合理性的进程。它揭露了当前多数大模型在超长序列复杂推理上存在的技术瓶颈,但也提醒我们不能以点概全、断章取义。推理在人工智能中是一个多层次、多维度的概念,不同类别模型所展现的推理形式各异。期待未来随着模型架构、训练方法以及硬件资源的不断提升,LLM能够突破上下文和推理深度限制,真正实现更具逻辑性和系统性的智能推理能力。与此同时,学术界和产业界应加强沟通,推动更科学理性地传播研究成果,避免误导公众认知。总而言之,LLM的推理能力是一道未解的谜题,既包含机遇也充满挑战。

我们看到真实的进步,也必须直面现实的技术限制。只有不断厘清概念,精细设计实验,结合多学科力量,才能真正“给出一个理由”(Give Me a Reason),让人工智能的推理梦扎根并开花结果。围绕这一话题的讨论,既是AI领域技术发展的缩影,更反映出人们在数字时代对智能本质的深刻追问。