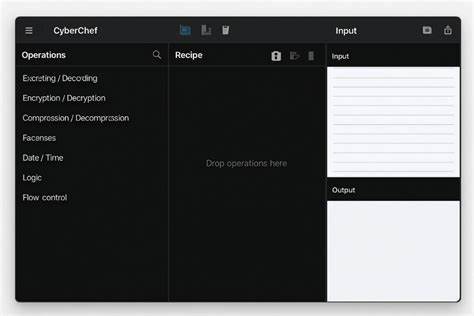

CyberChef 是由英国电子情报中心 GCHQ 开发并开源的可视化数据处理工具,因其直观的拖拽式界面和丰富的"operations"集合,成为数字取证、渗透测试和日常数据转码任务中的利器。想要在本地搭建并参与开发或定制化,理解其安装流程、依赖关系和构建脚本是第一步。本文聚焦于如何在本地环境中获取源代码、安装依赖、运行开发服务器、生成生产构建以及探索仓库结构与扩展机制,旨在为开发者和安全从业者提供可操作的参考。 安装前的环境准备至关重要。CyberChef 为前端单页应用并使用 Grunt 构建系统,要求在类 Unix 环境中进行开发,推荐在 Linux 或 macOS 上操作。Node.js 版本需匹配仓库的要求,文档建议使用 Node 18 与 npm 8,使用 nvm 管理 Node 版本可以避免系统范围冲突。

还需要 Git 用于克隆仓库。基础环境准备完成后,通过 git clone https://github.com/gchq/CyberChef.git 拉取代码仓库,并切换到仓库根目录执行 npm install 以安装所有依赖包。 执行 npm install 之后,可能会遇到内存不足导致构建失败的问题,尤其是在生成生产版本时。可以在 shell 配置文件中添加 export NODE_OPTIONS=--max_old_space_size=2048 来扩大 Node 的最大堆内存。仓库也提供了 npm run setheapsize 脚本来临时设置该值,但不会持久化到新的终端会话中。准备工作完成后,可以使用项目提供的 npm 脚本进行开发或构建。

启动开发服务器只需运行 npm start。该命令会在本地 8080 端口启动一个静态服务器,加载未压缩的开发版本。开发期间每当源代码发生修改,工具会自动 rebuild,浏览器可直接访问 localhost:8080 进行实时调试。开发服务器的便利在于快速迭代界面和操作逻辑,同时保持对源码的直接可见性,适合添加新功能或调整现有操作的实现。 当准备发布或部署到生产环境时,运行 npm run build 会执行 lint、测试、编译与压缩等步骤,最终在 build/prod/ 目录下生成生产就绪的版本。该构建版本包含压缩后的静态文件,可直接部署到任何支持静态托管的服务器上,例如 nginx、Apache 或通过 CDN 分发。

为了兼顾体积与性能,生产构建会进行 tree-shaking、代码拆分以及资源压缩,从而显著减少前端加载时延。 CyberChef 还提供将项目打包成 Node 库的能力,以便在服务器端或脚本中复用其操作集合。运行 npm run node 会生成 NodeJS 可调用的包,详细的 Node API 文档在仓库 Wiki 中有单独章节。通过 Node API,用户可以将 CyberChef 的流水线功能集成到自动化流程、后端服务或批处理任务中,实现对输入数据的统一处理和流水线化转换。 仓库结构清晰,便于定位源码与扩展点。src 目录下是核心代码,包括 core、config、modules、lib、errors、operations 与 web 等子目录。

core 包含应用的基础模块,config 用于配置操作行为与默认值,operations 存放每个独立操作的实现逻辑,web 目录包含前端页面的具体实现。styles 与 html 相关资源分别位于 css 与 html 文件夹。构建产物会输出到 build/prod。了解这些目录有助于快速定位需要修改或扩展的代码位置,例如新增一个自定义操作时,应主要关注 operations 与 config 两个目录。 CyberChef 的操作模型设计直观,每个 operation 包含元数据、配置项与执行逻辑。操作能够单独测试,并在 UI 上通过拖拽添加到"recipe"中形成处理流水线。

操作之间以数据管道方式串联,支持多种数据格式与编码转换,覆盖从简单的 Base64、Hex 编码到复杂的密码学变换与文件格式解析。添加新操作时,应遵循仓库的操作模板,提供相应的测试用例,并在 config 文件中注册以便 UI 识别与加载。 对于希望贡献代码的开发者,仓库提供了完整的测试与 CI 支持。运行 npm test 会执行已配置的单元测试和操作测试,确保新增功能或改动不会破坏现有功能。贡献流程通常包含创建分支、实现功能、编写或更新测试用例、运行本地构建与测试、并通过 GitHub 提交 Pull Request。开源项目维护者通常希望提交遵循代码风格指南、文档完善并带有可复现的测试。

CyberChef 还实现了"Magic"功能,用于自动检测输入数据的编码或格式。这一特性在处理未知来源的数据时非常有用,能够智能推断可能的解码步骤并推荐相应的操作链。Magic 的实现涉及对常见编码特征的模式匹配和启发式规则,用户在使用时可以选择自动建议或手动调整,以便针对特殊数据进行精确处理。 在实际应用中,CyberChef 非常适用于取证分析、日志解析、批量数据清洗与可视化预处理。通过构建定制的 recipe,调查人员可以记录与共享处理流程,从而保证数据处理的一致性。对于需要高度自动化的情境,可以将 recipe 转换为可以在 Node 环境下运行的脚本,通过 Node API 在服务器端对大量数据进行批处理。

性能优化方面,开发者需要注意操作的复杂度与数据传输开销。某些操作在处理大文件或大量数据时可能成为瓶颈,此时建议在设计操作时采用流式处理或分块处理策略,避免一次性加载整个文件到内存。对于 UI 层,可以采用虚拟化技术来渲染大型数据列表,减少渲染开销以保证交互流畅。 安全与合规方面,CyberChef 是以 Apache 2.0 协议开源的,允许在商业项目中使用与修改,但仍需注意第三方依赖的许可证与安全风险。在处理敏感数据时,建议在受控环境中运行,注意日志与临时文件的管理,避免在公共部署中泄露未加密的原始数据。部署到生产环境时,应采用 HTTPS、合理的访问控制与监控策略,监测异常访问模式与潜在滥用。

对于 Windows 用户,官方指出主开发环境以 bash 为主,因此在 Windows 上的构建和开发并非官方支持。但通过 WSL(Windows Subsystem for Linux)或在 Docker 容器中运行完整的 Linux 开发环境,通常可以获得与原生 Linux 相同的体验。Docker 化能带来可复现的开发环境,减少本地依赖冲突,并便于 CI/CD 管道中集成构建与测试步骤。 在自定义主题和界面方面,项目支持通过 css/themes 的样式文件进行风格替换与视觉调整。企业或团队在内网部署时,常常希望调整默认配色或隐藏不必要的操作,以便符合内部安全策略或品牌规范。通过修改主题文件和前端配置,可以快速实现界面定制化,无需更改核心逻辑。

新手在上手 CyberChef 时可以从官方仓库中的示例 Recipe 和常见操作开始练习。了解 Base64、Hex、URL 编码等基础操作的输入输出关系,熟悉字符串处理、正则替换与分块操作后,再探索更高级的密码学或解码操作。实践中将真实案例作为练习题,有助于深入理解操作之间的耦合与组合方法。 社区资源丰富,项目在 GitHub 上活跃,Issues 和 Discussions 区域是解决问题和获取帮助的重要渠道。阅读已有的 Issues 可以帮助快速规避常见坑,贡献者在提交代码前可以在相关 Issue 下讨论实现方案以获得维护者的建议。定期关注仓库的更新日志和变更记录,可以及时发现与跟进新特性或重要修复。

对于集成与自动化场景,Node API 提供了将 CyberChef 功能置于后端服务内的能力。通过在服务端调用预定义 recipe,可以实现对上传文件的自动分析或对日志流的实时解码。结合容器化部署和消息队列系统,可以把 CyberChef 的处理能力扩展到大规模数据管道中,既保留交互式调试优势,又满足工业化批量处理需求。 在进行大型改动或添加复杂功能时,遵循代码分支策略和保持变更的可回滚性非常重要。建议先在特性分支上完成开发与测试,再通过合并请求进行代码审查。利用 CI 工具来执行自动化测试和构建,可以在合并前捕获错误与风格问题,提升代码质量并降低回归风险。

想要贡献新操作时,建议先阅读项目中的操作模板与测试结构。每个操作应有明确的输入输出说明,并包含边界条件的测试用例。良好的文档注释和示例用法能显著提高新操作被接受的几率。维护者通常关注操作的实用性、效率与代码风格,因此在提交前务必运行 lint 与单元测试。 最后,掌握 CyberChef 的能力不仅限于前端使用者,作为开发者可以将其作为构建工具链的一部分,在数据处理、取证自动化与安全分析中发挥长处。通过理解构建流程、仓库结构与扩展机制,结合社区资源与最佳实践,可以更高效地定制、扩展并在生产环境中部署 CyberChef,从而为日常工作带来可重复、可审计且强大的数据处理能力。

。