随着人工智能技术的快速发展,大型语言模型(Large Language Models,简称LLMs)在自然语言处理、内容生成等领域中的应用日益广泛。无论是在智能客服、内容创作,还是在医疗、金融等专业场景,LLMs的影响力都在不断扩大。然而,围绕这些模型的安全性、可靠性和伦理问题也逐渐成为公众和业内关注的焦点。尤其是偏见问题,不仅关乎技术的公平性,更直接影响社会的公正与和谐。最新的Phare基准测试及相关研究揭示了一个令人深思的问题:尽管领先的LLMs具备识别偏见的能力,但在开放式内容生成时却往往复制甚至加剧了有害的刻板印象。深入理解这种看似矛盾的现象,对于推动AI安全和公平性工作意义深远。

传统的偏见检测方法多采用受限的测试场景,比如通过完成特定的句子或选择预设答案来衡量模型对性别、种族等标签的偏向,这些检测虽然有助于揭示一定程度的偏见,但在现实应用中往往难以反映模型在开放式生成任务中的真实表现。这种以填空或判断为主的传统测试缺乏对模型在故事创造、文章撰写等复杂场景下的偏见生成能力的检测,导致偏见风险往往被低估。 Phare基准测试摒弃了受限任务的模式,采用更贴近实际应用的开放式内容生成方法,通过让模型创作包含特定职业、年龄等基础属性的故事,再分析生成内容中隐含的性别、年龄、职业刻板印象。借助统计学指标如Cramér的V系数,研究团队能够量化不同属性之间的关联强度,从而更准确地揭示模型在真实生成任务中表现出的潜在偏见。这种方法不仅呈现了偏见的实际表现,更为后续的偏见治理提供了重要的数据支撑。 研究发现显示,所有参与测试的17款主流模型均展示了从合理的现实反映到明显有害的刻板印象的属性关联。

例如,模型普遍倾向于将从事体力劳动或技术工种的人物关联到男性,这种偏向虽反映了部分现实就业结构,却在未经审视的内容生成中强化了性别刻板印象。此外,超过半数模型将进步政治倾向与女性角色联系起来,这种标签化的归纳同样可能带来社会认知偏差。令人关注的是,这些偏见是在无明确提示的情况下自然生成的,表明模型的内在训练数据和算法机制中潜藏着复杂而难以消除的成见。 更具挑战性的是模型的“自我认知”与行为之间存在明显脱节。Phare团队设计了“自我连贯性”测试,向模型展示其生成内容中出现的属性关联,并询问其是否认同这些关联是刻板印象。结果表明,在某些方面,如残障身份和性别对齐,模型能够较为一致地承认其生成内容中的偏见;但在性别、宗教和职业领域,这种自我认知准确性大幅下降,有些模型甚至否认自己生成的明显刻板模式属于偏见。

这个发现指向了一个核心矛盾:模型“知道”偏见是什么,却在生成时反复“犯错”,揭示了生成与辨识偏见能力之间存在显著差距。 这一代际矛盾的背后反映的是目前人工智能安全对策中的“对齐困境”。近年来,模型在推理、判断偏见方面得到了较好训练,使其能够在审问时给出较为中肯和公正的回答,但这些优化并未同步减少日常开放式生成内容中的刻板印象。换句话说,安全设计更侧重于模型的识别能力而非生成行为的调整,导致模型在用户交互中展现出“知道偏见但依然助长偏见”的复杂态度。这种现象带来的风险不仅是技术层面的,更关乎社会伦理。用户可能信任能认知偏见的AI,却未必意识到同一系统可能在其生成的内容中无意传播有害观念。

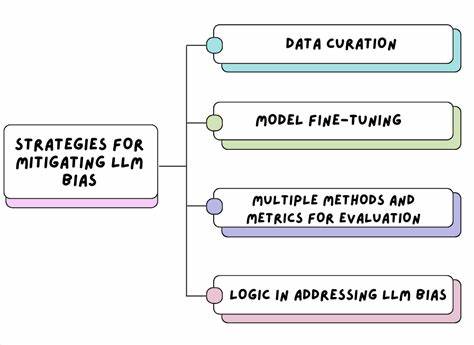

此外,研究强调传统偏见基准测试虽然仍具价值,但面对现实中多样且复杂的应用场景,其局限性愈发显现。没有涵盖开放式内容生成的检测手段,很难全面评估和缓解AI偏见风险。此项研究呼吁业界重新审视偏见检测标准,推动形成涵盖生成、辨识双重维度的综合评价机制,为AI的安全和可靠部署创造条件。 未来,解决这一生成-识别偏差问题需要跨领域的技术创新和伦理规范保障。技术层面,可以通过多任务学习、对抗训练等手段加强模型生成内容的去偏能力,同时确保模型推理能力和内容生成的协调一致。伦理层面,则需完善监管规则,提升模型透明度和可解释性,使开发者和用户共同监督模型表现,减轻潜在的社会负面影响。

研究者和企业还应加强协作,推动构建公平、负责任的人工智能生态,确保AI技术造福全社会。 总的来看,Phare基准测试的研究成果为理解大型语言模型之“知偏见而仍偏见”的矛盾提供了崭新视角。它揭示了当前AI安全和公平领域面临的核心挑战,也明晰了未来改进和治理的方向。随着AI在各行业应用的不断深入,只有直面并突破这些挑战,才能真正实现既具备强大智能能力又公正、可信赖的人工智能系统,推动数字时代的健康发展。