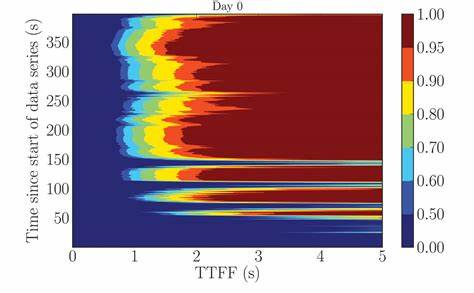

在现代软件开发中,持续集成(CI)已成为提升开发效率和质量的重要手段。持续集成通过自动化测试和构建,能够在代码提交后快速反馈问题,保证代码库的稳定性。其中,首次失败时间(Time to First Failure, TTFF)作为衡量CI流程效率的关键指标,反映了系统发现和反馈错误的速度。较短的TTFF意味着开发人员能更快地获知问题所在,尽早修正错误,从而提升整体开发体验和生产力。 2024年,OP Labs针对持续集成中的TTFF进行了深入的数据分析,重点关注过去三个月内的趋势变化以及近期采取的优化措施带来的影响。通过严谨的数据清洗和统计方法,本次分析有效剔除了异常数据,确保结果的准确性和可靠性。

本文基于这些分析,详细探讨TTFF的变化规律、优化成效及未来的发展方向。 首先,从整体数据来看,TTFF在剔除异常值后呈现出显著的下降趋势。异常值主要指极端的失败时间,比如出现负值或异常长时间延迟的记录,这些都会扭曲统计结果。数据清洗后,月均TTFF明显减少,尤其在九月表现尤为突出。相比之前几个月,九月的TTFF不仅均值降低,且中位数和标准差也显示出整体稳定性的提升,表明优化措施有效降低了失败时间的波动性。 时间序列分析揭示了几个关键节点。

六月底TTFF出现过一个上升的拐点,随后在七月底经历了转折,进入一个相对缓慢回落的阶段。九月初,TTFF开始显著下降,平均首次失败时间跌破一分钟,反映出优化实施后开发反馈速度得到大幅提升。 在细节层面,持续集成记录中存在一些极端异常值,如九月中旬出现负TTFF的记录,属于数据录入错误,被排除在分析之外。同时九月中出现的离群点数量略有增加,提醒团队需关注潜在隐患,避免极端数据影响正常开发流程。整体上,优化效果明显,但仍需针对异常情况做进一步排查和改善。 为了更精确地评估不同时间段的效能变化,分析引入了“早期阶段”、“中期阶段”和“晚期阶段”的视觉分段,分别对应负载较高及状态变化较大的几个时期。

统计分析显示晚期阶段的TTFF平均值及中位数均低于前两个阶段,且组间差异具有显著统计学意义,表明近期流程调整对TTFF的改善作用显著。同时,非参数的Mann-Whitney U检验也验证了这种显著差异,进一步增强了分析的科学性和说服力。 对数据分布的正态性检验显示TTFF数据整体并不符合正态分布,排除传统参数测试的合适性,因此采用了更为稳健的非参数方法进行比较和效应量计算。Cliff’s Delta效应量评估结果表明九月以及晚期阶段的改进属于中等效应量,说明优化效果不仅统计显著,同时在实际操作中具备实质性影响。 回归分析进一步揭示TTFF随时间的动态变化。排除异常值后,TTFF随日期呈现持续下降趋势,每日约减少4.5秒,趋势高度显著。

分段回归发现一个关键断点位于2024年8月中旬,之前TTFF略有上升,之后明显转向下降,契合优化起效时间与效果叠加的逻辑。包含异常值时断点则偏后,在9月中旬,但整体趋势被异常值掩盖。断点分析提醒团队优化应关注异常值控制,以反映更加真实的性能变化。 对于优化措施的实际意义,降低TTFF使开发人员能更快地识别并解决集成过程中的错误,减少等待时间,提升开发效率。尤其是在代码评审和发布周期中,更及时的反馈意味着更高效的迭代和更低的上线风险。此外,TTFF的稳定性提升也反映了流程和工具链的成熟,有助于打造高可靠的软件交付环境。

未来,持续监控TTFF将成为保证CI流程高效运行的必要环节。数据驱动的优化策略需持续推进,通过深入分析异常数据和定位极端情况根因,最大化系统的响应速度和稳定性。同时,也建议结合代码复杂度、测试覆盖率及版本发布频率等多维指标建立综合评估体系,以全面反映持续集成的健康状况和改进空间。 综上所述,2024年OP Labs对持续集成中首次失败时间的分析呈现了系统性的下降趋势和显著的优化效果。通过科学的数据清洗、统计分析和回归建模,不仅确认了优化的实际成效,也厘清了异常值的影响及改进方向。持续关注TTFF指标,不断优化反馈速度,将有效促进开发效率和软件质量的提升,为现代软件交付奠定坚实基础。

随着技术和流程的不断进步,OP Labs正迈向更加智能和高效的持续集成新时代,提升整体软件开发生态的竞争力和创新能力。