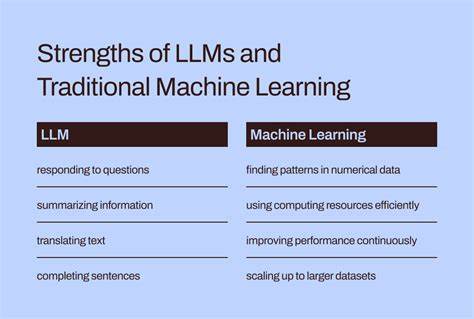

随着人工智能技术的不断演进,基于大型语言模型(以下简称LLM)的应用日益广泛,无论是在内容生成、代码辅助,还是在复杂的交互系统中,它们展现出了令人惊叹的能力。然而,使用过程中许多人会感受到LLM表现的不稳定:某些任务可以高效完成,另一些任务却反复失败。为了深刻理解这些背后的原因,有必要对LLM的适应场景进行科学分类,明确其强势与不足。近期,业界提出通过两个核心维度搭建双轴模型 - - "开放性(Open-Endedness)"与"上下文依赖性(Context-Specificity)",从而梳理LLM表现的规律。所谓开放性,是指任务在答案或解决方案上的多样性与创新需求。一个高度开放性的任务可能包含无数种合理答案,如创意设计、策略规划等,而低开放性任务则是存在唯一或极少数标准答案的情形,如固定语法规则或具体算法实现。

上下文依赖性则衡量任务对于特定领域知识或环境细节的依赖程度。低上下文依赖的任务通常是通用性较强的问题,不需要深刻了解个别项目或领域背景,例如通用算法编写;高上下文依赖的任务则需要对项目架构、业务流程或复杂系统有深刻理解才能正确执行。理解这两个维度后,我们可以将LLM应用任务分为四种典型类型。第一种是低上下文依赖、高开放性领域,称之为"创新发散者"。在这一象限中,LLM表现极佳。它们无需了解具体细节,只基于广泛的训练数据,就可以提供丰富多样的创意和方案建议。

例如,在软件架构设计、性能优化思路等高度开放性的问题上,LLM能够快速产生多元化的思考路径,帮助开发者打开思路,激发创新。此类任务中,LLM的生成能力与语义理解优势被最大化发挥,且较少受限于专业项目约束。第二种是低上下文依赖、低开放性任务,称作"权威百科全书"。这里的任务结构明朗,答案标准明确,多属于已有知识范畴。例如代码段编写、常见算法实现、网络请求规范等,LLM凭借大规模语料库积累的知识可精准给予标准答案。此外,针对一些通用性编码错误的修复建议,如事件触发顺序调整,也能提供有效的解决方案。

尽管这类任务缺乏创新空间,但LLM的准确性和响应速度使其成为问题解决的理想工具。第三类是高上下文依赖、高开放性,昵称为"行走的咨询师"。这类任务通常涉及深度领域知识与复杂背景,同时需要灵活的思考与判断,比如心理咨询、组织行为分析等。虽然LLM对人类交互模式与心理学知识有一定的理解和分析能力,能够从大量训练数据中识别情绪和行为模式,但由于缺乏真正的情感体验与道德判断,其输出仅基于统计推断,难以替代人类专家的真实共情和深入理解。这限制了LLM在高情感投入领域的应用可靠性。第四类则是高上下文依赖、低开放性任务,被称为"陷阱任务"。

此象限里,问题具有准确答案,但需要模型充分理解复杂、细致的领域环境和系统架构,哪怕一点小细节的误解都可能导致整体方案失效。举例来说,特定的前端UI布局调整、跨模块代码重构等,都严重依赖全局码库结构、继承关系及项目隐性约定。当前的LLM缺乏持续的全局认知和动态记忆,不能有效建构完整项目的心智模型,也难以精准处理互相关联的细节信息,表现往往低于人类中高级开发者,导致用户感到挫败。从应用实践看,理解这一双轴模型能帮助我们更理性地规划LLM在实际工作中的角色。利用其在低上下文依赖领域的高效创意和知识输出能力,可以极大提升头脑风暴、初步设计和代码模板生成的效率。同时,对高上下文依赖领域,应当结合人工审核和深度交互,以弥补其认知浅表和细节处理不足。

需要避免将LLM视作万能替代方案,尤其在涉及项目核心架构和业务逻辑精细调整时,应依赖资深工程师的专业判断。此外,模型的训练环节也可针对不同任务需求调优。开发者可将训练重点放在增强领域知识融入和上下文记忆能力,通过多轮对话和外部知识库扩展LLM对特定项目的认知,从而减缓"陷阱任务"中的性能瓶颈。在算法层面,结合代码检索、静态分析辅助等技术,将LLM作为辅助工具使用,则更能发挥长处,避免盲目依赖。总体来看,LLM正处在快速成熟的阶段。理解"开放性"与"上下文依赖性"这两个关键维度,是把握其优势、弥补其不足的有效路径。

应用者应当结合双轴模型,结合具体场景合理规划使用策略,最大化地释放人工智能的潜力。未来,随着模型结构和训练方法不断升级,预计其在高上下文、低开放性任务中的表现必将大幅提升,令人工智能真正成为复杂项目管理与创新协作的得力伙伴。拥抱技术变革的同时,也需要保持谨慎和理性,以确保人机协作走向共赢的美好未来。 。