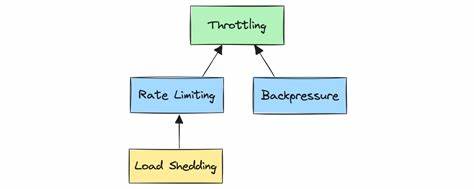

在现代Web开发中,API调用的速率限制是不可忽视的重要环节。无论是支付、物流还是报表系统,外部服务都往往通过速率限制保护其资源和性能。面对不同接口拥有不同请求频率上限的挑战,如何在Rails应用中打造一个灵活、健壮且高效的多重速率限制节流系统,成为保障业务稳定运行的关键。本文将深入解析基于Redis的多端点速率限制实现方法,探讨从底层设计到智能重试以及后台任务节流的全流程方案,助力开发者提升接口调用的可靠性和系统的可维护性。 速率限制的核心需求在于精确统计单位时间窗口内的请求次数,超过限制则需主动阻止或延迟请求,避免外部API响应429错误或触发封禁机制。针对不同的接口路径,要求分别配置不同的请求上限和时间周期,例如支付交易接口可能允许一分钟内最多100次请求,而退款接口则限制为20次,报表接口可能更为严苛,仅支持每小时5次的访问频率。

实现方案的关键在于灵活绑定接口与限制参数,准确、高效地记录请求次数,并在检测超限时做出合理响应。 Redis作为高性能的内存存储,具备原子性自增和过期管理功能,非常适合用作请求计数的基础工具。通过将请求计数拆分为固定时间段的桶式统计,可以轻松实现滑动窗口的近似速率限制。具体做法是对当前时间进行向下取整,生成该时间段内唯一的Redis键,键名内嵌API名称、接口名及时间窗口标识,确保计数隔离且高效可追踪。 每当请求到来,系统通过Redis事务原子性执行键值自增及设置过期时间,保证计数准确无误。通过设计一个ApiRateLimiter服务类封装这些操作,开发者可以轻松调用检查接口状态,自动抛出超限异常。

此模式在多实例部署环境下表现尤为优秀,保证所有Rails应用节点共享计数状态,实现分布式限流。 配置管理方面,最佳实践是将各个API及对应端点的限流参数集中管理,存储在诸如ApiThrottleConfig的常量或配置类中。这样不仅便于统一维护,还能减少硬编码,支持动态调整限额以适应业务需求变化。 在实际调用过程中,引入一个ThrottledApiClient类,业务方通过此客户端发起API请求时,自动完成限流检查逻辑。客户端提取请求路径,映射到限流配置并调用限流器判断。若未超限,客户端透明执行HTTP请求;若检测到速率限制,将立即抛出异常或触发重试逻辑。

该设计实现了调用代码与速率限制逻辑的解耦,提升代码清晰度和扩展性。 面对外部API局部或突发性限流响应(HTTP 429),客户端也能灵活处理。通过捕获429响应,及时记录限流状态并更新内部计数器,避免继续盲目请求导致持续失败。结合应用日志和监控系统,对API限流情况做可视化反馈,帮助运维快速定位瓶颈并优化调用节奏。 高级强化功能包括在限流异常时,配合指数退避(exponential backoff)策略自动重试请求。通过计算延迟时间,既遵循最大等待时间不超过实际重置窗口,又避免频繁尝试带来的资源浪费。

Rails的sleep或异步队列调度相结合,实现平滑恢复请求,提升整体系统的容错能力。 对后台任务调用外部API的场景,建议封装专用作业类,例如ThrottledApiJob,支持在遇限速时自动重排队,延迟执行,保证所有请求最终都能被处理且不会超频。结合ActiveJob和Redis的分布式锁机制,确保分布式环境下一致性和可靠性。 监控和告警是保障长期稳定运行的不可缺少环节。基于限流器的状态查询接口,系统可定时统计各API各端点当前剩余请求数及使用率,生成报告并结合日志发送预警。在达到阈值时及时通知维护人员,提前预防系统过载或突发请求峰值造成服务不可用。

在测试层面,结合MockRedis及时间模拟工具,测试覆盖请求计数、窗口切换、异常抛出和重置行为,保证限流逻辑在各种边界条件下表现正确,减少上线故障风险。 整体来看,构建多重限速节流系统离不开合理的架构设计、稳定的数据存储支持和智能的请求管控策略。Rails生态中的Redis工具、配套的服务组织方式及多层次的异常处理,实现对复杂外部API调用的良好掌控。不仅保护了外部服务的使用规范,也确保了自家应用的高可用和良好用户体验。 对开发者而言,理解并灵活运用上述设计原则,将有助于应对多端点、多速率限制的业务需求,降低API调用风险,提高系统整体的响应效率。未来也可结合断路器模式,以及更复杂的流量分析和预警机制,将API限流体系打造得更智能、更自动化。

总结起来,基于Redis的固定时间窗口计数器搭配多接口配置和智能客户端,形成的Rails多重速率限制系统,已成为满足现代互联网复杂API需求的有效利器。开发团队应注重系统设计和运维配合,实现应用调用与外部服务的和谐共生,推动业务稳定持续发展。