在深度学习社区中,尝试从源码编译 xformers、flash-attention 或其它依赖 CUTLASS 的 CUDA 扩展时,遭遇"fatal error: cuda_fp8.h: No such file or directory"并不罕见。这个错误会直接导致 nvcc 编译失败,阻止 Python 包安装或扩展模块编译通过。要想高效解决它,首先必须理解 cuda_fp8.h 的来源、为什么会缺失,以及编译器、CUDA 工具链和第三方库之间的兼容性如何影响最终结果。 错误含义与背景说明 "fatal error: cuda_fp8.h: No such file or directory"字面意思是编译器在包含路径中找不到名为 cuda_fp8.h 的头文件。这个头文件与 FP8(8 位浮点)格式的支持相关,部分 CUTLASS / NVIDIA 新特性或第三方优化库会引用该头以启用 FP8 运算、数据类型和转换工具。FP8 支持是近年针对大型模型推理/训练性能优化推出的特性,只有当 CUDA 工具包或相关 SDK 提供该头文件时,代码才能正常编译。

常见原因分析 第一类原因是本地安装的 CUDA Toolkit 版本过旧或安装不完整。不是所有的 CUDA 版本都包含 cuda_fp8.h,或包含路径位置与构建系统期望的位置不同。第二类原因与构建环境有关。很多人在 conda 虚拟环境中仅安装了 cudatoolkit(运行时库),但没有安装 NVIDIA 官方完整开发工具包(包括头文件和 nvcc 可用的 include 目录),因此构建扩展时找不到头文件。第三类原因是第三方库版本不匹配或源码对 CUDA 最低版本的要求不同。flash-attention、CUTLASS 等项目在不同提交中可能开始依赖 cuda_fp8.h,若本地 CUDA 版本低于第三方代码要求就会报错。

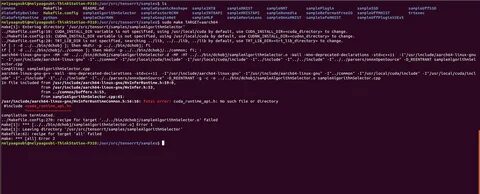

第四类常见问题是编译器与 CUDA 的兼容性冲突。nvcc 对主机编译器(gcc/clang)有严格检查,错误的 gcc 版本可能导致另一类报错或迫使用户尝试降级 gcc,引发更多路径和头文件查找问题。 定位问题的步骤与诊断命令 建议先从最基础的环境信息入手。执行 nvcc --version 确认 CUDA 编译器版本。使用 which nvcc 与 echo $CUDA_HOME 或 echo $CUDA_PATH 检查 nvcc 指向和 CUDA 安装路径是否一致。查找头文件是否存在可以执行 find /usr/local/cuda* -name cuda_fp8.h 2>/dev/null 或 sudo find / -name cuda_fp8.h 2>/dev/null。

如果找不到,说明当前安装的 CUDA 工具链没有该头文件。还要确认是否仅用了 conda 的 cudatoolkit:conda list cudatoolkit 会显示安装信息,若仅靠 conda 运行时库,构建扩展往往会缺少开发头。 解决思路详解 优先级最高的修复方式是安装或升级到一个包含 cuda_fp8.h 的 CUDA Toolkit 开发包。多数情况下,从 NVIDIA 官网下载安装相应版本的 CUDA Toolkit(确保版本满足第三方库的最低要求)并正确设置 PATH 与 LD_LIBRARY_PATH,可以立即解决头文件缺失的问题。务必安装带有开发头文件和 nvcc 的完整版 CUDA,而不仅仅是运行时。若项目明确要求最低版本,例如某些 flash-attention 版本要求 CUDA >= 11.8 或更高,请以项目 README 或 issues 为准选择合适的 CUDA 版本。

如果你已经安装了合适版本,但编译系统仍然找不到头文件,可能是 include 路径没有正确传递给 nvcc。可以在构建命令中添加 -I/path/to/cuda/include 或将 CUDA 的 include 路径加入环境变量 CPATH 或 CPLUS_INCLUDE_PATH。对于 Python 的 setuptools 或 pip 构建扩展,常见做法是在环境变量中临时导出 CFLAGS 或 CUDA_HOME,例如 export CUDA_HOME=/usr/local/cuda-11.8 并确保该目录下有 include/cuda_fp8.h。 另一个经常遇到的坑是使用 conda 的 cudatoolkit 来运行但又从源码构建扩展。conda 的 cudatoolkit 通常不包含完整开发头和 nvcc,导致编译扩展失败。解决办法是安装系统级别的 CUDA Toolkit(NVIDIA 官方安装包)并在构建时指向该安装路径。

需要注意的是,运行时的 CUDA 驱动只要与显卡驱动兼容,Python 运行时使用的 cudatoolkit 可以和系统级 CUDA 共存,但编译时必须保证 nvcc 和头文件来源于完整的开发包。 当遇到编译期间输出的"unsupported GNU version! gcc versions later than X are not supported"的错误时,说明 nvcc 的 host_config.h 检测到主机编译器版本超出其官方支持范围。很多人在看到此错误后选择降级 gcc(例如降到 gcc-6),但降级可能造成其他工具链不兼容或系统维护困难。更稳妥的方式是为 nvcc 指定兼容的主机编译器,而保留系统默认的 gcc。可以使用 nvcc 的 -ccbin 选项指向一个支持版本的 gcc 二进制,或者在构建环境中通过 update-alternatives 添加一个备用的 gcc 安装并在构建时临时切换。以示例为例,若系统默认为 gcc-13,而 CUDA 要求 gcc-11,可安装 gcc-11 并在执行 nvcc 时使用 -ccbin /usr/bin/gcc-11。

对于 pip 安装触发的自动构建,可以在 CXX 环境变量或 setup.cfg 中传递对应的选项,或在构建命令前设置 export CC=/usr/bin/gcc-11 CXX=/usr/bin/g++-11。 如果由于项目代码本身期望 cuda_fp8.h 存在,但你的硬件或 CUDA 版本确实不支持 FP8,可以考虑以下替代方案。第一种是切换到一个不依赖 FP8 的库或特定分支,例如使用不启用 FP8 的 flash-attention 旧版本;第二种是对第三方代码进行临时补丁,在包含 cuda_fp8.h 的地方使用宏判断 CUDA 版本以回退到其他类型实现。不过这种补丁需要谨慎,可能会改变性能或行为。第三种更快速但有风险的办法是在本地创建一个"占位"头文件 cuda_fp8.h,提供最小的类型和宏定义以让代码通过编译,但这通常只适用于那些实际上并不使用 FP8 的代码路径,且可能导致运行时错误或精度问题,因此不推荐长期使用。 针对 xformers / flash-attention 的特定建议 很多 xformers 安装失败的情况来自其依赖的 third_party/flash-attention 或 CUTLASS 子模块在某次更新后开始引用 cuda_fp8.h。

查看要安装的 xformers commit 或主分支的 README 可以找到对最小 CUDA 版本的说明。若 README 指明需要 CUDA >= 11.8,那么务必安装至少该版本的 CUDA Toolkit。对于希望避免本地编译的人,优先考虑寻找与你当前 PyTorch 与 CUDA 版本匹配的预编译 wheel 或 pip 包。Facebook Research 或社区用户有时会发布不同 CUDA 版本对应的预构建包,直接安装可以省去编译痛苦。如果必须从源码构建,推荐先单独尝试编译 flash-attention 子模块,确认其依赖项和编译选项无误,再编译 xformers 的其余部分。 实用命令片段与检查项 在操作系统中查找头文件位置的命令可以帮助确认是否存在 cuda_fp8.h。

例如 find /usr/local/cuda* -name cuda_fp8.h 2>/dev/null 或 find / -name cuda_fp8.h 2>/dev/null。确认 nvcc 与 CUDA 包路径一致可用 nvcc --version 和 echo $CUDA_HOME。若使用 conda,仅安装了 cudatoolkit,请改为安装系统级 CUDA 或下载 NVIDIA 的 deb/run 包进行完整安装。为 nvcc 指定主机编译器可以通过 -ccbin 指向适当的 gcc。构建 Python 扩展时,确保环境变量 CUDA_HOME、CPATH、LD_LIBRARY_PATH 已正确指向你的 CUDA 开发包路径,这样 setuptools 才能找到头文件和库。对那些不想更改系统 gcc 的用户,安装并使用多版本 gcc,然后在构建时通过 -ccbin 或设置 CC/CXX 指向备用版本是较安全的做法。

调试与求助时应提供的信息 如果以上方法仍无法解决问题,向社区或项目维护者求助时,请提供尽可能完整的环境信息,包括 nvcc --version 的输出、which nvcc 的路径、conda list cudatoolkit 或 dpkg -l | grep cuda 的输出、gcc --version、以及构建时的完整错误日志(尤其是包含文件搜索和 nvcc 调用的那部分)。同时说明你是使用系统级 CUDA 还是 conda cudatoolkit,以及是否在虚拟环境中尝试构建。项目维护者通常能更快定位问题并给出针对性建议。 常见误区与避免方法 不要仅仅依靠 conda 的 cudatoolkit 来做源码编译。conda 的运行时包方便但并不总是包含头文件和 nvcc 所需资源。不要盲目降级系统 gcc 到极老版本作为首选方案,因为这可能带来维护和安全问题。

优先考虑安装并使用与 CUDA 版本兼容的 gcc 版本作为 nvcc 的 -ccbin。不要随意将占位头文件或未经验证的补丁用于生产环境,它们可能掩盖真实的兼容性或功能问题。 总结与最佳实践 遇到"fatal error: cuda_fp8.h: No such file or directory"时,思路应当清晰:先确认 CUDA 工具包版本和安装完整性,再检查头文件是否存在与 include 路径是否正确,然后处理 gcc 与 nvcc 的兼容性问题。若可能,优先使用官方 CUDA 开发工具包而不是仅依赖 conda 的运行时库。对于 xformers 与 flash-attention 这类对硬件与 CUDA 版本敏感的项目,匹配好 CUDA 版本、PyTorch 二进制与显卡驱动是成功构建的关键。通过逐步检查环境、调整 include 路径、并在必要时指定兼容的编译器路径,大部分因 cuda_fp8.h 丢失导致的编译失败都可以被修复。

如果在按照上述建议操作后仍有问题,欢迎把环境信息和错误日志粘贴到相应项目的 issue 中,或在社区论坛中寻求帮助。提供详尽的版本信息和构建日志会大大加快问题定位与解决速度。祝你顺利通过编译,成功运行高性能的 CUDA 扩展。 。