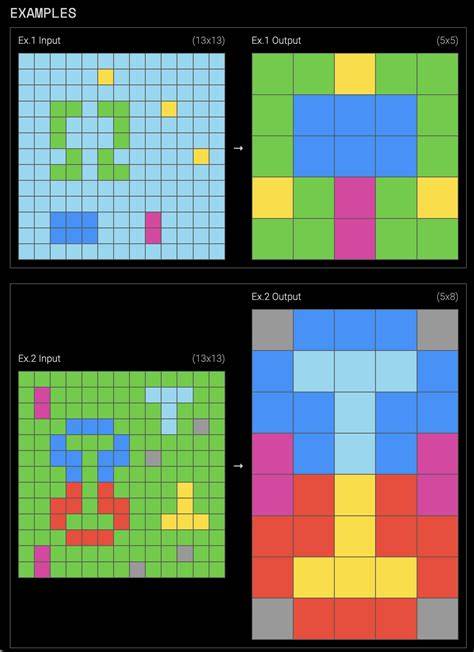

在人工智能(AI)研究领域,ARC-AGI测试始终被视为衡量机器是否具备真正抽象推理与泛化能力的关键benchmark。它以类似IQ测试的形式,通过呈现输入与输出网格的抽象模式,考察模型在未见过的数据上识别和推理模式的能力。尽管大型语言模型(LLM)在数学、编程甚至科学竞赛中表现卓越,但它们在面对ARC-AGI这一类需要跨越训练分布进行推理的任务时,依然表现出惊人的不足。这是促使研究者不断寻求突破的原因。近日,人工智能研究者Jeremy Berman带来了一个令人瞩目的突破,他的团队在ARC-AGI挑战中不再依赖Python代码,而是巧妙地转向使用英语自然语言指令,取得了迄今为止最高的测试分数,且显著提高了计算效率。这一创新方法不仅刷新了ARC-AGI的现有最高成绩,也为解决AI推理中的"死区"问题提供了宝贵思路。

ARC-AGI的本质考察机器的抽象模式识别能力。不同于普通的分类任务或文本生成,ARC-AGI要求模型像人类一样理解输入输出之间深层的逻辑关系和规律,并应用于新的未见任务。虽然人类凭借类比、演绎推理可以轻松解决此类任务,但大多数LLM在这方面依然遭遇瓶颈,因为它们主要是通过大量文本语料训练,侧重于语言模式统计,而非真正的逻辑推理。Jeremy Berman的最新成果基于一种被称为"进化测试时计算"(Evolutionary Test-Time Compute)的架构,这是一个多智能体合作的动态系统。该系统核心思想是用语言模型生成一系列自然语言形式的指令,描述如何转化输入网格为对应的输出结果。这些指令相当于"解题方案",随后由多个子智能体在训练示例上进行验证和评分,根据其准确率决定该指令的优劣。

优秀的指令会被用作"种子",进行下一代进化,融合打分较高指令的优势,以此不断迭代。这种进化机制模仿了生物进化中"遴选"和"突变"的过程,极大增强了模型在解决复杂、多步骤逻辑任务时的适应性和多样性。十个月前,Jeremy曾使用同样的进化架构,但生成的是Python函数。此方法的优势是代码结构明确且可验证,方便评分和优化。然而,随着ARC-AGI版本的升级,任务的难度加大,逻辑转换变得愈发复杂且难以用简洁代码表达,导致Python反而成了瓶颈,制约了探索空间。于是他大胆地选择"英语"作为指令的表达语言。

为何英语指令能胜过Python代码?这主要因为自然语言表达更具灵活性和模糊性,能包含更多上下文和多层次的逻辑指示,而不是固定的语法结构限制。这使得模型得以创造出多样化的解法思路,实现细粒度的调整。为确保生成指令的效果,Jeremy设计了分阶段的修正策略。首先是个体修正阶段,模型根据单条指令在训练例中应用的结果与标准答案之间的差异,结合ASCII差异展示反馈,针对性地改进该条指令。第二阶段是集中修正,将多条表现良好的指令合并成一个上下文,模型尝试综合这些碎片信息,创新生成新的指令。这种方法既兼顾了局部深度优化,也兼顾了多样化思路的融合。

值得注意的是,相比普遍预期,多条指令的集中修正并没有每次都明显优于个体修正,原因在于语言模型在处理大量上下文时会遇到token限制,且过多信息容易导致"走神",影响推理质量。通过这些机制,Jeremy的方案实现了对每个任务尝试高达40个候选指令,既保证探索的广度,也兼顾精度提升。这种巧妙的计算分配大幅提升了整体效率与精准度。最终,这一自然语言进化测试时计算架构在ARC-AGI v1上达到了79.6%的得分,远超先前最高的75.7%,且每任务花费仅8.42美元,效率提升近25倍。此外,最新版本2(ARC-AGI v2)也突破了29.4%的新高,领先之前的25%。这一成绩的取得,向世人展示了自然语言本身蕴含的强大表达能力,同时证明了进化算法和多智能体协作在复杂推理任务中的巨大潜力。

Jeremy在总结中提出,当前大型语言模型的核心障碍在于"死推理区"(Dead Reasoning Zones)的存在。这些区域相当于模型权重中的逻辑失效点,当遇到未训练过的复杂推理问题时,模型会产生不合逻辑甚至谬误的结论。而人类的推理能力则十分连贯且可泛化,不论熟悉哪个领域,都能保持严密的逻辑一致性。现有神经网络被认为是受限于所训练的数据分布,无法超越这个范围进行根本推理能力的提升。Jeremy认为这是片面的,关键在于现有模型的推理电路与不同领域的知识电路相耦合,导致推理能力被碎片化,缺失统一的"逻辑核心"。因此,实现真正的通用人工智能(AGI)需要让模型掌握纯粹的、跨领域的推理技能,将逻辑演绎与一致性训练纳入模型基础能力中。

值得一提的是,强化学习(RL)的加入为这一挑战提供了新的方向。相较于仅依据语言模式预测下一词的传统训练思路,RL通过奖励机制,促使模型产出更符合逻辑和事实的输出,让模型在推理链条上更具一致性和准确率。Jeremy的研究从技术细节到理论高度,均指出了未来AGI发展的核心路径:将推理内化为模型训练分布的一部分,而非域外附加技能。基于自然语言的进化测试时计算架构,不仅提升了ARC-AGI挑战的水平,更为AI如何实现跨域、跨任务的高效推理揭示了新思路。目前该项目源码已公开,学界与工业界均可借鉴与拓展。结合多智能体系统的协作优势,未来有望将此思路推广至更多复杂认知任务,促进AI智能化的质的飞跃。

总的来说,Jeremy Berman的最新突破不仅是ARC-AGI排行榜上的胜利,也象征着迈向通用人工智能的里程碑。用最贴近日常人类沟通方式的自然语言替代刻板的编程代码,为AI赋能了更灵活、可演化的思考模式。随着模型推理能力和进化机制的深化,我们有理由期待不久的未来,人工智能能够像人类一样灵活且可靠地理解、推理与创造,真正跨越训练数据的限制,成为智力的全能助手。 。