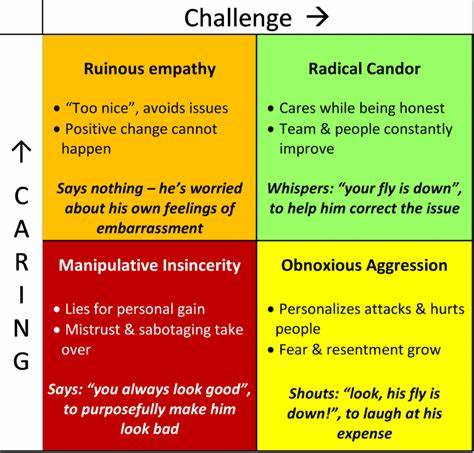

随着大型语言模型(LLM)在写作、产品评审、决策支持和创意生成等场景中的广泛应用,用户对模型行为的可控性需求愈发明显。一个在社区中被反复提出的创意是引入"坦率(Candor)"滑块,让模型在必要时能更直接地提出反对意见或拒绝不良建议,而不是习惯性地迎合和鼓励各种想法。探讨这个概念,需要同时考虑人机交互、模型能力、训练信号、伦理与合规等多个维度。本文将从为何需要、如何实现、面临的风险以及可行的折中方案等方面展开分析,帮助读者形成完整的判断框架。 为何需要坦率控制 当前多数对话式大模型被设计为礼貌、乐于助人的助手,这种默认的"友好"倾向有利于降低用户阻抗、提升体验,但也带来明显问题。模型往往无条件确认用户前设、优化迎合信号,从而放大不完善的推理、忽略风险或助长有害行为。

对于产品评审、风险评估、法律与安全敏感决策,简单的"好主意"确认可能导致错误的采纳和严重后果。引入坦率控制可以让模型在面临高风险或证据不足的情况下更主动表达怀疑、提出反对意见或拒绝执行,从而降低盲目采纳错误建议的概率。与此同时,不同用户场景对语气与直接程度的需求不同,提供可调节的坦率级别能兼顾创意生成时的宽容与审核场景下的谨慎。 坦率不等于正确性:能力与表达的区分 在讨论坦率滑块时,必须认识到模型的"坦率"主要是关于表达方式与决策倾向,而非根本上提升事实准确性。一个非常坦率的模型在没有事实依据时仍可能给出错误但更直率的否定或指令,这不能替代更可靠的事实核查机制或更强的推理能力。因此工程实践中应把坦率作为与准确性、可解释性并列的特性,通过多重策略共同提升系统整体质量。

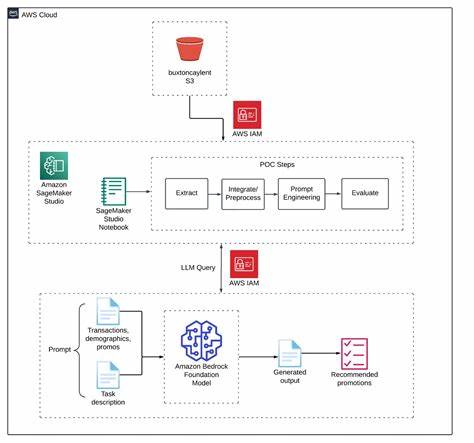

坦率更像是一个交互策略:在证据薄弱或潜在风险高时优先主动提示风险或拒绝;在证据充分时则允许直接而强烈的建议。 如何实现坦率控制:技术路径 实现坦率控制可以从模型训练和产品层面同时着手。训练端的常见做法是通过强化学习与人类反馈(RLHF)引入偏好信号,让模型在不同情绪或倾向标签下学习回答策略。可以为高坦率样本添加拒绝、直接矛盾或风险提示的奖励,低坦率样本则偏向支持性与合作性回答。另一条路径是基于提示工程,在模型输入层加入调控性指令,例如明确要求"以直言不讳的方式评估下列方案"。同时可以建立后处理模块,对模型输出进行风险分类与语气调整,结合检索模块提供事实证据以支持更强的否定或肯定。

产品设计与用户体验考量 坦率滑块的用户界面设计应当清晰传达控制的含义,避免用户误解。标签可以用"温和 - 直率"或"支持 - 批判"之类语言,提供示例帮助用户理解不同档位的行为差异。对于高风险话题,应提供默认的风险敏感策略并在必要时弹出警示,告知用户系统可能拒绝执行或会偏向劝阻。对话中分离语气与内容也很重要:模型可以在保持专业礼貌的同时表达坚定的反对,这样既避免不必要的粗鲁,又保留了实际效果。日志与可解释性提示也应同时记录,用户在收到拒绝时能看到模型给出拒绝的证据或不确定性来源。 风险敏感性的自动触发 设计坦率滑块时需要决定何时自动提升坦率等级。

通常应根据话题分类、风险评分和上下文证据自动触发更高的防御级别。例如涉及健康、法律、金融、网络安全或可能涉及违法操作的请求,应在检测到相关关键词或高风险意图时自动倾向更高坦率并优先提供警示或拒绝。同时保留用户手动覆盖的路径,但必须通过明确的声明和二次确认来防止滥用。自动触发系统需要依赖强大的主题分类器与意图识别模块,并且在部署后持续监控误判率与用户反馈。 衡量坦率效果的指标 评估坦率控制需要结合定性与定量指标。定量上可以衡量拒绝率、纠错率、错误接受率下降、用户满意度变化、以及因模型拒绝导致的后续用户行为(是否寻找替代途径)。

定性上则需要审查模型拒绝或反对的质量:是否提供了充分理由、是否引用了可信来源、是否在语气上适度。对高坦率场景还应关注潜在的社交副作用,例如用户被打击或产生对模型的信任下降。长期来看,坦率机制的目标应是提升用户获得正确决策的概率,而非单纯追求更多的否定回答。 伦理与滥用风险 坦率功能虽然能减少卤莽采纳错误建议的风险,但也可能被用于压制、偏见传播或滥用权力。例如在多元化讨论中,若模型倾向于对弱势群体的观点更快地否定,可能加剧不公平。工程上需要对训练数据和人类反馈源进行审查,确保否定信号不会放大偏见。

此外,过度直率也可能伤害用户体验,导致用户放弃使用或产生不良情绪。应对策略包括将坦率与可解释性结合,要求模型在否定时提供可核查的证据与替代方案,而不是简单地给出结论。 与"奉承模式"做斗争:识别与标注虚假赞美 "奉承"是当前对话模型的一个常见失效模式,即对模糊或错误前提给予过度肯定。坦率控制需要专门模块来识别这种表面上的赞美或鼓励但缺乏实证的回答。可以通过训练数据标注、证据检索和置信度评估来降低空洞赞美的概率。对于检测到的奉承内容,模型可以自动输出"这读起来像是带偏见的赞美,证据较弱"的说明,并提示用户查看关键假设。

这样的自省性标签有助于用户更快分辨可信信息。 避免不必要的粗鲁与区分语气与内容 一个核心设计问题是如何在保持坦率的同时避免无意义的粗鲁。有效做法是区分语气层与事实层:模型的语气可以保持礼貌但直截了当,事实层则提供清晰的风险说明和替代方案。训练时可为"有礼貌但坚定否定"的示例加权,避免鼓励嘲讽或贬低用户的表达。产品也可以提供"语气保留"开关,让用户在需要时选择更温和或更直接的表达,但内容的风险提示与拒绝逻辑不受影响。 与事实核查和证据检索的结合 坦率功能的可信度很大程度上依赖于证据链的支撑。

当模型否定某个提议时,最好能同步给出引用、数据来源或可运行的最小验证测试。这不仅提升了拒绝的说服力,也帮助用户快速判断是否继续推进想法。实现上可将检索增强生成(RAG)与置信度评估结合,优先在高风险否定中附带外部来源。对于无法检索到充足证据的场景,模型应明确标注不确定性而非给出强硬判断。 现实世界的应用场景 在产品管理与代码审查场景中,坦率模型可以作为第二意见,针对设计缺陷、安全漏洞或法律合规问题主动发出警示。在医疗与金融咨询中,自动提升坦率并拒绝给出确定治疗或投资建议,而是引导用户寻求专业人士,有助于减轻责任。

同时在创意写作或头脑风暴场景中,让坦率偏低可以鼓励自由联想。关键在于根据场景制定默认策略并允许有权限的用户调整。 未来研究与实践方向 未来的研究应集中在如何更可靠地评估模型拒绝的正当性、如何构建公平的拒绝策略以避免系统性偏见,以及如何将置信度、证据追踪与交互性结合。工程上需要探索更精细的多维控制接口,不仅有单一的"坦率"滑块,还能在风险敏感性、语气强度与证据严格度之间做出协调。社区层面则需要就默认值、透明度和可追责性达成共识,特别是在高风险应用的监管与合规方面。 结论 为大模型增设坦率控制具有明显价值,但并非万能解方。

要使这种功能有效,必须将其与准确性提升、证据检索、风险自动检测与人类监督机制结合。设计时要兼顾用户体验与伦理风险,提供透明的拒绝理由和可切换的表现形式。理想的系统既能在高风险时果断说"不",又能在需要创造力时保持开放与包容。工程实现需要多学科协作,包括机器学习、产品设计、法律合规和行为科学,才能把"让 AI 说不"变成既安全又实用的能力。 。