近年来,随着大规模语言模型的爆炸性发展,推理效率和结果稳定性成为关键研究方向。Llama.cpp作为一个开源的轻量级LLM推理框架,近期引入了名为"确定性推理模式(Deterministic Inference Mode)"的关键特性,特别是在CUDA加速环境下对RMSNorm、MatMul和Attention模块进行了深度优化。本文将详细剖析该模式的技术细节,探索其实现机制、应用意义以及对未来推理性能的可能影响。 推理过程的确定性问题一直是大型语言模型实践中的挑战。非确定性的推理结果可能导致模型输出的不可复现,这不仅不利于模型调试和性能评估,也给某些对结果严苛要求的应用场景带来巨大的不便。Llama.cpp的确定性推理模式正是在此背景下应运而生,旨在确保在相同输入条件下,多个推理运行能够获得完全一致的输出结果,即实现"位级相同"的结果一致性。

该模式的设计灵感来源于Thinking Machines团队关于批处理不变性和归约顺序的深度分析。核心思想是通过限制和统一计算过程中的各种不确定因素,从而消除由于并行计算、浮点数运算顺序不同等引起的数值误差积累。具体而言,针对模型中的关键运算模块 - - RMSNorm、MatMul和Attention,Llama.cpp引入了多项精细化策略。 RMSNorm作为归一化方法,在模型推理中对稳定性和收敛速度起着决定性作用。原有实现中,由于并行计算中归约操作的顺序未固定,不同批次执行可能产生轻微数值漂移。确定性模式通过采用逐行固定顺序的归约操作,确保每一次归约的计算路径完全一致,不依赖于批次大小或执行顺序,从而实现归一化结果的稳定一致。

这一改进虽然增加了部分计算负担,但为输出一致性奠定了坚实基础。 矩阵乘法(MatMul)是深度学习推理中的核心操作,尤其是在大规模模型中的多头自注意力机制和全连接层中至关重要。传统GPU实现会通过分块(tiling)、分割K维度(split-K)和半精度浮点数累积等策略提升效率,但这些技术往往带来不可控的数值变化。Llama.cpp的确定性模式摒弃了分割K维度策略,采用固定的分块策略,且将半精度浮点数累积提升至单精度(FP32),从而严格控制每一步计算的顺序和数值精度。这种设计显著减少了因并行策略导致的数值差异,保证了在同一个输入下矩阵乘法的结果完全一致。 注意力机制的计算复杂且敏感,尤其是包含键(Key)值(Value)缓存(KV-cache)时,任何微小的数值差异都可能导致累积误差,从而影响模型表现。

为了解决这一问题,确定性模式在Attention模块中实施了多重优化。首先,采用固定的KV分割大小,避免因分割大小变化带来的计算路径差异。其次,设计了稳定的softmax归约方法,确保在数值上实现严格一致的概率分布。此外,针对KV缓存的内存结构进行了对齐和填充,使得无论是一次性预填充还是分块推理,缓存访问路径保持一致。这极大地提高了模型在不同推理策略下结果的可重复性。 除了上述主要模块外,确定性推理模式还扩展支持了MoE(专家模型)中特定矩阵乘法路径的确定性处理,并确保其适配FP16和BF16浮点格式,统一计算路径和数据类型转换规范,进一步拓宽了该模式的适用范围。

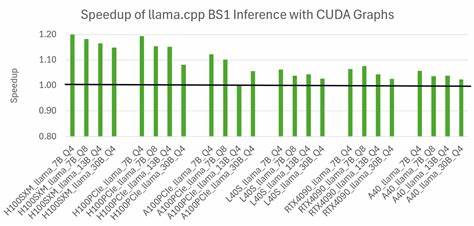

该模式的启用需要在编译阶段加上-DGGML_DETERMINISTIC=ON编译标志,运行时通过参数--deterministic或环境变量GGML_DETERMINISTIC=1激活。在模型生成过程中要实现完全重现,还建议配合将温度参数设为0,top_k和top_p均设为1,这些设置确保生成过程的随机性最小化,从而达到严格的结果重现标准。 值得注意的是,该确定性模式目前针对CUDA环境中的FP16和BF16精度计算进行了重点优化,CPU端原本即实现了确定性,因此并未对此额外更改。其他GPU后端也未受影响,保持原有性能和行为不变。由于引入了固定计算路径和更严格的数值管理,确定性模式会在吞吐量上有一定折衷,尤其在高并发推理场景中需要平衡稳定性与性能的要求。 功能上线后,团队实现了一套完善的测试体系,覆盖了从单次推理的位级相等性验证,到批量大小和分块推理不变性的测试,以及attention机制和掩码处理的准确性检验,涵盖了注意力层的ALiBi偏置机制和MoE多专家路径,确保每一环节的结果符合预期。

测试已在多款NVIDIA GPU上通过,显示该方案的广泛兼容性和可靠性。 社区对该功能的反馈呈现出分歧。一方面,确定性推理为科研复现、法规合规和调试追踪提供了强有力的技术支持,极大增强了模型推理的可信度。另一方面,也有意见认为批处理大小变化的确定性管理应通过更高层的调度和缓存策略来完成,而非底层硬件运算接口层面。相关讨论中也提到用户能够通过禁用提示缓存和单线程执行实现类似的位级确定性,进一步表明该功能是为特定严格场景量身打造。 综合来看,Llama.cpp的确定性推理模式以创新的CUDA计算路径管理和数值稳定技术,为大规模语言模型推理过程带来了显著的稳定性突破。

它不仅满足了模型研发和生产环境中的严苛一致性需求,也为未来探索更加高效且可靠的推理优化奠定了基础。展望未来,随着硬件计算能力的提升和算法设计的不断演进,如何在保证确定性的前提下进一步提升性能,将成为该领域持续关注的重要方向。 对于关注深度学习推理工程师和技术研发者而言,深入理解并掌握Llama.cpp确定性推理模式的原理和实践,将有助于优化相关推理环节,提升模型输出的可控性与稳定性,推动自然语言处理技术的高质量发展。随着更多开源项目和企业采用类似技术,确定性的实现方式和标准化流程有望成为行业通行规范,为AI技术的实际应用提供坚实保障。 。