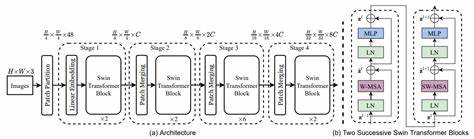

在人工智能快速发展的时代,扩散模型(Diffusion Models)凭借其在图像生成等任务中的卓越表现,吸引了越来越多的关注。作为扩散模型中的新兴代表,Diffusion Transformer(DiT)融合了扩散过程和变换器架构的优势,展现出强劲的性能和优秀的可扩展性。Small-Dit项目作为一个基于PyTorch的Diffusion Transformer简约实现,提供了一个极具教育意义且易于理解的架构范例,帮助研究人员和开发者更好地掌握DiT的核心思想。Small-Dit开源项目由用户alenMangattu发布在GitHub上,项目专注于提供从头实现的Vision Transformer架构,结合扩散训练机制,展示了DiT在图像生成任务中的实践价值。项目代码结构清晰,包含模型定义、数据处理、训练脚本及测试示例,便于用户快速上手和二次开发。Diffusion Transformer本质上是将Transformer引入扩散模型的去噪过程,将传统的卷积操作替换为自注意力机制,利用Transformer强大的表征能力捕获图像的全局特征。

Small-Dit通过极简代码实现,对Transformer和扩散过程的关键模块进行了精炼表达,便于初学者理解其背后的数学原理和代码逻辑。模型的核心设计包括多层Transformer编码器、扩散噪声调度机制及去噪网络结构。TODO队列清晰地划分了生成图像的不同步骤,确保扩散过程中的稳定训练和高效生成。Small-Dit还包含对应的数据集预处理脚本,方便用户对流行图像数据集如CIFAR-10、ImageNet子集进行训练实验,验证模型性能。项目中采用PyTorch框架实现,充分利用其动态图机制提升模型的灵活性。Small-Dit虽为简约版本,但其架构设计与参数配置均紧密参考了原始DiT论文,保证了理论上的一致性。

学术价值之外,Small-Dit项目也极具实用意义。它为深度学习研究者提供了一个低门槛的入门范例,加速理解扩散模型与Transformer结合的可能性,同时也为工业界探索高效图像生成解决方案提供了思路。当前,图像生成技术在艺术创作、影视制作、虚拟现实及医学影像等多个领域都催生出巨大的应用需求。Diffusion Transformer凭借对图像细节的优异表达能力,能够生成更高质量、更具多样性的图像,是未来生成模型发展的重要方向。Small-Dit的简洁实现不仅便于教学和研究,也使得整个架构更易于扩展和改进。开发者可以基于Small-Dit加入更复杂的注意力机制、优化扩散调度策略,或者结合其他最新技术提升模型效果。

社区活跃度虽然有限,但Small-Dit的代码开源与说明详尽,有助于促进更多关于扩散Transformer的交流与创新。鉴于模型架构的复杂性和训练资源需求,Small-Dit项目的存在弥补了缺乏易用且精简实现的空白,是开展相关研究工作的良好基石。随着计算能力的提升和算法优化,未来将有更多Diffusion Transformer衍生模型出现,可能涵盖更广泛的视觉任务,诸如超分辨率、图像修复及风格迁移等。研究者可以借助Small-Dit快速搭建实验环境,进行算法探索和性能验证。此外,Small-Dit还启示了对Transformer在非自回归生成任务中的潜力研究。由对小规模模型的理解逐步过渡到大规模训练,预计该技术将在人工智能图像生成领域保持强劲的生命力。

总结来看,Small-Dit项目不仅是Diffusion Transformer理论与实践的桥梁,也是推动视觉生成模型发展的重要工具。通过轻量级且结构清晰的代码实现,Small-Dit降低了技术门槛,激发了更多开发者对创新图像生成技术的兴趣。对于深入探究扩散模型与Transformer结合的研究人员及应用开发者而言,小型项目提供了宝贵的启发与参考,助力推动下一代生成模型的广泛应用。