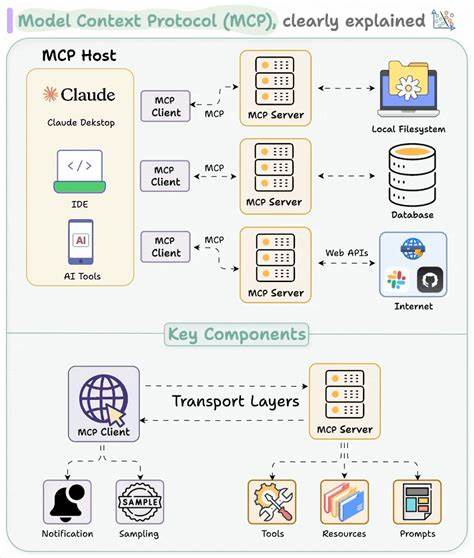

随着人工智能技术的快速发展,AI应用与外部数据源和工具的连接需求日益增长。模型上下文协议(Model Context Protocol,简称MCP)作为一个开放标准,提供了统一且安全的接口,使得AI模型能够高效访问数据库、API和各种服务。在这一生态系统中,MCP-Gateway作为中央认证和配置管理的核心组件,承担着至关重要的角色。它不仅简化了多服务器管理流程,还确保了系统的安全性和稳定性,促进了MCP在生产环境中的广泛应用。 首先,需要了解MCP协议的基本概念。MCP旨在打造一个标准化协议,为AI应用与外部工具之间的交互提供规范和安全保障。

通过这一协议,语言模型能够以受控的方式调用不同服务的功能,从而实现复杂任务的自动化处理。不过,随着参与服务器数量的增加,如何管理多个MCP服务器的生命周期、保证认证安全以及统一配置,就成了工程实践中的挑战。 MCP-Gateway是Docker官方推出的解决方案,集成于Docker Desktop的MCP工具包中。它以Docker容器为基础,使用容器隔离的优势管理每个MCP服务器,确保了运行环境的独立性和安全性。通过集中管理,MCP-Gateway为AI模型提供一个统一访问入口,把多服务器复杂的协议转换、请求路由和身份认证工作透明化,降低了客户端实现的复杂度,同时提升了整体系统的可维护性。 功能上,MCP-Gateway拥有丰富的特性。

它允许用户轻松列出、启用或禁用多个MCP服务器,实时监控服务器状态及调用日志。凭借Docker Desktop的秘密管理机制,敏感的API密钥和凭证不会暴露在环境变量中,有效防止泄露风险。此外,MCP-Gateway内置OAuth认证流程,支持与多个身份认证服务集成,保证了用户访问的合法性和安全性。动态工具发现功能则使得正在运行的服务器能够自动向网关注册自身提供的工具和资源,极大地提升了系统的灵活性和扩展能力。 在实际应用中,开发者可通过安装docker-mcp插件,在命令行环境中直接管理MCP服务器和配置。管理目录的能力让他们方便地维护服务列表,及时添加和更新服务器。

配置管理功能支持实时读取及修改服务器运行参数,以满足不同AI应用场景的需求。利用内置的调用追踪与日志功能,开发团队可以精准定位接口调用异常,保障服务稳定运行。 MCP-Gateway的设计考虑了多租户和多客户端的需求,无论是单一AI模型单独使用,还是多个AI客户端共享同一套MCP服务器,都能高效支持。它既可以通过标准输入输出(stdio)进行通信,也支持基于TCP端口的流式传输,灵活适应不同的使用环境和网络条件。 搭建MCP-Gateway环境需要预装Docker Desktop并确保启用MCP工具包。对于开发者而言,只需克隆github仓库并按照文档使用make命令构建插件,即可快速部署自己的MCP网关。

平台无关的设计让它不仅适合本地开发,也可以扩展到云端部署,支持企业级的规模化应用。 安全性是MCP-Gateway的核心优势之一。其通过Docker的秘密管理以及OAuth多因素认证,打造了多层次的访问控制机制,显著降低了凭证泄露和未授权访问的风险。此外,容器隔离和权限限制为各个MCP服务器构建了沙箱环境,防止潜在的安全漏洞蔓延到系统其它部分。 未来,随着AI应用日益复杂化和多样化,MCP生态有望深度整合更多数据源和智能服务。MCP-Gateway作为中心枢纽,可能进一步增强其自动化配置能力和跨平台兼容性。

同时,提升对分布式系统的支持,将有助于构建更高效、可扩展的AI服务网格。 总结来看,MCP-Gateway提供了一种标准、稳健且灵活的方式,帮助开发者解决了AI模型连接外部服务时面临的关键问题。通过集中管理服务器生命周期、统一认证和安全配置,它为基于MCP协议构建的AI生态系统提供了坚实的基础。无论是初创团队还是大型企业,掌握并应用MCP-Gateway都能显著提升多服务器管理效率及系统安全性,为智能应用的创新提供强有力支撑。