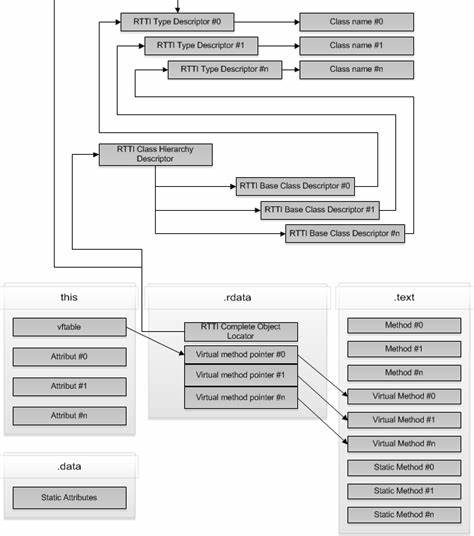

语音人工智能(Voice AI)和语音代理(Voice Agents)作为当今人工智能领域的热门技术,正在彻底改变人与机器交互的方式。随着大型语言模型(LLM)在会话能力和结构化信息提取上的卓越表现,语音AI逐渐在医疗、销售、客服、物流及中小企业电话接听等多种商业场景中发挥着日益重要的作用。2025年,随着多款先进模型的上市和音频处理技术的突破,语音AI的应用迎来了前所未有的扩展和深化。 首先,了解语音代理的核心机制有助于深入认识其运作原理。典型的语音代理由多个深度学习模型协作完成:从用户设备麦克风捕捉音频信号,通过高效的编码传输至云端,接着由语音识别模型(Speech-to-Text)将语音转换成文本,然后将文本输入大型语言模型进行推理,最后将生成的文本内容通过文本转语音(Text-to-Speech)模型转变回语音输出给用户。整个流程要求极低的延迟——理想语音对话的往返延迟约需控制在500毫秒至800毫秒之间,任何较长的停顿都会影响用户体验的自然度。

延迟优化是语音AI研发中的关键挑战。云端处理虽然能提供强大的算力支持,但网络传输、音频处理及推理计算本身都会产生不可忽视的延迟。针对这一问题,业内领先的解决方案往往选择将多种模型集群部署在同一高性能GPU集群,减少跨服务器通信开销,同时在推理过程中优先优化响应速度而非吞吐量。此外,合理选取托管服务或自部署方案,结合先进的边缘计算和精细的网络路由策略,可以显著降低音频往返的时间成本。 选用合适的LLM对提升语音代理性能至关重要。当前,OpenAI的GPT-4o和Google的Gemini 2.0 Flash是业内主流,因其在指令执行精度、函数调用可靠度以及低延迟响应方面表现优异而广受青睐。

Gemini 2.0 Flash更因其成本优势带来了市场竞争的活力,较GPT-4o低10倍的推理费用使得大规模部署更具经济效益。虽然一些开源模型如Meta的Llama和Ultravox提供了高度的自主定制能力及面向音频的本土化模型设计,但在综合性能上与顶尖商业级模型仍有差距,适合企业深度定制及隐私保护需求。 值得关注的是语音对语音(Speech-to-Speech)模型的兴起,这类模型绕过了传统的转录和合成环节,直接以音频输入输出,潜在优势在于延迟降低和语音表达的自然度提升。尽管目前此类模型在多轮对话语境理解及响应连贯性方面仍存在一定局限,但它们的发展趋势明显成为语音AI未来的重要方向。通过结合音频和文本混合的方式处理对话上下文,可以发挥原生音频理解优势的同时避免因音频上下文庞大带来的性能瓶颈。 语音识别模型在保证低延迟的同时追求高准确率面临着权衡。

市面上Deepgram和Gladia是被广泛采纳的领先方案,Deepgram以其优秀的低延迟表现和准确率赢得了美国市场主导地位,而Gladia则聚焦多语言支持和欧洲市场合规。相较之下,通用开源模型如Whisper虽广泛应用,但时延表现较差,难以满足实时对话需求。近年来,多家云厂商及创业公司不断推出更快的语音转文本API,促使生态日趋丰富。 文本转语音技术近年来同样经历了快速迭代。新兴公司如Cartesia、Deepgram、ElevenLabs和Rime在语音自然度、延迟及多语种支持上实现了突破。调节语音模型发音、情绪及韵律的能力改善了语音交互的人性化体验。

尤其是低延迟和文本语音同步的支持,让语音代理可以更加灵活地处理中断管理和流式合成,提升交互流畅度。此外,提供单词级时间戳支持的文本转语音接口成为追踪用户听到内容、维护对话上下文的关键技术环节。 音频处理技术是语音代理体验的隐形保障。高效的自动增益控制(AGC)、设备端回声消除、噪声抑制和主讲人分离技术保障清晰音频质量。尤其是Krisp等主讲人隔离服务极大改善了嘈杂环境下的准确识别率,确保语音AI能忽视背景杂音和非目标语音,实现精准识别。音频编解码选用Opus等低延迟高保真格式,结合WebRTC协议的实时传输能力,支持端到端的流畅语音对话。

良好的音频链路设计避免了网络抖动等问题对语音质量的影响。 在网络传输层面,WebRTC因其支持UDP基底、低延迟、多路复用和错误更正机制而成为实时语音传输的首选。相比WebSocket和HTTP协议,WebRTC避免了TCP固有的头阻塞问题和长连接管理复杂度,确保通话中断率极低。QUIC协议和基于QUIC的WebTransport技术正在逐步成熟,未来有望成为实时媒体传输的新基础,有效解决传统HTTP/3和WebSockets的不足。网络边缘路由和私有骨干网络的部署进一步压缩地理距离带来的延迟,为全球分布的用户提供更稳定高效的连体验。 转录端的语音活动检测(VAD)和语义感知的turn检测是决定对话流畅性的核心技术。

VAD通过检测语音/非语音信号切换,实现对话轮次的分段,但基于简单静音判断的方案容易出现早停或误中断。具备上下文理解能力的语义VAD以及利用深度学习模型识别语气、语速及内容完成度的上下文敏感检测正在快速发展。部分先进模型利用并行多路推理和LLM辅助分析,有效实现智能等待和回调机制,提升对话交互的自然度和用户满意度。 中断管理能力是语音代理另一项难点。用户可以随时打断AI回复,因此系统需确保模型推理进程和音频播放的即时停用,并且实现中断后的对话上下文准确衔接。这不仅要求VAD和输出流控制的精准协同,也依赖文本与语音输出的时间戳对齐。

优秀的解决方案采用分词对齐策略,确保上下文状态与用户实际听到的回复一致,避免错乱或重复,从而增强对话连贯性。 多轮会话中的上下文管理决定语音代理的智能表现。由于LLM是无状态模型,每轮推理时必须将对话所有相关历史传入。如何在保证上下文完整的同时控制长度避免超出模型最大上下文限制,是关键的技术难点。通过摘要、分段管理和上下文替换等技术手段,有效减少了推理计算压力。不同厂商API设计在消息格式、函数定义及系统指令处理上存在差异,对多模型兼容和代码维护提出不小挑战。

优秀的中间层框架如Pipecat,针对这些差异进行有效抽象,大幅简化开发过程。 基于LLM的函数调用在语音AI生态中扮演着核心角色。它使智能代理能与企业内部系统、API接口及电话技术栈进行无缝交互,支持订单查询、排班协调、DTMF音发送及通话转接等复杂场景。函数调用的可靠性、实时性和并发处理能力直接影响代理的实用性。异步函数调用和多函数并行请求的实现,为构建复合型工作流和长周期任务处理提供了技术保障。流式推理与函数调用的结合尚处于优化阶段,完善的调用分块和响应管理极大简化了开发者压力。

多模态AI让语音代理跨越纯语言边界,结合视觉、视频和音频输入,展现更丰富的交互能力。如观看和理解屏幕内容辅助操作、本地机器任务的语音指令控制等,让智能助手成为更贴近用户工作生活的“眼睛与耳朵”。不过,图像和视频上下文的高token消耗加剧了模型计算负担,如何在保证响应及时的前提下管理多模态大上下文,是当下研究热点。 在实际生产环境中,多个高性能模型的组合使用已成为行业标准。通过分别针对不同对话状态或任务细分模型,有效提高整体响应效率和准确率。结合异步推理、任务排队和多模型协作,满足AI守护内容安全、增强安全边界和防止提示注入的严苛要求。

内容护栏功能确保输出符合企业规范和用户期望,是大规模语音代理不可或缺的组成部分。 构建健壮的评测体系是维持语音AI质量的基石。与传统单元测试不同,语音AI评测需要模拟复杂对话、多用户交互及非确定性输出,采用统计学方法和自动化工具评估响应正确率、流畅度、延迟表现及异常处理能力。实时监听中断情况、转录错误和语音识别准确度的指标,对于保障用户体验尤为重要。已有多家评测平台与开源框架结合,形成了一套齐备的开发运维闭环。 传统电话网络仍是语音AI最重要的应用场景之一。

公共交换电话网络(PSTN)、信令协议SIP和按键音DTMF的无缝集成,使AI代理能顺利承接并处理大量来电,在呼叫中心实现高效自动应答与转接。AI代理极大提升了分流率和用户满意度,同时通过API集成实现老旧系统的数据联动和自动化。推动着智慧呼叫中心向更广泛的语音自动化迈进。 检索增强生成(RAG)和记忆机制,增强语音AI的长期记忆和业务知识访问能力。无论是会话初始时导入用户信息,还是实时查询知识库、库存及订单状态,RAG提供了灵活的外部知识补充。结合高效的向量检索和摘要技术,实现持续增强的会话背景。

超长历史、多模态数据的存储与管理需求催生出更智能的内容缓存与组织方案。 从部署架构看,语音AI代理作为长生命周期的流媒体服务,要求强大的网络支持和稳定的资源管理。高并发语音流的处理、容器化部署、自动伸缩、健康检查和优雅升级,都是生产环境必须面对的挑战。Kubernetes成为业界标准平台,为语音AI服务提供了灵活的扩展能力。云服务选型上,通常更关注运行时的低延迟保障和地域分布能力。成本方面,推理模型调用和语音API使用费用远超云资源开销,合理预算与技术优化密不可分。

2025年,语音人工智能领域将继续看到模型推理延迟的下降、多模态交互融合的深化和音频理解能力的提升。上下文缓存将更加智能,函数调用能力更加强大且稳定,语音代理不仅实现自然流畅的对话,更能完成复杂业务流程自动化。随着行业标准不断完善及生态更多元化参与,语音AI的商业化和个人化应用将迎来爆发,带来更加智能、高效的声控时代。